立委按:说深度神经三位先驱者坐了20-30年冷板凳,终于迎来了图灵奖。董老师坐了30多年冷板凳,还基本上是藏在深山人未识。《知网》未必不是一个图灵级别的对于人类认知的贡献。

詹:

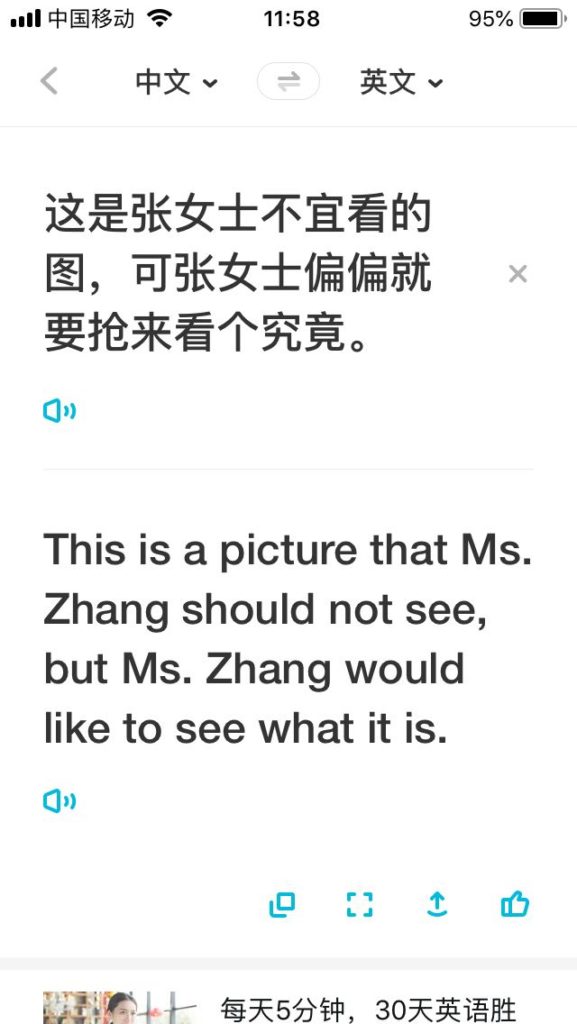

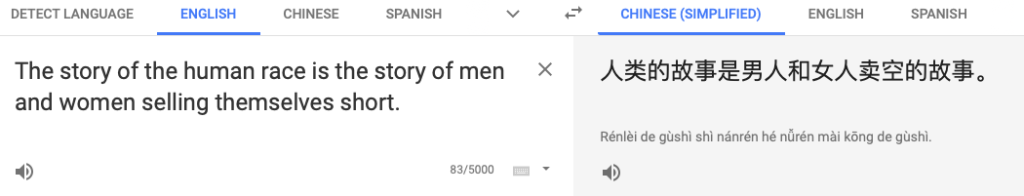

有道翻译太牛了!

王:这也太达意了,牛!

白:“张三为李四写了这篇论文而后悔不迭。”

看点:1、论文可能是张三写的,给李四当枪手,写了以后后悔了,也可能是李四写的,idea跟张三撞车了,张三后悔自己下手慢了。2、“为……而……”属于“套路”句式,即所谓“构式”,具有强搭配特性,优先级很高。3、一般性的“VP1而VP2”中,VP1与VP2在语义上要么高度平行,要么高度对立,既不平行又不对立的填入这个结构的优先级很低。一进一出,当枪手的解读式微,论文撞车的解读看涨。如果一定要表达当枪手的意思,要么把“为”重复成两个,要么把“而”去掉。话说,两个因邻近而重叠的小词缩合为一个,在语音上也是可以成立的,在无伪歧义的场合尽管用,但在有伪歧义的场合不占优。具体到本例,也就是“为+为—>为”这个动作不占优。或者说,虚增一个与后面“而”呼应的“为”,不足以对抗另一个解读。

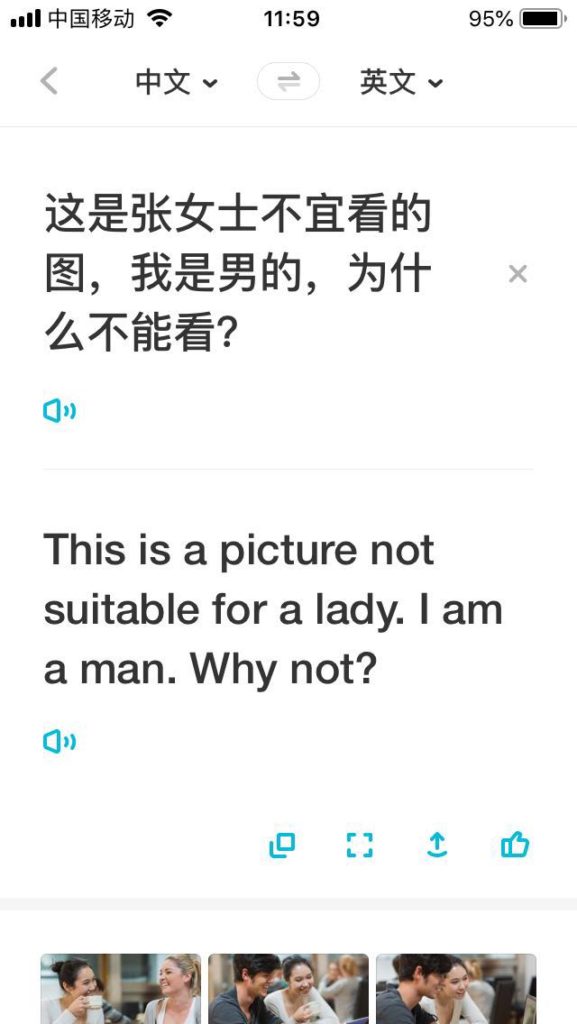

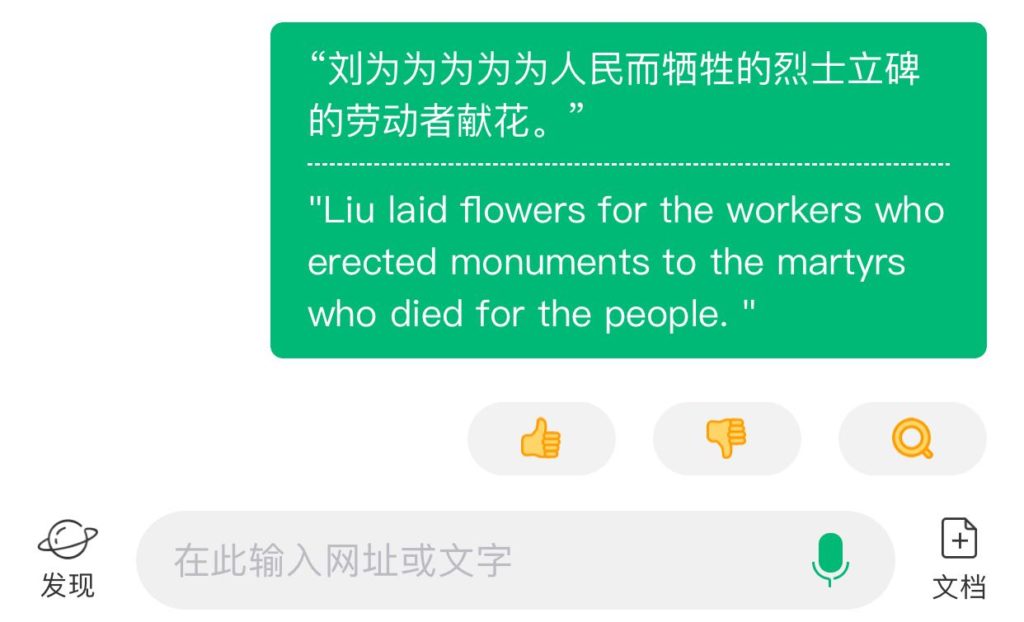

“刘为为为为为人民而牺牲的烈士立碑的劳动者献花。”

这个跟“一把把把把住了”有得一拼。

吕:神经网络是不善于数数的

白:

这个是枪手解读。前一个干脆不管几个“为”,意思到了,没人竞争,就他了。多出来的就当你结巴。不仅可以无中生有,还可以视而不见。

宋:三个介词连用,漂亮的嵌套:

第二家加拿大公司因被发现害虫而被从向中国运输油菜籽的名单中除名。

刘:第二家加拿大公司因被发现害虫而被从向中国运输油菜籽的名单中除名。Google翻译:The second Canadian company was removed from the list of transporting rapeseed to China due to the discovery of pests.

白:discovery不好

刘:结构都对了

白:那倒是。这个结构看起来叠床架屋,但其实不受干扰,是所谓“一本道”。discovery太正面了,单独看跟科学成果似的。放在这个语境里也对冲了负面色彩。

刘:要知道神经网络机器翻译是完全不用任何句法信息的,能正确理解这样的复杂结构,很神奇了

白:结构被编码了

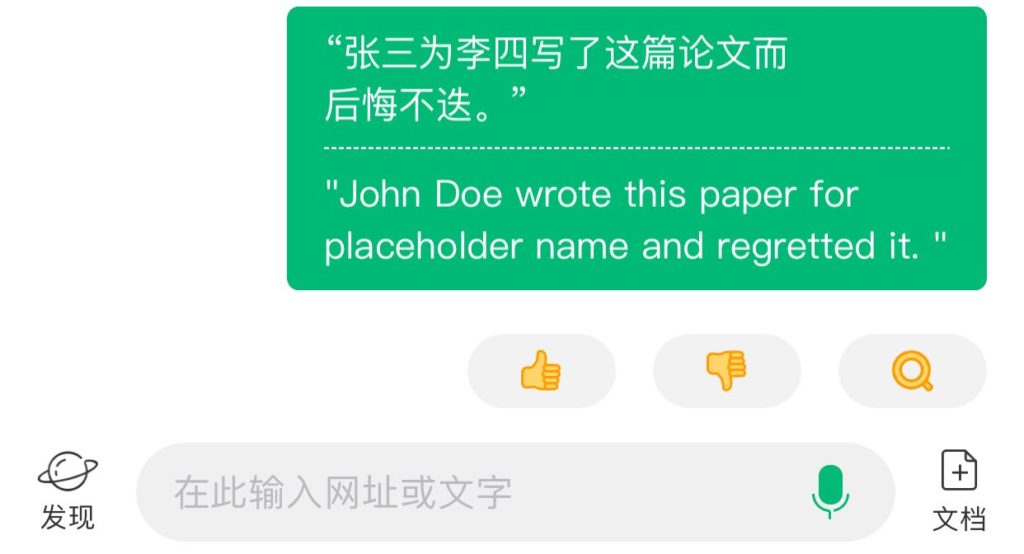

白:张三因被发现考试作弊而被从向欧洲派遣的留学生名单中除名 John Doe was removed from the list of foreign students sent to Europe after he was found to have cheated on a test --来自 @彩云小译

刘:张三翻译成John Doe,很有意思了

白:留学生一定是“foreign”?接受的是,派出的不是啊。这是有坐标系的,估计数据太稀疏,这些都顾不上了。一本道的嵌套就相当于parity,难不住神经的。这个found比discovery强。

刘:如果是Phrase-based SMT,这种句子应该是翻不好的

梁:

李:越来越多复杂结构句子,在神经MT翻译中居然对了,以前以为只有深度解析才有望解决的问题,居然在端到端,没有任何显式句法支持的情况下做到了。这种“奇迹”,连在神经第一线的@刘群 老师也不时赞叹。说明这里面的机理不是很清楚,尽管笼统说来,可以说是结构在大数据训练中被合适地编码了。

姜:这是个有趣的问题。非要有显式句法支持,才能翻译复杂结构句子,是一种想当然。

李:是不是“合适”编码了,也难说。因为一方面我们看到了一些翻译对了的”神译“,另一方面我们也看到一些神经过头的乱译。目前似乎也没有办法回答这个疑问:对了的和错了的,是不是共生的。大而言之,我们知道,起码目前的神经翻译,通顺是建立在损失精准(有时候简直到了张冠李戴、指鹿为马、视而不见和无中生有的严重程度)的基础上。还好,起码对于新闻、科技和日常用语等,所损失的精准虽然可能很严重,但频度还不是太高。

梁:科学的精髓 —— 敢于犯错误

李:疑问是,如果机理不清楚,所犯的错误就难以改正。是不是糊里糊涂一本帐,还是改进的目标还算清晰?是不是可以说,结构不是真正的坎儿,标注大数据才是。MT 让我们目瞪口呆的神翻译,似乎已经部分证明了,复杂结构是可以被标注大数据“编码”的。

白:机译可不可以做得更好,我兴趣不大。我更关心各种场景化应用,机译这条路线是否走得通。按正确的结构标注大数据,意思就是,what由人工解决,how由智能解决。how又分两种,一种是歧路,一种是伪歧义。对付歧路,不需要人工。对付伪歧义,必须人工。对付歧路,强化学习、自我标注就够了。

李:NMT中的伪歧义表现在哪里呢?

白:比如上面例子的“留学生”。在不同语境下对齐的词汇不同,但向外派遣,就不该是“foreign”。

李:不仅仅是 NMT,这个一错就可能错得离谱的问题是普遍性的,图像和语音中都有这个问题。what由人工解决,how由智能解决。这种说法是想对神经与结构进行“紧耦合”。不是没人想做,但总体上迄今还是一头雾水。这两个冤家不容易往一起捏。

白:“我是县长派来的”就是歧路不是歧义。全局解唯一,暴力搜索一定能得到。但是暴力搜索的目的是做正确的标注。实时解析策略是通过标注数据训练出来的。紧耦合无所谓,因为神经的那一半压根儿就不需要人工干预。归根结底还是what不给力。

李:what 从语言结构的角度,是有共识的。起码语言学家对于一个句子的依存结构,分歧并不大。如果分解为二元关系,分歧就更小了。分歧多表现为“如何”得到这个结构,而不是这个结构是什么。尤其是 PSG,如何得到决定了树的不同。到了 DG,“如何” 的影响明显减弱。从逻辑语义角度看,what 是有共识的,有很强的确定性,大同小异的。

白:好像不见得。比如“咬死了猎人的狗”公认有歧义,“咬死了猎人的羊”有没有歧义,语言学家未必分歧就小。如果语言学家的共识是后者也有歧义,那就洗洗睡吧,NLP肯定指望不上了。

李:说共识与否,还是要有个量和频度的概念吧。

白:标注即投票?神经的强项就是拎得清此时此刻的力量对比。让语言学家投票,未必拎得清。

李:找个例,很容易忽视量和频度。就说 “咬死了猎人的羊” , 粗分一下,是三个实词(“咬死” 算一个词):咬死(A)了 猎人(B) 的 羊(C)。看看 ABC 之间发生的二元关系,哪些是共识,哪些有疑问。AB 动宾 这是一个二元关系(候选),算是共识。AC 是定语关系,也算是共识;BC 是定语关系候选,也是共识。AC 动宾候选,也算是共识。

白:等等。这里,what必须表达“候选”。如果没有这个表达能力的what,必须靠边了。这在语言学家中也不容易达成共识。

李:总之,即便是个例,如果细分下来,共识的部分还是占多数。如果与常态化语言表达法平均一下,可以说,语言结构没有多少争论的空间。

白:这个平均,在长尾面前无意义。

李:我觉得 问题的关键不在 what 不清楚,需要在 what 上再有突破。关键是,已经知道的 what,也没有有效的办法被神经利用和吸收。两年前遇到刘挺老师,谈到这个问题,问神经这条道,啥时可以利用句法或逻辑语义。他直摇头,说不好办。不是一条道上跑的车。

白:光说动宾不行,光说动宾候选也不行。如果说,句法就送你到这儿了,剩下的看造化。这当然不行。必须把所有的资源摆在那儿,让神经去选。语义的,情感的,事理的。这也是很多语言学家不具备的。可以设想,如果有一个可供神经对接和挑选的“知网”级别的基础资源,局面会大有不同。

李:唉,送上门也未必有人有兴趣 and/or 有能力去用。看吧,看今后五年。今后两年 神经还可能往上走,很多人有这个信心,所以没有兴趣是主因。今后五年,那就是能力的问题了。

白:还可以设想,如果标注人员戴上一种设备,就可以通过追踪眼动或者捕捉神经信号获得标注,语言学家真的彻底不需要了。

李:说深度神经三位先驱者坐了20-30年冷板凳,终于迎来了图灵奖。董老师坐了30多年冷板凳,还基本上是藏在深山人未识。《知网》未必不是一个图灵级别的对于人类认知的贡献。就是用起来殊为不易。

白:可惜董老师不待见神经,也不待见图谱。

李:知网就是本体常识图谱。不待见神经 倒是真的。知网与图谱的距离,最多是工程层面,本来可以有一个更好的实现与接口。

白:不是的。事理的层面,知网超越市面上的图谱。工具的层面,知网弱于市面上的图谱。

李:对呀。多数图谱很肤浅,没法望其项背。

白:此外还有一个适配的问题。各种可用资源参与力量对比,必须折算到统一的度量。知网没有这个度量。分析器玩的就是力量对比。神经倒是未必一定要有,但统一的度量一定要有。

正解压制伪歧义的依据,修辞用法压制一本正经的胡说八道的依据,就是包含词法、句法、语义、语用、情感、事理在内的各种力量的综合对比。首当其冲的,就是把各种力量经过折算放到同一个平台上来。把资源捂起来,只留下标记,不仅没有资源的人学不到真货,有等价资源的人也得连蒙带猜。这资源是what的应有之义。

李:把结构扁平化(譬如嵌套表层化}和原子化(譬如分解为二元关系)变为特征 对于深度学习 没有多少吸引力。如果不简化 也不知道从何入手。

白:结构的嵌入可没这么肤浅。向神经要潜力的话,表示(what)没什么好做的,把功夫下在控制(how)吧。表示就是语言学家、领域专家、知识工程师自己的事儿。另外,就数学本质来说,符号串的代数基础是幺半群,神经的代数基础是矩阵(线性变换群)。这两个群都是非交换的,深层次里有互通的基础。所以嵌入结构是正常的。

宋:@白硕 向神经要潜力的话,表示(what)没什么好做的,把功夫下在控制(how)吧 这个观点我挺有兴趣。能否详细阐述?谢谢,@白硕 我最近一个理论是大脑除了基于矩阵的目前人工神经网络用得多的系统,还有一套控制系统。所以也许能把几何和代数统一起来。

白:可用的资源、输入输出都是符号表示,中间的计算是神经表示。输入是符号序列,输出是操纵符号的动作。有些动作是有副作用的,需要记忆。操纵符号的动作改变符号,类似“重写”,但是不限于“重写”。当你输出一个dependency link时,符号之间的邻居关系改变了。

宋:Causal Reasoning from Meta-reinforcement Learning,我最近看到这篇 arxiv 上的文章比较有趣。我在想 control 这边也许可以放到一个 meta-reinforcement 的框架里面最终去解决。

【相关】