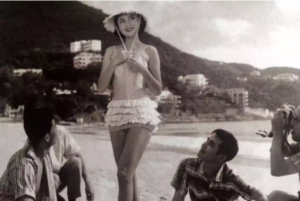

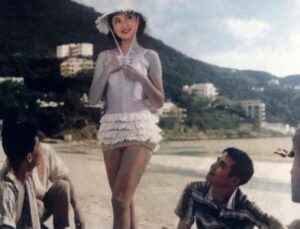

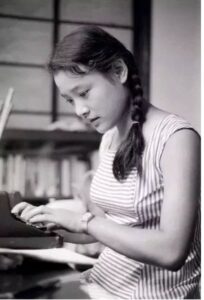

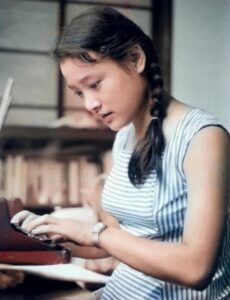

最近玩自称经过大数据训练的智能人脸上色的软件(colorize app),把收集到的黑白照片一股脑送进去试验。看黑白时代的亲朋旧友的留影,一个个突然鲜活起来,让人惊喜。分享给老友怀旧,大家都感觉很神奇。先看看当年的女神夏梦的彩色还原,还有小花陈冲。对了,还有光彩照人的绝代风华奥黛丽·赫本。

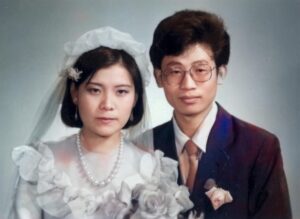

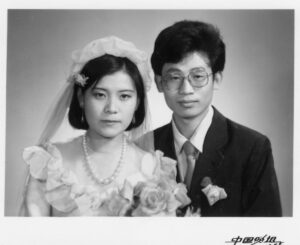

不要看胳臂和腿,还有手,彩色背景下跟乌爪子似的。这个软件专注人脸上色,还没顾上其他。人脸上色还是很到位的,不温不火,非常自然。我当年的黑白婚照也重放光彩了哈:

记得在黑白时代,照相馆里面有为照片上色的服务。一切全手工制作,描眉画眼,粉腮白肤,总是透着一种假,根本不如电脑上色的圆润自然。

这是什么黑科技?答曰,这是大数据时代人工智能的拿手好戏。“无中生有”的极致,乃是大数据AI的特长。

前两天看【新智元】的两篇报道,均配有样例图示。第一则是《杜克大学:AI工具精细还原模糊图像,可瞬间将分辨率提高64倍》。

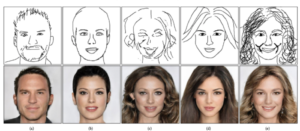

第二则是《中科院DeepFaceDrawing:只需提供小学生水平的简单线条,便可生成逼真肖像》。

老友说:这个太牛了,警察可以根据画师的画大大缩小搜查范围。没摄像头的地方,只有有人看到嫌疑人,都可以用到这技术。

将来的应用可能是这样,根据目击者得来的简单素描,通过参数设置,生成一系列清晰图片,唤起目击者的记忆和印象,从中选择最近的那张。所谓脑补,或曰想象,大抵如此。

以前一直有个误解,以为“想象”、“脑补”(包括通过常识、场景知识和专业知识进行脑补)这种东西是人工智能不可企及的区域。这种东西是不大容易说清楚的,是知识的积淀,经验的积累。传统的符号派人工智能也做过尝试(譬如建立巨大无比的常识库如 cyc,试图施行常识推理),但是终归是太繁复,灰色地带大,缺乏确定性,效果和效益都遭遇挑战。没想到如今大数据与人工智能的结合,特别是深度神经网络技术的突破,为这些东西打开了一扇奇迹般的大门。无中生有不再是美梦一场。

做过常规音影处理的同学都知道,高清度的对象降低维度(譬如从彩色降到黑白)到低清度,没有任何问题,因为信息是处于减少的状态。但逆过程就是挑战,因为需要“无中生有”。 这个挑战以前认为是不可克服的,巧妇也难为无米之炊呀。再大的魔术师也不能真正地无中生有吧?你看他台上从空盒子里面变出一只鸭出来,你心里明白那是假的。这只鸭子肯定是藏在哪里,魔术师用了障眼法,把观众唬住了而已。物质不灭,无中生有是绝对不可能的事情。魔术师自己也承认:魔术都是假的,各有巧妙不同。可人工智能的魔术却不是假的!

关于无中生有,AI老司机老毛说:其实也没那么神,数学上就有外推和插值,还有凭经验猜测,甚至可以随机插值。

这才叫知者不神,神者无知,hence 科普。人在无知的状态中,是很容易神化对象的,这是人的本性,否则人没法解释,也感觉不安。人工智能历史上有个现象,说的就是人对未知的神化,叫“伊莉莎效应”( 拙文《反伊莉莎效应,人工智能的新概念》有介绍)。古往今来所谓奇迹,大多是常态的神化。反过来,也不能因为AI从业者时刻在创造或大或小的奇迹,就失去了庆祝的欣喜。每天面对屏幕中自己创造的奇迹,体验无中生有的上帝般的自由,也是人生一乐。我们走在无尽的大路上,由必然王国逼近自由王国,虽不能至,心向往之。

抒发完职业豪情,回头细看无中生有的背后。物质固然不灭,可观念世界似乎有所不同,更富弹性。然而最大熵定律仍然决定了,信息世界只会越来越趋向混沌,而不是反过来变成清晰。信息补漏是需要资源和能量的,从哪里来的呢?三个字,大数据。当然,光有数据,没有AI能力也不行。这是大数据AI的时代。

孤立地看一张照片,模糊转清晰,黑白转彩色,没有可能凭空而来。但是,有了大数据就不同了。而且这种大数据是天然的“带标数据”(labeled data)。以前说过,机器翻译大数据是天然带标,因为有人类翻译的历史积累。因此特别适合做端到端(end to end)的深度学习,所能达到的翻译质量,比很多学了好多年外语的人的翻译还要通顺得多。现在遇到的这个场景是另一类“自然”带标大数据的端到端场景。无论黑白转彩还是模糊转清晰,所有这些需要“无中生有”的应用场景,都有一个共同特点,就是可以对于大数据对象做“反操作”,从而把自身变成无穷无尽的带标大数据。一切都是全自动的,不需要人工标注,这是多么理想的大数据学习应用场景,不出奇迹也难。把收集到的彩色照片,一锤子全部砸成黑白,端到端的对应就建立起来。剩下的就是拟合了。

这种学习出来的无中生有,会有问题吗?当然有。第一是方向可能偏了,“还原”出来的东西与心目中的印象产生或大或小的距离。第二是趋同,大数据的统计本性,结果是中庸化了。如果原来的对象有独特的特征,大数据脑补是很难还原出独特性的。

对于第一个问题,解决办法前面说了,可以通过某种参数,或者通过某种随机因素,生成一系列候选,而不是唯一的结果,总会有一款比较接近你的想象、记忆或原物。对于第二个问题,其实可以通过大数据的定向化来逐步解决。譬如专门对亚裔建立大数据,专项处理亚裔图像还原的工作。同理,还可以把南方人北方人分开训练。

无中生有的工作,我们20年前就开始做。当年给罗马实验室做项目,遇到的一个难题是历史文献都是全大写。我们的自然语言引擎见到大写,常常当成专有名词了,质量是断崖式下跌。当时,很多 teams (包括 BBN)组织力量标注大写的文献,然后重新训练系统。而我的团队与 IBM 是第一个差不多同时决定不为信息抽取的目标做重新训练,而是先训练一个大小写还原的前处理器。结果整体质量大幅度提升,虽然当时还没有深度学习,用的是传统的机器学习。这是因为恢复大小写的工作可以做得很好,有几乎无穷的自然带标的训练数据(同样是利用大小写规范的文档一锤子砸成全大写)。

至于符号派经典机器翻译中无中生有的故事,上次的科普《语言形式的无中生有:从隐性到显性》已经介绍过了。那根本没用机器学习,但是也还是可以通过蛛丝马迹“无中生有”地生成欧洲语言的形态(形态生成)。那个无中生有的原理不同,依靠的是源语言(中文)文字中的信息冗余,外加语言习惯里的种种 heuristics (表达的习惯性总结),有时候还要加上一些类似“常识”的概念相谐的“脑补”。但老式符号机器翻译中的无中生有终归感觉很吃力,“功耗”很大。在无中生有这个课题上,不得不说,对于任何具有源源不断天然带标大数据的场景,还是大数据深度学习的路子最为强大。深度学习一统机器翻译天下,说明了大数据AI的压倒性优势。同理,图片还原也必然是大数据AI的领地,我们会看到越来越多的应用。可以预见,黑白电影时代的佳作,最终可以自动还原为彩色。

【相关】