立委按:逢年过节必有新事儿。去年元旦春节那一会儿是闹腾CoT强化推理,DeepSeek 开源推理模型推动了大模型后训练的范式转变。今年梁文峰他们元旦又“闹事”了,但不像CoT那样直观。这次说的是 mHC,听上去就显得高深。值得拆解一下。

DeepSeek 这次的 mHC 论文,第一眼读上去确实有点“技术密度过高”。但它要解决的其实是一个非常朴素、也非常关键的问题:我们能不能在不牺牲训练稳定性的前提下,把模型内部的信息通道修得更宽? 要看懂这件事,得先回到深度学习的一段“地基史”。熟悉神经网络历史的都知道,残差的发明是深度神经能 work 的关键,从而为深度学习革命打稳了基础:就是用 x+f(x) 代替 f(x),来保证多达几百上千层的网络,不至于在不断加深的转换中“差之毫厘,失之千里”,从而稳住训练。 但这里有个“硬核”的底线经常被忽略:残差之所以是残差,不是因为它“加了一条支路”,而是因为它把恒等映射当作守恒机制替深度训练兜底。大模型本质上是一个可编程的函数逼近器,把输入 x 变成输出 y=f(x);而深度一旦上去,你不是在学一个函数,而是在学一串函数的复合。任何一点“不守恒”的东西,都可能被深度放大成数值灾难。残差里那条直通的 x,就是大模型的定海神针。 mHC 的故事,就从“想把这根定海神针加粗成多车道高速,但又不能把稳定性一起赔进去”开始。

把残差从“单车道”扩成“立交桥”

新年第一天,DeepSeek 在 arXiv 放出一篇相当“硬核”的论文:mHC: Manifold-Constrained Hyper-Connections,时间戳是 2025 年 12 月 31 日(v1)。arXiv

作者列表里,除了三位一作(Zhenda Xie、Yixuan Wei、Huanqi Cao),还出现了神龙见首不见尾的传奇人物 Wenfeng Liang(梁文锋)。arXiv

这篇东西技术性蛮强,但它在解决的,其实是一个很“基础设施级”的老问题:深度网络到底靠什么才能越堆越深而不炸?

01|从残差的“定海神针”说起:为什么 x + F(x) 让深度网络能 work

熟悉神经网络里程碑历史的都知道,残差(Residual / Skip Connection)的发明,是深度神经网络能 work 的关键,从而为深度学习革命打稳了基础。何凯明/张祥雨也因此成名;那篇残差论文的引用数,据说在 AI 历史上是绝对的首屈一指。

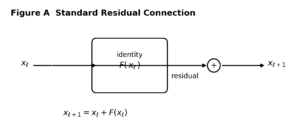

这是一项发生在十多年前、深度学习革命刚刚开启时,他们在微软做出的里程碑工作。后来,它成了深度神经网络的标准 practice:用 x+f(x) 代替 f(x)。这条看似朴素的改动,恰恰是为了保证多达几百、上千层的网络,在不断加深的(函数)转换中不至于“差之毫厘,失之千里”,从结构上兜住训练的稳定性(那条 x 的直通路径,本质上就是恒等映射的安全绳)。

我们知道,大模型本质上就是个图灵机:在足够的容量与数据驱动下,它可以规律性地把任何信号输入 x 变成任何其他信号输出 y,也就是实现某个 f(x)。这就是所谓的万能函数近似——老母鸡变鸭的魔术:文生图、机器翻译之类,看上去神奇,背后都是“把 x 变成 y”的系统性变换。正是在这个意义上,残差网络(ResNet)里 x 这条直通连接线,成了大模型的定海神针。

因此,ResNet 的核心不是某个更复杂的卷积,而是那条看似朴素的“直通线”——让每一层学习 F(x),但输出是 y = x + F(x)。原论文把这种 直通车道(shortcut) 设计解释为“identity mapping”,它让信息可以跨层稳定传递。

你可以把它当作在深度网络这个“层层加工的工厂”里,额外修了一条不加工作业、直达下一站的传送带。于是深度从几十层堆到几百层、上千层时,也不至于在复合变换里越走越偏,最终训练崩盘。

ResNet 把每一层从“直接学一个函数”改成“学一个增量”。这就好比雕塑大师把人物雕塑工作,转变为“去除多余的部分”。一块大理石,多余的“残差”去除殆尽,人物自然就成型了。

这件事的关键在于它把恒等映射(identity mapping)塞进了网络:哪怕 F 学得一塌糊涂,x 这条直通路径也能把信号和梯度比较完整地送到更深处,从而让几百上千层不至于“越算越跑偏”。mHC 论文在引言里也把这点讲得很直白:残差的稳定性,来自恒等映射跨层累积时的结构性保障。arXiv

作为研究背景,一句话总结残差的精神内核:

让网络“可以很深”,靠的不是每层转换多聪明,而是“永远留一条不作妖的直达通路”。

02|单车道不够了:HC 把残差流“扩建成多车道”

传统残差是一条残差流(hidden state 的那条“主干通道”)。但当模型越来越大,研究者会自然产生一个念头:

-

-

-

既然残差流像高速公路的主干,

-

那我能不能把它从 1 条车道扩成 n 条车道,

-

让信息在不同车道之间更自由地交换、混合,表达力更强?

-

-

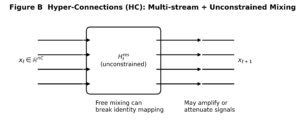

这就是 Hyper-Connections(HC)这类工作的出发点:把残差流的宽度从 C 扩到 n×C,并引入一个可学习的混合矩阵,把“各条车道”的信息在每层重新路由。在 HC 原论文里,核心机制就是这种“复制 n 份 residual path、再在它们之间做连接”的宏观结构。

到这里为止,一切都很美:

路修宽了,车更多了,理论上吞吐更大、信息更丰富。

但问题是:你把高速路扩建成多车道,最怕的不是车多,而是没有交规。

03|HC 为什么会炸:无约束矩阵跨层复合变成“放大器”

残差之所以稳,关键是 identity mapping 这条线天然具备一种“守恒”味道:

你至少能保证有一部分信号,不被层内变换“瞎折腾”(带偏)。

但 HC 的混合矩阵完全自由学习、没有任何约束,跨多层之后,实际上是在做一串矩阵连乘。mHC 论文直说了:HC 的这种无约束设计在大规模训练时会破坏 identity mapping 作为“conservation mechanism(守恒机制)”的角色,导致平均信号强度无法保持,从而出现无界放大或衰减。

更直观地讲这种“放大器效应”就是:

-

如果某几层学到的“残差”在某些方向上“略大于 1”,

-

经过几十层、上百层复合后,增长会呈指数积累,

-

最终就是大家熟悉的两种灾难:信号爆炸 / 梯度爆炸,或者相反:梯度消失。都是模型训练的灾难。

不是 HC 多车道思路不对,而是它把原残差网络自带的这根“定海神针”,拆成了“自由的放大链路”。

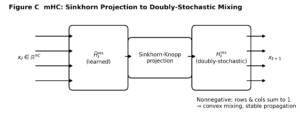

04|DeepSeek 的一招:把混合矩阵关进“双随机”的笼子里

mHC 的核心思想可以一句话概括:

你可以修立交桥、修多车道;但负责“指挥交通”的矩阵,必须服从一套严格的守恒规则。

他们选择的规则是:把残差约束到所谓 双随机(doubly stochastic / bistochastic)矩阵集合上——元素非负、每一行和每一列都等于 1(归一化)。

这样做带来三层非常“工程友好”的稳定性保证:

-

-

-

凸组合(convex combination)解释

因为行列和为 1,残差等价于对输入特征做“加权混合”,但权重总量守恒,所以整体更像“搅拌”而不是“放大器”。 -

均值守恒 + 范数被严格规整

论文明确说:这种约束让特征均值保持、信号范数被严格 regularize,从而缓解 信号爆炸/消失(vanishing/exploding)。 -

跨层复合仍然稳定(乘法封闭性)

双随机矩阵相乘仍是双随机矩阵(非负性与行列和约束都能传递),因此“多层连乘”不会越乘越野,守恒性可以贯穿整个深度。

-

-

翻译成咱老百姓的话就是:

每一层的混合矩阵,本质上像是在“若干种换道方案(置换)”之间做概率意义上的加权选择。这就特别像一个“带守恒约束的交通路由系统”:怎么换道都行,但总车流不能凭空变多或变少。

另外,mHC 还对前后残差引入非负约束(论文用 sigmoid 形式实现),避免正负系数复合导致的数值抵消行为。

05|把“野矩阵”投影成“双随机矩阵”

“利用 Sinkhorn-Knopp 算法将连接矩阵约束在双拟随机矩阵流形上”,这里的核心是这一步:

-

-

-

先让矩阵元素变成严格正数

-

然后反复做两件事:

-

归一化每一行(让行和=1)

-

归一化每一列(让列和=1)

行列交替迭代,最终收敛到双随机结构。

-

-

-

你可以把所谓 Sinkhorn-Knopp 过程想象成一个“交警训练营”:

不管你原来学出来的“交警”矩阵多么放飞自我,进训练营一套队列动作做完,它就必须满足“行列守恒”的硬纪律,才能上岗指挥交通。

关于“流形”(manifold)这个术语,可以这样理解:

严格说双随机矩阵集合整体是个凸多胞形(边界有棱角),但在其内部(所有元素严格正)可以视为一个受约束的光滑空间;论文在工程语境里用“manifold”来表达“我们不让参数在整个欧氏空间乱跑,而是限制在一个有几何结构的可行集合里”。

06|它不仅是数学,更是工程:6.7% 的代价换稳定与收益

把残差流扩成 n 倍,直觉上显存与通信都会爆炸。mHC 论文非常明确地把“系统开销”当作同等重要目标:它不仅提出数学约束,也在配套工程上做了 kernel fusion、选择性重计算、以及在 DualPipe 调度里更激进的通信-计算重叠。

最后他们给出的系统级结论是:当 n = 4 时,mHC 只带来约 6.7% 的额外训练时间开销。

这点很关键:

如果只讲“理论上更稳”,我们会问“那是不是贵得用不起?”

而这篇论文显然在回答:“我们把它做成了大训练里可落地的结构升级。”

07|一句话总结:mHC 的创新意义在哪?

HC 想把残差从单车道升级成立交桥;mHC 做的,是给立交桥加上守恒型交通规则——用双随机约束恢复 identity mapping 的稳定性,同时把工程开销压到可接受范围。

这也解释了下列对应关系:

-

残差的多流并行架构:残差流从 C 变成 n×C,让“通道”更多;

-

连接矩阵受约束:核心是残差不再自由,而是双随机;

-

Sinkhorn-Knopp:实现“投影/归一化”的具体算法;

-

解决数值不稳定与信号爆炸:把跨层连乘的放大链条关进“守恒笼子”

残差之所以稳,不是因为“加法神奇”,而是因为它隐含了某种守恒结构;

当我们试图把残差升级成更复杂的拓扑时,真正需要被继承的,是这份守恒,而不是加号本身。

李老师深入浅出,太赞了,祝新年快乐

我在想mHC的应用场景:

1. 是否可以使得多模态理解更准确?例如:可以跨时长去理解视频、语音和文本?

2. 模型自己的多步推理是否可以跟有连续性?例如一个50步的推理是否可以逻辑上更连续?