噩耗传来,人还在路上,深为震惊,感觉脑袋嗡嗡的。当时我刚下高铁,是我老爸最先传来的消息,比各群都早。老爸肯定是关注了中文信息学会的。他也常听我谈起过董老师。

老友尼克提议我写纪念文章。追随、受惠于先生三十载余,心中的怀念,千头万绪,从哪儿说起呢?

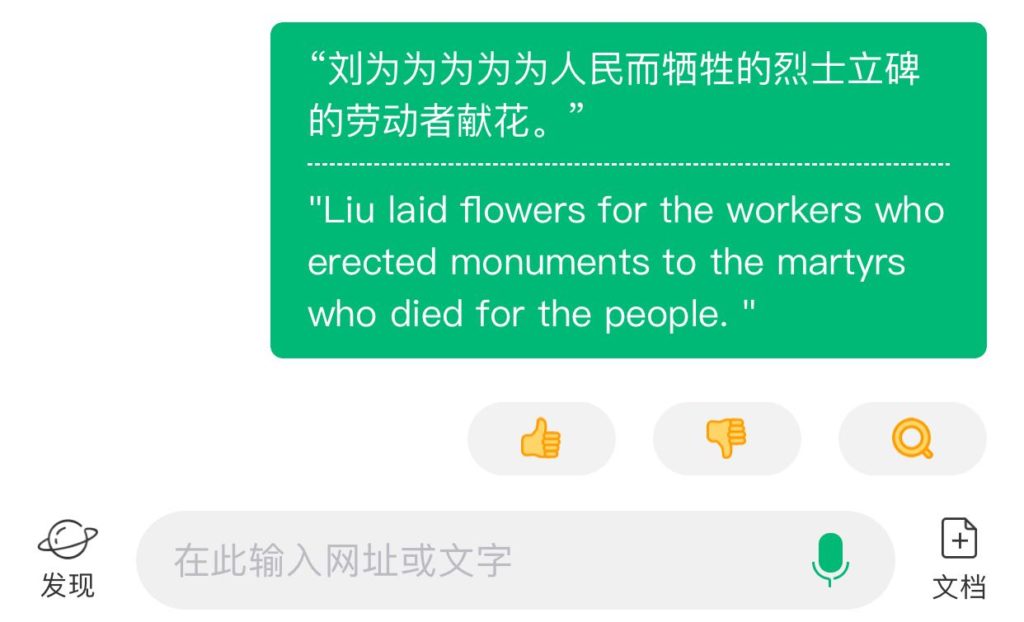

89风波后不久,第二届机器翻译高峰会议在德国慕尼黑举行。我代表刘倬老师在会议上介绍了我们的翻译系统,董老师也到会。会后,我们应邀去荷兰BSO公司的多语机器翻译小组,参加他们的 Chinese week,讨论把中文加入到他们多语计划中的议题,以及探讨中文处理的挑战(见《朝华午拾:欧洲之行》)。

很多年后,董老师给我来信说,孩子们整理老照片,翻出来一张在荷兰的合影,感觉很珍贵。Witkam 就是照片上的BSO项目组长,当年是他从欧共体争取到机器翻译项目的基金,BSO公司 match 另一半,这才成就了他们以世界语为轴心语言的多语言机器翻译项目的五年计划。其中的中文部分就是我为他们做的依存关系文法(我的《朝华》系列有记述【一夜成为万元户】:全是纸上谈兵的一套,但也勾画了中文形式化的雏形(见:【美梦成真通俗版】)。当年董老师对我的这个工作赞许有加。

我也回寄了一张在高立公司一起做机器翻译项目期间的临别合影。高立公司那段是个机缘,我得以与董老师在地下室改造的办公室相处几个月,亲聆教诲。

那是 2013 年四月,董老师回信说:

谢谢。对我们而言都是非常珍贵的照片。那年我已54岁,但体力脑力还不错。又一个20年过去了。我还在想再挑战自己一把。至少我会把我们的基于HowNet的机译系统,一直做下去,看看最后会到一个什么程度。上次回去领奖时去看望了刘老师,他提及所里建议他还是再带学生。他觉得没有课题,经费不好弄,他没有应承。我回来想了想觉得他也许还是干点什么好。也许会开出个什么新天地。

我想你一定很忙,刚回来。Kaplan我已写过信了。他没有回信,只是把我的信转给了Weiner,即当年Microlytics的经理。我向他们解释了那年的事情。他们也就理解了。我也算放下了。

最近接到学会来信,2013年的计算语言学大会,看了他们的征文内容,觉得想说点什么,等我写了,也给你转去,供参考。

家里热闹了一番吗?女孩大了,不好太管。

振东

上周问过你Ron Kaplan的email地址,你知道吗?那年他还是在Micolytics时,我在中软曾与他们经理谈过一个很好的生意,可惜被六四给搅黄了。当时还没有法子跟他们解释。我一直觉得过意不去。

我的回复:

2013/4/27 <[email protected]>

>>谢谢。对我们而言都是非常珍贵的照片。

我把这张照片还有其他一些老照片加入了博文《看望导师刘倬先生》。

>>那年我已54岁,但体力脑力还不错。

那应该是 HowNet 的酝酿阶段,记得您当时提过几次设想。

>>又一个20年过去了。我还在想再挑战自己一把。至少我会把我们的基于HowNet的机译系统,一直做下去,看看最后会到一个什么程度

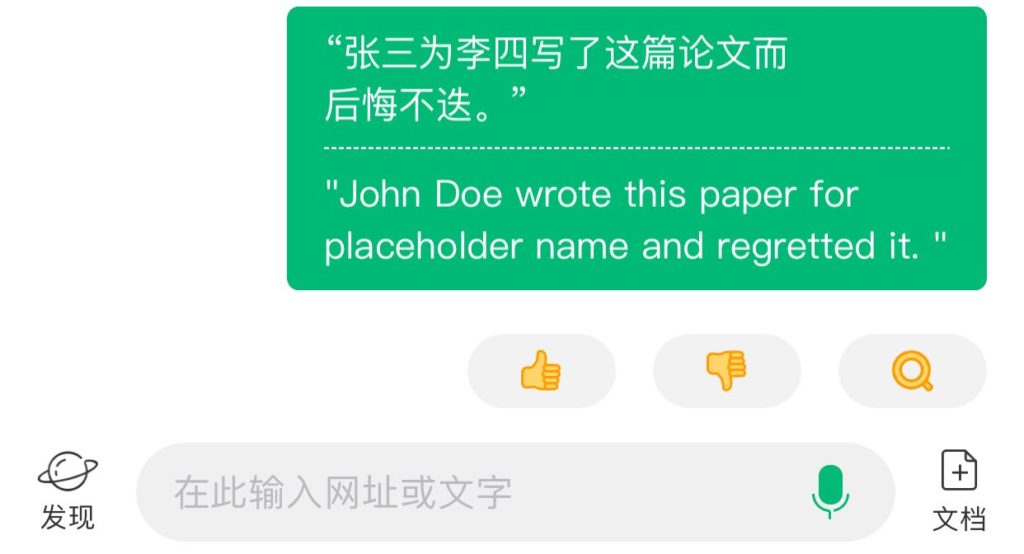

上次您提到可以用一些细致分类去解决结构歧义(PP-attachment 类的问题)。也许仔细做是可以的,但是我觉得结构歧义的根本出路不在人工的 taxonomy,而在统计:因为结构歧义说到底是三角恋爱,最终谁与谁结合决定于语义拉力的相对力量对比,而这种AC与BC相对的拉力是无法事先计算出来的,因为有太多组合的可能性。但是,AC 或者 BC 各自的拉力是可以通过大数据事先学习出来的(本质上是 lexical coherence acquisition)。只要有一种机制让这种统计信息在结构歧义的现场提出来做对比,理论上可以解决这个问题。这比用细致的语义features去人工调试应该有效合理一些。

事实上,这种机制目前已经可以实现。当然实现起来还有些繁杂,代价还需要考察。

>>。上次回去领奖时去看望了刘老师,他提及所里建议他还是再带学生。她觉得没有课题,经费不好弄,他没有应承。我回来想了想觉得他也许还是干点什么好。也许会开出个什么新天地。

这次看望刘老师,感觉还是苍老、迟缓很多。估计他也没有足够力气了。我理解您的意思,搞了一辈子科研,即便退休,最好也别完全停下来,除非有别的爱好。可惜的是,我们很多人除了做系统,都没有什么其他爱好。退休生活容易寂寞。

再谈

学生:维

与董老师长达30多年的交往,除了生活上的问候外,我们谈的最多的还是专业。董老师是性情中人,富有幽默感,常让人忍俊不禁。记得当年谈到他的译星,董老师说那才真正是自己的孩子,呕心沥血的结晶。接着笑道:儿女不算,为啥?那是“自然灾害”的结果。可是很多年以后,他又跟我说到孩子的话题,希望我有机会带董强一起干,列举自己孩子的优点缺点。最后不忘补一句,自己的孩子,瘌痢头也是好的。

在中国机器翻译的历史中,我的导师是开创者:刘涌泉老师1957-1958年开始组建团队,从外语学院挖来了刘倬老师,还有一位早逝的高祖舜老师,1959年第一次实验成功,三人后来合著《机器翻译浅说》一书(日本从事MT研究的时候作为主要参照,译成了日语)。董老师应该是60年代的某个时间点,作为黑龙江大学外语系的老师,参加了两位刘老师的MT项目。董老师对两位亦师亦兄的刘老师非常尊重,去年还跟我提到不久前曾分别去看望两位,表达敬意。

董老师青出于蓝,后来在军科院率先把MT落地为开放型软件,成为中国MT和NLP的领军人物之一。从国际交流来看,董老师在很长的时期是中国NLP的大使,是与国际学界的接口。

当时,董老师从军科院的“科研一号”实用开放型英汉机器翻译原型系统,到中软真正落地,推出第一款商品化软件“译星”(TranStar),给当时全国近十个MT团队做出了榜样:MT 可以走出实验室。

与董老师同期推出的还有一款“非主流”系统,是工程师出身的刘孝叔先生编制的,也放到中关村橱窗上卖出去过几套,但影响小多了。刘孝叔先生的故事,以前在这个群里作为掌故说过(见【把酒话桑麻,MT 产品落地史话】)。

译星是一个里程碑。

董老师后来跟我说过其中的经验体会。最主要一条就是不能原地打转,要抓大放小,研发到一定的阶段,迅速扩大测试集,开放系统给其他人测试,在错误中成长。

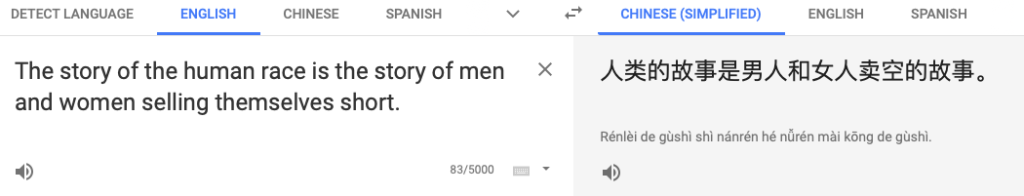

译星之前的研发,实际上都是在非常小的开发集上做,当年也不分开发集与测试集,系统通常也不开放,所谓的学术成果鉴定会,大多在一个封闭集中,抽取几个样例进行。以前的机器条件也差,常常是输入一个句子,鉴定组成员出去喝了咖啡回来才能看到结果。

董老师的“科研一号”是第一次把系统开放给评委专家来测试的事件。这在当年是需要底气和勇气的。

我还清楚记得跟着刘老师去军科院参加“科研一号”系统评测的情景。礼堂外展示了系统的过往翻译样品和系统说明。礼堂内专家们用不同的句子挑战系统。对于系统的开放测试,印象非常深刻。

董老师与台湾的苏克毅教授关系很好。董老师跟我说,你看,苏教授自己凭着对MT的 passion 开了家翻译公司,软件虽然做得并不精细,但他敢于大胆使用,不断迭代。

80年代末,高立公司来找刘老师合作,决定根据刘老师的 JFY-IV型专家词典为基础的 MT 来做新一代机译产品。那时候,我们已经从董老师的开放实践中学会了放开脚步。此前我们为几百句可以反复打磨一两年。

董老师自己也承认,从设计上,刘老师的专家词典系统比“译星”更胜一筹,更具有潜力。他也受邀参与了高立的计划,但那时候,他的重点已经有转移,开始酝酿《知网》(HowNet)了。他觉得机器翻译的基础知识资源不足,需要从根子上加强语义词典。这一做就是30年!

《知网》对跨语言概念精细分类,以义元及其关系为人类常识编码,建立了一个形式化的本体知识体系和逻辑语义表示。它是非人力可为的天才杰作,是上帝之光对董老师的眷顾,是中国对人类文明的贡献。说深度神经三位先驱者坐了20-30年冷板凳,终于迎来了图灵奖(见《图灵奖颁给熬过寒冬的人》)。董老师坐了30多年冷板凳,还基本上是藏在深山人未识。《知网》未必不是一个图灵级别的对于人类认知的贡献。我以前说过,“可以预见,将来某个时候,当机器翻译和自然语言理解的应用项目穷尽了浅层可用的低枝果实之后,知识系统将会被进一步发掘、利用和欣赏。”(摘自《语义三巨人》)

《知网》是董老师的不朽丰碑。

我91年出国以后,就流浪天涯了,从英国到加拿大,与国内的亲友和师长都难得联系。但出国前,董老师给我写了个“介绍信”,交给在UMIST担任系主任和计算语言学中心负责人的大名鼎鼎的Tsujii 教授(他是日本MT元老长尾真的弟子,李航的导师)。董老师还为我其他的留学申请多次写过推荐信。出国前夕,董老师告诉我,刘老师跟他说了,项目把李维留下来好几年了,错过了几次留洋机会,这次的中英友好奖学金的留英机会,不好再留了,决定放人。鼓励我出国好好深造。

记得还在我出国前,有一次董老师召集陈肇雄和我们几个人一起聚会,说(大意):咱们这里都是 中国MT 的精英了,我们可以不可以考虑加强合作,实实在在做一番事业。

等我转到加拿大念博士的时候,董老师已经到新加坡了。记不得怎么恢复的联系,总之董老师作为1996国际中文计算会议主席召集大会的时候,鼓励我参会,把大会的海外赞助给了我。其实,我博士时期的 HPSG 中文研究,属于小众的探索,基本上就是玩具系统,并没有多少拿得出手的东西。当时跟董老师在新加坡做项目的有郭进。董老师与 Dr Lua 是大会主席副主席。

以前说过,董老师虽然不是我的直接导师,但多年来对我的指引、关照和鼓励,实际上是编外导师了。总之 非常幸运 能遇到这样的前辈,从一开始就信服他 追随他 研读他的逻辑语义学说(董振东:逻辑语义及其在机译中的应用)。写《语义三巨人》的时候,我是怀着一片虔诚之心。

我翻译的反映NLP领域理性主义与经验主义两条路线斗争史的《钟摆摆得太远》长文,就是董老师最先推荐给我的文章,也是董老师介绍我联系 Church 教授本尊。翻译前后我们三人间的频繁通信以及他的指正,也是一大篇故事。

后来在群里,有一次对于符号系统的自嘲,无意中触犯了董老师(董老师和我都是符号主义践行者)。那是第一次他当众批评我“矫情”,我的感觉就是,耳提面命,诚惶诚恐。除了刘老师和董老师,任他天王老子,我也不会不反唇相讥,可董老师是我心中的圣哲,在他面前,肝脑涂地也是值得的。高山仰止,说的就是这个意思。他不需要正确,他也可以固执,但伟人就是伟人,他和他的思想的存在本身,就是一种权威。我辈望尘莫及。

一个多月前,我给他微信,请他给《语言答问》一书作序,没想到他已经到最后的阶段了。恩师已去,我心恍惚。

董老师一直到老,始终在调试系统,探究人脑和语言的奥秘。我想天堂应该也有电脑,上帝不会让他闲着,《知网》不仅是他留给我们的精神遗产,也会在天国大放异彩。

【相关】

【美梦成真】

《钟摆摆得太远》(立委译)

《知网》