大模型的出现让AI变得像个“全能选手”:你随便扔给它一个任务,比如“翻译句子”“生成图片”甚至“模拟机器人走路”,它居然能立刻上手,连样例都不用看。这种“零样本”(zero-shot)能力背后有个简单却强大的秘密:模式学习与模式对齐。这是怎么回事呢?

一、AI任务的本质:对齐模式的过程化

AI任务就是在两个对齐的模式中,挑一个作为输入,另一个作为输出。输入到输出的转换过程就是任务的执行。因此,AI任务可以用一个公式概括:

任务 = input → output

任务例示:

- 翻译:输入:“We study AI” → 输出: “我们学习AI”。

- 文生图:输入:“猫坐在月亮上” → 输出: 猫咪月亮图。

- 看图说话:输入:猫咪月亮图 → 输出:“猫坐在月亮上”。

- 视频生成:输入:“下雨的森林” → 输出: 动态雨景视频。

这些任务的输入和输出看似不同,但本质都是“模式”(pattern),某种有规律性的模态表示:文字有语法,图片有构图,视频有动态规律。AI要做的,就是学会这些模式,再掌握它们之间的对齐规律。真正的“万能”,是模型能直接听懂你的指令(比如“把这句翻成法语”),不用任何例子就能执行——这叫“zero-shot”,是大模型的终极大法。

二、GPT的超能力:模式与对齐的“全地图”

GPT为什么能做到zero-shot?因为它在预训练中学会了几乎所有“模式”和“模式对齐”。

1. 学会一切模式

GPT靠的是预测下一词元(Next Token Prediction,简称NTP)的自回归序列学习:就是根据前文猜后文的游戏。比如:

- 输入“The sky is…” → 预测“blue”。

在海量数据上玩了几亿次这个游戏,GPT压缩出了各种模式的规律:语言的语法、图片的特征、视频的动态。既然任务的定义就是从输入预测输出,任务也都被前文预测后文的定式所涵盖。

2. 掌握模式对齐

更重要的是,GPT学会了模式之间的“对齐关系”。比如:

- 英语“cat”和汉语“猫”在意义上对齐。

- 文本“下雨了”和视频“雨滴落下”在场景上对齐。

这些对齐关系来自联合训练:文字、图片、视频被切成小块(token),在高维向量表示的“数据熔炉”里炼成一张“关系网”。理论上,只要数据够多,任何模式之间的对齐规则都能被学会。

3. 理论支撑:数据现象背后的规律性

三、Zero-Shot魔法:听懂任务指令

有了模式和对齐,GPT就能直接听懂指令,给以回应。输入模式识别指令,输出模式生成回应,符合自回归学习的接龙式流程。比如你说“把这句话翻成汉语”,它就明白:

- “把这句话” → 锁定输入。

- “翻成汉语” → 找到输出模式(汉语)并转换。

这不需要样例,因为“任务描述”本身就是一种模式,GPT在预训练中见过无数类似指令,已经学会了。微调(few-shot)虽然能让它更擅长特定任务,但zero-shot才是“万能”的核心。

四、案例:跨模态任务的“万能秀”

大模型的“模式对齐”能力有多强?让我们看看它如何在不同模态之间玩转“input → output”,从简单到复杂,案例一个比一个精彩。

1. 文本到文本:Zero-Shot翻译

- 输入:译成法语 “I love you” → 输出:“Je t’aime”。

- 怎么做到的:GPT在预训练中见过无数语言对,学会了英语和法语的模式,以及它们在意义上的对齐。你直接说“翻成法语”,它就从“知识地图”里找到路径,秒出结果。

2. 文本到图像:文生图

- 输入:“画一只独角兽飞过彩虹” → 输出:

- 怎么做到的:多模态模型在文本-图像数据上训练,学会了文字描述和视觉特征的对齐。指令一到,它把“独角兽”“彩虹”等词映射成图像模式,直接生成。

3. 图像到文本:看图说话

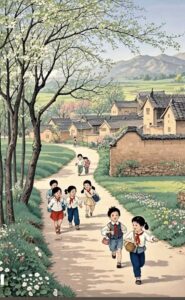

- 输入:画的是什么?

→ 输出:“这幅画描绘的是一幅田园风光的景象。一群小学生穿着校服,戴着红领巾,正在乡间的小路上欢快地奔跑玩耍。道路两旁开满鲜花,绿树茂盛。远处是青山环绕的村落,房屋错落有致,整体给人一种安静祥和又充满活力的春日乡村气息。”

- 怎么做到的:多模态模型学会了图像像素和语言描述的对齐。你给它图,它从视觉模态逆向生成文字模态。

4. 文本到音频:文生音乐

- 输入:“一段欢快的钢琴曲” → 输出:

- 怎么做到的:多模态音乐模型(Suno)在文本-音频数据上训练,学会了“欢快”“钢琴”等描述与音符模式的对齐。指令下达,它直接生成符合描述的音乐。

5. 文本到视频:视频生成

- 输入:“一个人在雨中跳舞” → 输出:

- 怎么做到的:可灵大模型在视频-文本数据上学会了“雨”“跳舞”等概念的视觉模式和动态规律,指令一来,直接从文字模式映射到视频序列。

6. 图像到视频:图生视频

- 输入:

→ 输出:

- 怎么做到的:可灵大模型从静态图像提取特征(儿童、农村等),对齐到动态模式(欢快玩耍),生成连续帧,展现无忧无虑的童年场景。

7. 文本到动作:机器人控制

- 输入:“机器人拿起杯子” → 输出:机器人动作序列。

- 怎么做到的:具身大模型(如RT-2)将文字指令对齐到物理动作模式,生成控制信号,指挥机器人执行。预训练中见过大量动作-描述数据,zero-shot也能上手。

五、结语:万能钥匙的奥秘与未来

从翻译到机器人控制,大模型靠模式学习与模式对齐解锁了无数“input → output”的可能性。它通过自回归学习把所有规律装进“知识地图”,再用对齐关系听懂指令,直接zero-shot执行。这种能力让多模态生成式大模型(例如GPT)不仅能“学会任务”,还能“理解任务”,成为AI的“万能钥匙”。

微调虽然能优化效果,但不是理论必须——真正的“万能”,是预训练赋予的zero-shot能力。未来,随着更多模态加入联合训练,这把钥匙会打开更大可能:从艺术创作到物理模拟,甚至主动探索未知。大模型的奇妙旅程,才刚起步。

【相关】

- Grok: 大力出奇迹的背后(1)

- Grok:超大数据的大模型为何能收敛?

- 《“蜜蜂巢”里的子弹:JFK档案解密后》

- 2025年肯尼迪遇刺档案解密揭示的惊人真相

- 2025年肯尼迪遇刺案档案解密

- Gemini Deep Research:用“Logits Lens”洞察神经网络的奥秘

- Sonnet3.7: 推理大模型的挑战与前景(图文版)

- 数学圆舞曲:欧拉恒等式(配乐诗朗诵)

- 检索增强(RAG)与窗口数据的互补性 (图文版)

- 检索增强(RAG)与窗口数据的互补性

- 关于颈椎病,大模型医疗建议靠谱吗?

- Xiao Hong Red:肖弘其人

- 万字长文解析 LLM-native Agent 及其混合计算方式

- o3 deep research: LLM 驱动的 Agent 综述

- Agent:数字代理的崛起与未来

- Agent元年:从聊天机器人到数字员工的当代进化史

- 生成式AI学习中容易混淆的几个术语

- 思维链是大模型的符号神助攻

- 再谈自然模态数据是高维空间的低维流形

- 深度学习的局限性研究综述

- o3 deep research: 深度学习局限性研究报告

- 深度学习的基石:多层感知机

- o3 Deep Research: DeepSeek R1 多阶段训练流程问答解析

- RPA 赛道与大模型Copilots早期创业者的困局

- Transformer 和注意力机制简介

- 立委科普:如何理解自注意力机制中的QKV分工?

- DeepSeek 笔记:推理新范式 query+cot+answer 支持新的 scaling law 吗?

- DeepSeek 笔记:R1 部署阶段的推理机制

- 从R1幻觉谈起,大模型幻觉是缺陷还是创意火花?

- 推理强化学习是端到端的监督,推理过程的非监督

- DeepSeek 风暴下看看它的论文

- 大模型风云诡谲的下半场:scaling 失效?