老爸——一个普通医生的高峰

(本文是根据老爸回忆文章整理创作)

老爸与汉阳一江水

正文之前先讲老爸的四则小故事

1.大年三十的急诊

有一年春节,我回老家陪老爸过年。

除夕夜,暖黄色的灯光洒在房间里,一家人围坐在电视机前,春晚的欢声笑语和瓜子嗑开的脆响交织在一起,营造出浓浓的年味。老爸斜靠在那张老藤椅上,保温杯里的枸杞随着他偶尔的晃动轻轻沉浮,这是他一年中难得的清闲时刻。

然而,十一点的钟声还未敲响,茶几上的手机突然震动起来,老爸几乎是条件反射地坐直身子,保温杯里的水晃出一圈涟漪。电话那头传来急促的汇报:“急性腹痛,初步诊断阑尾炎,情况紧急,恳请您来会诊!”

老爸没有多说,抓起搭在椅背上的深灰色棉袄,迅速套在身上。我瞥见他鬓角新添的银丝在灯光下泛着微光,那是岁月留下的印记。“走,送我去医院。”他的声音平静却不容置疑,仿佛这不是除夕夜的紧急召唤,而是再寻常不过的工作日常。

老爸一直工作到第二天,大年初一的早晨,才叫我接他回家。

路上,我忍不住问他:“什么急诊,大年三十都过不安稳?”

父亲显得很疲惫,眯着眼淡淡地说:“医生嘛,常会有这种事,急诊才不管什么假日不假日呢。年轻时年年如此,当年你们小记不得了。”说完,他便闭上眼睛休息。

过了几天,父亲才骄傲地告诉我那天的惊险经过。原来,大年三十晚上,医院来了一个急诊病人,初步诊断为急性阑尾炎。两位值班外科医生连夜开刀,然而,当他们打开患者的腹腔时,却发现阑尾并没有炎症,这让两个年轻医生杵在手术台前,陷入了僵局。一位医生提议关腹缝肚,转到上级医院;另一位则提议请父亲过来看看,再决定下一步方案。最后,两位医生一致决定请父亲过去。

“让我看看。” 父亲边说边利落地戴上橡胶手套,消毒水的味道瞬间弥漫开来。他的目光如炬,在患者腹腔里一寸寸扫过,布满老年斑的手却稳如三十年前。“胃穿孔包裹性脓肿。” 他的声音在寂静的手术室里格外清晰,带着不容置疑的笃定。

手术灯下,父亲的动作行云流水。镊子夹起缝合线,像穿针引线般精准穿过胃壁,每一针都带着几十年沉淀的力道。清理腹腔时,他的眼神专注得近乎虔诚,生怕遗漏任何一点渗出物。时间一分一秒过去,窗外的夜色渐渐褪去,当最后一块腹腔纱布归位,晨光已染红手术室的玻璃窗。

这例胃穿孔的渗出被包裹,很易被手术医生漏诊。这需要临床医生先判断,再寻找,没有一定临床经验和理论基础,是很难发现的。

大年初一的清晨,我接父亲回家。他靠在车座上,整个人像是被抽走了力气,却仍喃喃自语:“要是不查明病因就关腹,胃液迟早会腐蚀腹腔。再次手术是必然的。如果拖久一点,腹部被胃液等物浸湿,感染过重,会危及生命”。

过了几天,他说起这个病例时,眼底仍闪着特有的光亮:“手术最关键的就是清理腹腔,必须非常细心地清理腹腔残留物,确保术后不被感染,容不得半点马虎,这是救命的活儿。”老爸很兴奋, “每一个被挽救的生命,都是最好的勋章。”

谁能想到,这位在手术台上奋战两小时的医生,已是八十三岁高龄。虽眼不花手不抖,但五年前他因胃癌做了胃全切手术,因胆结石做了胆全切手术,身体已大不如前。但只要穿上白大褂,站在手术台前,他就像被点亮的灯塔,重新焕发生机。下了手术台,他也不回家,而是守在病房,密切观察病人的每一个细微变化。

老爸的职业精神,早已融入血脉,深入骨髓。他坚守岗位,不为名不为利,只为那份刻进骨子里的医者初心。在他心里,每一个团圆夜里的紧急奔赴,都是对这份职业最深情的告白。

2.以笔为梯的医者情怀

老爸聪慧,不但手术做得好,文章也写得得心应手。老爸的书房办公桌上,永远摆着几本翻得破旧不堪的《外科学》、《骨科学》、《妇产科学》等专业书籍,书页间夹着泛黄的英文剪报,铅笔批注密密麻麻爬满空白处。他总说,手术刀和钢笔都是医生的武器。

老爸虽是中专生,但凭借高超的手术技术、丰富的论文成果和熟练的英语能力,虽无官职,但中级职称、副高、正高都评得很顺利,没有置疑。每当评审专家翻阅他的职称申报材料时,总对他论文的独到临床见解,超高难度的手术案例印象深刻,全然忘却了申报者只是个基层医院的普通中专生。

然而,老爸深知,并非所有人都像他这样幸运。许多同事(不包括领导)因为各种原因无法顺利晋升。有的技术水平不够,有的论文数量不足,尽管他们的学历比老爸高,但就是评不上正高。

老爸对此心存异议。他觉得,有些朋友的临床手术水平很高,但不太会写文章,就被卡在了论文这道“独木桥”上。他常常叹息:“外科医生的战场在手术台,不是实验室。一天连做三台手术,累得手都发抖,哪还有精力搞科研、写论文?”他反复强调:“临床工作是实践性东西,尤其是外科,需要手巧有悟性,要多做多看,才能提高业务水平。临床不是搞科研,而且病人那么多,那么忙,值班接着值班,手术接着手术,大家都忙得喘不过气来,又不是教学医院,哪有时间坐下来申请课题、搞科研、写文章?”在他看来,临床医师需要大量病例的训练和临床经验的积累,把科研任务和临床工作混为一谈,让许多临床经验丰富、技术精湛的医生被论文卡住而评不上职称,是很不公平的。一个以临床技能为核心的实践性职业,如果只看重论文而忽视临床治病水平,不仅荒唐,也是对医者价值的误解。

老爸是个热心肠的人,急公好义,见不得人才被埋没。老爸决定扶持一把,说干就干,他一头扎进书房,在成堆的病例报告中穿梭,时而皱眉翻阅外文文献,时而在草稿纸上绘制手术示意图。当两篇凝结着临床智慧的论文交到两位同事手中时。他拍着两人肩膀,眼里满是期许。“就当是我们一起做的研究。”

果然,经两人修改的文章发表后,他们很快评上了正高,后来都成了医院的台柱子,是手术台上的一把好手。

这些年,每当提起此事,父亲总笑得眉眼弯弯,像个孩子般得意,尽管知道帮写论文不合规,但他从未后悔。“能让好医生发挥更大价值,比什么都值得。”他总是这样说。

在他心里,医者的使命本就该照亮更多人的路。他用手术刀救人,用钢笔为同行铺路,助人为乐,成人之美,为他认为值得的人才铺路搭桥,这都是他很乐意做的事。

3.无影灯下破禁区

在医学的战场上,老爸是一位无畏的拓荒者。他胆大心细,勇于创新,中青年时期尤为特出。凭着他扎实理论基础和多年实践经验,手术时双手既快且稳,操作精细入微。在那个医疗资源匮乏的年代,他凭借过人的胆识与精湛的技艺,在基层手术台上完成了一个个被很多大医院视为禁区的手术。

外科医生不仅需要深厚的专业学识更需要悟性,手指手腕的稳定性和灵活性相当重要,老爸仿佛是天生做外科医生的料。上了手术台,老爸好似换了一个人,从容不迫,整个人镇定自若,动作精准而灵动。飞速下刀、精准剥离,每一个动作都追求完美。父亲当年做的许多手术,难度之高,至今仍站在外科领域的前沿,这其中的艰辛与不易,常人难以想象。他总是感慨,外科医生的战场不在聚光灯下的荣耀舞台,而在无影灯照亮的方寸手术台间。那里容不得丝毫犹豫,更需要敢为人先的勇气和担当。

在父亲漫长的从医生涯中,他见过不少罕见病例,碰到的疑难杂症更是不计其数。许多大城市的大医院都不愿接收、将病人拒之门外的疑难病症患者,在走投无路之时找到父亲,父亲总是尽力接纳,使出浑身解数,在力所能及的范围内,为患者解除病痛。

老爸有一世交老朋友桂叔,家在邻县,我们两家当年走动频繁,我也很熟悉他们一家人。桂叔他有一个16岁的儿子,患颈椎5结核并寒性脓肿,压迫了食道和气管,生命危急。到省、市各大医院求医,都因“手术风险过高”而被拒收。他听说南陵城郊的解放军127有全国骨科权威许竟斌主任(也是老爸的骨科恩师),怀一线希望带着儿子来到127医院。不巧的是,许军医出差南京,他手下的几位医生,面对这例高危病人,都不敢轻易接诊。无奈之下,老友找到了老爸。

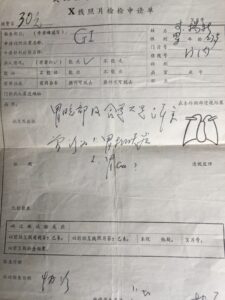

老爸接过X光片一看,眉头不禁皱了起来。颈前那密布的血管,如同盘根错节的老树根,而被结核侵蚀的椎体,脆弱得好像风化的朽木。稍有不慎,颈髓损伤就会导致高位截瘫,甚至危及生命。父亲此前从未接触过此类病人,心里也不免打鼓,感觉有些力不从心,不敢贸然接受。于是老爸找到127医院的骨科和外科军医们(老爸与他们都很熟,老爸在127医院许教授门下进修过半年),向他们说明情况,希望能在这所医院为患者进行救治。大家一起讨论方案细则,商讨救治方法。然而,对方领导仍不愿接收这个病人,建议转去合肥或南京的大医院救治,并答应免费派车送行。但病情紧急,转院路上随时可能因窒息而不治身亡,远水解不了近渴。在127医院做手术的路被堵死了,看着老友焦急又无助的眼神,父亲毅然决然地决定自己接手这个疑难重症。他和老友坦诚地交流,谈到了转院的风险和手术的风险,两人决定共同承担这份责任。随后,病人被送回了县医院。父亲深知此次手术的难度和风险,临时抱佛脚,疯狂地复习相关文献,重新温习解剖知识。半小时后,他咬着牙,把患者推进了县医院的手术室。

手术在局麻下进行,无影灯下,他像考古学家般小心翼翼剥离组织,止血钳在毫米级的间隙里游走,护士不停地替他擦去额头上汗水。细心解剖,进入脓腔,放出大量脓汁。瞬间,患者就能发声、进水,呼吸也变得通畅起来,终于脱离了生命危险。但手术还未结束,父亲继续深入操作,显露出颈椎5椎体病灶,祛除死骨,刮除结核肉芽,仔细冲洗脓腔,置入链霉素、异烟肼,放入引流片,最后缝合伤口。手术结束后,父亲才发现自己的后背早已被汗水浸透。

幸运的是,手术顺利且有效。术后3天,患者就退了烧,还自己去理了发,进食也恢复正常,恢复情况良好。术后12天,患者就出院了,整个治疗过程的医药费仅32元,参照当年物价,32元相当于县级医生月薪的2/3。之后,患者继续进行抗痨治疗半年,最终完全病愈。如今,40多年过去了,这位患者一直正常劳动、生活,儿孙满堂。

这例颈椎结核病灶清除手术,难度极大。除了颈前密集的血管、神经以及甲状腺、气管、食管等复杂的解剖结构外,颈椎本身就十分脆弱,再加上结核的破坏,其后的颈髓更是容不得半点闪失,稍有不慎,就会导致高位截瘫,甚至死亡。这属于骨科铁4级手术,即便是在北京、上海的大医院,主任们做这类手术也都如履薄冰。而父亲,出于救人的迫切之心,深知转院基本上就是死路一条。为了朋友之子,他虽然内心也有些颤颤巍巍,如临深渊,但凭借着自己多年颈部甲状腺手术的经验和对解剖的熟悉,加上骨科专科知识的积累,善于谋划的性格,胆大心细、终于圆满完成了这个在基层医院罕见的难题,既治标又治本,彻底根除了病灶,让患者终身痊愈。

还有一个患者,男,29岁,骑自行车时,右季肋部撞击于停放的板车把端,当即剧痛、感到呼吸困难,心慌,一小时后送入老爸医院。经查,肝脾胰肾均正常,腹腔无积液。胸腹透视无异常。住院观察16小时出现右侧腰背胀痛及睾丸痛,经初步诊断为腹膜后十二指肠损伤,于伤后28小时剖腹探查。进腹后见腹腔内有少量胆汁样液、胆囊、肝外胆管及肝脏无损伤,右侧后腹膜广泛水肿、绿染。作Kocher切口游离翻转十二指肠,发现其降部于乳头前上1.5cm处破裂∅1.5cm,肠液外溢,局部及右肾周围水肿,组织坏死。彻底清除坏死组织、漏出肠液,修补肠破裂口,BillrothⅡ式胃空肠吻合术,没有体外循环支持,没有术中超声引导,只有一双握手术刀灵巧的手,此刻在腹腔深处进行着显微雕刻。 48小时肠蠕动恢复,进流汁。三周后两造瘘管造影正常,先后拔除两管,一期愈合。随访一年,无并发症及后遗症。

这例腹膜后十二指肠损伤是一种严重的、少见的腹部损伤,早期因症状隐蔽,极易延误诊断。这场手术在教科书上都十分罕见,手术过程复杂,对医生的临床技术要求极高,一生难遇二例。手术台上,需要医生善于思考、灵活应变,没有规范的操作流程可循,稍有不慎,就会危及患者生命,抢救成功率并不高。如今患者还健在,生活正常。

另外,还有一位患者患有黑色素斑点 - 胃肠道多发性息肉症候群病,十四年间进行了三次手术,每一次手术都是与死神的近身搏斗,而这三次手术都是父亲一人完成的。尤其是患者患上了极罕见的肠道、胆道双梗阻,治疗难度极大,是极其罕见的病例。并发症往往是患者就诊的主要原因,这种病通常要到青年时期才会发病。由于是先天性疾患,目前又无根治办法,此病的预后若处理得当,患者可以长期生存,只是需要多次手术,但并不妨碍寿命。在父亲的细心多次治疗下,病人获得了新生。

老爸一生中,碰到得这样疑难危重病人很多。在简陋的基层医院里,几乎是自学的他,把挽救患者生命当作使命,突破一个又一个禁区,创造一个又一个奇迹。这些被大医院视为 “烫手山芋” 的病例,在父亲的妙手下都成了改写命运的奇迹。

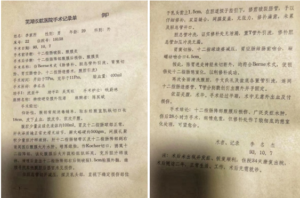

老爸的抽屉里保留了六例手术记录,涵盖普外科临床高大难课题。1,扩大全胃切除术,2,甲状腺癌仿根治手术,3,十二指肠破裂仿Berne手术,4,肝左外叶切除、肝内取石、肝胆管盆式内引流术,5,急性胰腺炎病灶清除引流术,6,直肠癌根治术。

那些尘封的手术记录,不仅是医学创新的见证,也是基层医疗的突围指南,更是一个医者对生命最崇高的敬意。从仿Berne术式改良到肝胆管盆式引流创新,这些诞生于县医院的手术记录,印证着“临床需求是技术演进第一驱动力”的医学真理。当80%医疗资源集中于城市时,正是这些“基层专家”在医疗洼地筑起生命堤坝。当年轻医生问他哪来的勇气挑战这些禁区,在药品设备都奇缺的那个年代怎么敢做这些四级手术?父亲总会轻抚手术刀,淡淡笑道:“当生命在刀尖悬停时,医者要做患者最后的桥。”此刻,无影灯正将他的身影投在斑驳的墙面上,恍若一座跨越生死的桥。

4.先天变异下的生命课

老爸行医六十多年,岁月在他的脸上刻下了深深的皱纹,却也沉淀出了他精湛的医术和沉稳的气质。给病人动手术万例以上,在如此漫长的从医职业生涯中,有没有发生过重大医疗事故呢?没有,那还真的没有,这在医学界几乎是不可能的奇迹。

然而,他一生中确实有几次手术失败的案例,尤其是上世纪八十年代初的那次经历,让老爸痛心疾首,毕生难忘。那是一道永远无法愈合的伤疤,刻在他的医者生涯里,也刻在他的心上。

手术的成功与否,往往取决于医生的经验、技术和对生命的敬畏。老爸的初衷总是救死扶伤,但现实有时却残酷得令人无法接受。在医学的漫漫征途中,初衷与效果有时就像两条难以重合的平行线,难免遭遇挫折。对自己苛求的他常常自责,为什么有些手术还是失败了?为什么有些生命还是无法挽回?这些问题像沉重的石头,压在他的心头。

老爸的外科恩师,皖医二附院外科老主任闵梅先老先生就曾以自己的亲身经历开导老爸,他给老爸讲他当年在北京阜外医院心胸外科进修时的故事。在这个中国心外科老大的医院,那可是中国心外科的权威殿堂,汇聚了全国顶尖的医学人才。然而,即便如此,仍有许多病人走着进去,却没能走着出来,手术失败的案例屡见不鲜。闵老先生回忆起那段时光,眼中满是复杂的神色。他说,在那所医院里,每天都会面临各种疑难杂症和生死考验。有些病人病情极其危重,常规的治疗方法已经无法奏效,只能尝试一些新的、高风险的手术方案。可每一次手术,都像是在悬崖边行走,稍有不慎,就可能让病人陷入万劫不复的境地。中国顶尖的权威专家们曾告诫闵老先生,对于这些危重病人而言,不动手术就意味着死亡,而动手术至少还有一线希望。这条充满荆棘的医学探索之路,总要有人去闯,科学的发展往往是要付出代价的。医生这个职业,本就如同在风头浪尖上航行,每一次成功的背后,或许都隐藏着不为人知的遗憾。闵老先生的话,让老爸心中五味杂陈。他深知,医学的道路充满了未知和挑战,医学的道路上没有绝对的成功,每一次手术都是一场与死神的较量。但这些并不能减轻他对失败手术的自责和痛苦。

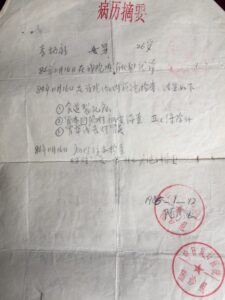

让老爸刻骨铭心、终身难忘的是我的一个中学老师的手术。老师是慕名来找我老爸医治的。当时老师64岁,岁月在他身上留下了痕迹,但精神还算矍铄。依据病史和B超诊断,确诊为胆囊结石。这种病症老爸此前做过上千例手术,每一次都凭借着纯熟的医术和经验,让病人转危为安,从未失手。本以为这次也会是一帆风顺。1984年10月16日,老爸身着手术服,神情专注。在助手们的配合下,老爸为老师进行了胆囊切除手术。术中发现胆囊内有23枚胆固醇结石,它们像一颗颗黄色的“定时炸弹”,威胁着老师的健康。手术过程看似“顺利”,胆囊切除干净,解剖清晰,历时75分钟,术后没有出现渗胆情况,切口也达到了甲级愈合的标准。老爸长舒了一口气,以为这次手术又圆满完成了。

然而,命运的转折总是来得猝不及防。这位病人的情况非常特殊,她的解剖结构存在先天变异,肝肠之间的正常通道缺失,取而代之的是胆囊及胆囊管。这种情况在教科书和医学文献中都未曾报道过,所以直到术中老爸也毫不知情(受限于当时的检测手段和个人水平)。因此,手术后第3天,老师原本恢复得不错的脸色突然变得蜡黄,黄疸症状出现了,并且黄疸进行性加深。老爸的心中涌起一股不祥的预感,他立刻组织医护人员进行会诊,仔细检查各项指标。经过一番讨论和分析,大家意识到情况可能比想象中要复杂得多。1984年11月9日,不得不进行第二次手术。这一次,手术室里的气氛格外凝重。老爸深知,这次手术将面临更大的挑战,但他不能退缩。手术耗时六个多小时,老爸全神贯注,每一个动作都小心翼翼。手术室外的长椅上,堆满了老爸来不及吃的馒头和早已凉透的茶水。护士们看着老爸布满血丝的眼睛,心疼不已,几次想劝他休息一下,都被他摆摆手拒绝了。在无影灯下,老爸的双手依旧稳如磐石,可只有他自己知道,当缝合最后一针时,手套里的掌心早已满是冷汗。

但命运并没有放过老师。1985年2月10日,又进行了第三次手术。术后,老师出现了多脏器功能衰竭,身体各项指标急剧恶化。老爸日夜守在老师的病床前,眼睛一刻也不敢离开监护仪上的数据。他尝试了各种治疗方法,查阅了大量的医学文献,请教了许多专家,可终究还是未能挽回老师的生命。于术后第5天,老师永远地闭上了眼睛,离开了这个世界。为此,老爸十分难受,深感自责。

尽管老爸拼尽全力,多方努力救治,却终究未能挽回老师的生命,这成了他心中永远的悲剧烙印。老爸的内心充满了自责和痛苦,他觉得是自己对病情的判断不够准确。此后,无数个深夜,书房的灯光总是亮到凌晨。台灯下,老爸弓着背,在解剖图谱上反复标注,不放过任何一个细节,试图从这次失败的手术中找到答案。他的眼神中透露出疲惫和执着,鬓角的白发,又多了几缕,那是岁月和自责留下的痕迹。

老爸常常拿这个痛心的案例告诫自己,也训诫着身边的同行。他说,每一次手术都是一次生命的考验,我们不能因为过去的成功而掉以轻心,要时刻保持敬畏之心。他将这次经历写成医学论文《胆道手术中几个特殊问题的诊治体会》。在论文中,他详细地分析了手术失败的原因,总结了教训,也提出了对未来医学研究和临床实践的思考。

从那以后,老爸时时以此鞭策自己。在工作中,他认真,认真,再认真。每一次手术前,他都会反复研究病例,制定详细的手术方案,与团队成员进行充分的讨论。在学习上,他学习,学习,再学习。不断关注医学领域的最新研究成果,参加各种学术交流活动,提升自己的专业水平。因为他深知,作为一名医生,肩负的是生命的重量,容不得半点马虎。那些未说出口的遗憾,那些辗转难眠的夜晚,都化作了父亲行医路上的警示灯。在他心中,每一台手术都是一次生死较量,唯有以最严谨的态度、最敬畏的初心,才能对得起患者性命相托的信任。

如今,老爸虽然已经年事渐高,但他的医者精神却依然熠熠生辉。他用自己的经历告诉我们,医学的道路充满了坎坷和挑战,但只要我们心怀敬畏,不断学习和进步,就一定能够在手术刀下挽救更多的生命。

--------------------------------------------------------------------------------------------------

老爸出身于一个破落的知识分子家庭。那座承载着岁月沧桑的青瓦老宅,宛如一位沉默的老人,见证着家族的兴衰荣辱。墙皮早已剥落,露出内里斑驳的砖石,每一道裂痕都像是岁月刻下的皱纹,又仿佛是他布满补丁的童年写照。因交不起学费,他从未踏入过小学的校门,爷爷用废旧报纸装订的课本,成了他最初的启蒙老师。在昏暗的灯光下,他如饥似渴地阅读着,那些从报纸上拼凑而来的知识,如同点点星光,照亮了他黑暗的童年。

因为贫困,没有机会踏入大学门槛,成了他的终身遗憾。每当回忆起这段往事,他的眼神中总会闪过一丝落寞和不甘。

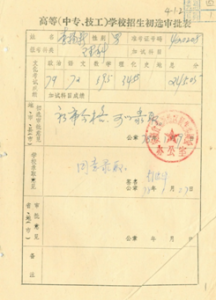

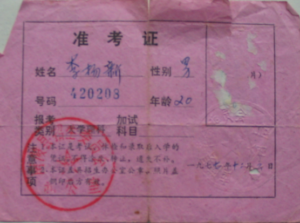

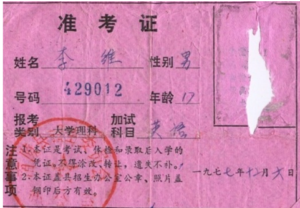

但他并没有被命运打倒,而是选择在困境中奋起。命运虽然关闭了一扇门,却也为他打开了一扇窗。他凭借着自己的努力和天赋,考入县中初中部。当年全县仅有35名初一生,一个未上过小学的他,却取得了前几名的优异成绩。那一刻,他仿佛看到了希望的曙光,心中燃起了对未来的无限憧憬。三年后又考进卫生学校医士专业学医,成了他人生的转折点。入学那天,他背着用碎布拼凑的行李,徒步四十多里山路,布鞋被碎石磨穿,双脚血泡连血泡。烈日下,他望着远处芜湖城的轮廓,汗水模糊了双眼,却始终没有停下脚步。终于,在暮色降临前,他踏进了医学殿堂,粗布衣裳沾满尘土,眼中却燃烧着炽热的求知欲。

课堂上,他像干涸的海绵疯狂汲取知识,深夜的自习室里,永远有他伏案苦读的身影。老爸极为聪明,仿佛天生就有着一双洞察事物本质的眼睛。他手巧人刻苦,对任何事物都有着强烈的好奇心和探索欲。与生俱来的天赋,就像一颗被埋在土里的金子。他有那股冲劲,不满足于现状,总是渴望突破自我。大胆心细,勇于在实践中尝试新的方法和思路,同时又能在关键时刻保持冷静,精准地把握每一个细节。不惧失败,每一次的挫折都成为他前进的动力。敢担责有爱心,对待每一个病人都像对待自己的亲人一样,尽心尽力,从不推诿。他对新事物敏感,总是能在第一时间捕捉到医学领域的最新动态,好学好问,遇到不懂的问题,一定会打破砂锅问到底。他还有着创新争强的勇气,不甘平庸,总是力求新的突破。

中专毕业的他,只能在基层的县医院工作。基层的条件艰苦,设备简陋,医疗资源匮乏,但这并没有阻挡他前进的脚步。他在基层行医五十余年,就像一颗扎根在贫瘠土地上的大树,努力地汲取着每一滴养分,茁壮成长。他用自己的智慧和汗水,在有限的条件下,创造了无限的可能。他所取得的成就,达到的高度,是常人难以企及的。

我常常想,如果老爸在大城市名医院工作,拥有更广阔的平台,他完全有可能成为国家级的大师,成为中国医学界的权威。但先天不足,平台的缺失,使他在其工作领域里,却达不到他天赋本应该达到的高度。这是时代给他的局限,是命运的使然。然而,老爸坚守在自己的岗位上,默默地奉献,用一生的努力,在基层创造了属于自己的辉煌。

老爸不仅有一身绝技,而且从医至今,创造不少第一,有全国的,有本省的,也有本地的。老爸虽没有院士头衔,没有专著出版,没有获国家奖的成果,但老爸在基层默默工作,自学成材。医技来自个人领悟,“老师”就是医学书籍,在穷乡僻壤之地,在知识分子受排挤的年代,他凭借自身的努力,创造了自己的职业成就。

老爸灵敏手巧,悟性极高,有着学外科的天赋。他手术做得漂亮利索明快,深得同行、病人及家属的好评。每一次手术,他都会提前做好充分的准备,从手术方案的制定到手术器械的选择,每一个细节都考虑得十分周全。在手术过程中,他全神贯注,每一个动作务求精准无误,仿佛时间都在他的掌控之中。

老爸对技术精益求精,对病人,他视如亲人。他为人和气,待人热情,无论病人情绪多么烦躁,他总是不烦不燥。问病十分认真,他会耐心地倾听病人的每一个诉求,仔细地询问病情的发展过程,不放过任何一个细微的症状。回答病人和家属的问题时,他总是耐心细致,用通俗易懂的语言解释病情和治疗方案。无论贫富贵贱,他都一视同仁,倾尽全力给予医治。他不会因为病人的身份和地位而区别对待。

老爸用他的一生,诠释了什么是医者仁心,什么是敬业奉献。他在基层的医学岗位上,默默地耕耘,用自己的双手挽救了无数患者的生命,用自己的爱心温暖了无数人的心灵。他真正体现了救死扶伤的人道主义精神,是一个伟大的基层医者,也是一个伟大的父亲。他用自己的言行举止,为我树立了榜样。他教会我要有坚忍不拔的毅力,要有勇于挑战的精神,要有关爱他人的情怀,他是我心中永远的英雄。

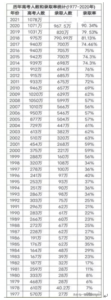

一. 中国全科医生第一人

老爸所掌握的医学门类之全、在现今国内,甚至国外也很难找到第二人。

这是一项纪录,是历史、环境和老爸的刻苦好学造就的。

老爸一直开展各科手术,其中包括各种三、四类手术,这使他始终处于时代医学的前沿。

老爸的职业生涯丰富多彩,从事过医疗行政(卫生局政府机关)、分院管理(YJ、HW分院业务院长)、血吸虫病专业防治、放射科、麻醉科、内科、普外、骨科、泌尿、妇产、神经、五官、眼科、胸外等,尤其是普外、骨科、泌尿、妇产、五官、胸外、麻醉,完成各科不少高难度的四级手术,在当时都达到了该专业前端,这是非常了不起的。

上世纪六七十年代,在那间设备简陋的小县城手术室里,无影灯下,父亲的双手如同被赋予魔力,精准地完成着各类高难度手术。如腹外的胰头十二指肠切除、胆、胃、肝等手术;胸外的颈动脉瘤切除吻合、肺切除等手术;骨科的骨髓炎到胸椎、腰椎结核等手术;泌外的肾蒂淋巴结剥脱等手术;妇产的子宫、卵巢切除等手术;神外的颈动脉瘤等手术;五官的鼻泪管吻合等手术;眼科的白内障等手术。对于各段硬膜外阻滞麻醉;颈丛、臂丛阻滞麻醉;蛛网膜下腔、脊髓麻醉;插管全麻及静脉复合麻醉,上述手术在当时即便大城市医院都视为挑战性的手术,老爸却能熟练掌握,游刃有余。

老爸从事医学科类之多,也是那个时代的产物。老爸认为:以今天观点看,既不够规范,也不足严谨。但在缺医少药的年代,老爸的全面手,挽救了很多人,治好了不少病,也铸就了一段难以复制的医学传奇。现今,随着医疗教育制度的完善和医院分工的细化,已经不可能产生老爸这样的全科人才了,更不可能培养全科都涉猎且还能到达相当高度的医生来。

老爸在基层行医至今50年了(如今年过八旬依然半日在岗),遇到过各种状况的病人,凭着他过人的才智、精力和手巧,因地制宜,不知道救回多少人的性命,也练就了他一身本领。凡是和老爸同台合作一起作过手术的同辈下辈医生,都称赞老爸手巧,手术做的干净利落,十分艺术,赏心悦目,素有一把刀的美誉。以至于老爸在大医院进修时,所在科室的主任都将自己的亲人交给这个“徒弟”主刀,可见他的医术得到了行家的认可。

二.中国绝无仅有的一次手术

1968年,在皖南一个深山小乡镇何湾,一个13岁的男孩从牛背上摔下,肝脏破裂,腹内大出血。当时,肝手术在大城市都是极为复杂的大手术,而老爸此前从未做过此类手术。更糟糕的是,这个偏僻的山村连手术所需的大量血液都无法保障。男孩的生命危在旦夕,时间不等人。面对绝境,救命第一,老爸艺高胆大,决定冒险一试。

没有血源,老爸急中生智,大胆决定从腹腔抽取混有胆汁的腹血进行回输。这在当时的医学领域是前所未有的大胆尝试,属于首创。老爸凭借丰富的经验和大胆的创新,成功地将混有胆汁的腹血安全回输到患者体内,创造国内第一例,老爸的这一创新在当时无疑是极具前瞻性的。(这里也有一个理论问题:肝血回输当时医学上尚极少论及,因有胆汁污染,10年后,文献才有报道混有胆汁的血能安全回输,并在后来的文献上陆续得到肯定。)

当时是形势所迫,也是老爸曾有过一次腹血回输经验(但没有混有胆汁,是宫外孕破裂的腹腔出血,虽混有羊水,但也可回输,老爸经历多次)。那一夜,仅有的一盏汽油灯忽明忽暗,老爸立在病人身旁,采用“车水战术”,从腹内把出血抽出来,过滤后再静脉输入,共回输1700毫升,赢得了宝贵的抢救时间。紧接着,父亲冷静地进行全麻开胸开腹手术,在这简陋到近乎原始的环境中,凭借着精湛的医术和过人的胆识,一人带着两个护士成功完成了肝脏修补。在一个小山村,没有电,缺乏助手,在设备简陋、药品奇缺、血品缺如、又无指导老师的情况下,老爸胆大心细成功完成他第一例肝脏手术,这应算是一个少见奇迹。术后恢复倒也算“顺利”,终于救回了患者一命。在那个时代,那样条件,那种技术,是个了不起的成绩。这样的手术水平堪称中国县医院腹部外科的巅峰之作,绝对处于前沿水平。而在山村小镇完成这样的手术,在中国也是绝无仅有的。

这位病人前后花了一千多元,老乡戏称他叫“王一千”,当时老爸月薪才不到50元,这笔费用相当于他工资的二十倍。但农家哪能出得起这天文数目,好在那个时代,病人出身贫下中农,又是当时当地最大手术,政府把费用一笔勾销,这在当地社会上被传为佳话。

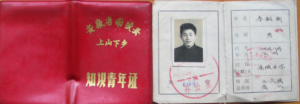

三.中国一个医疗团队在山乡短时间开刀最多纪录

1965 年,老爸带领一支 7 人巡回医疗队奔赴皖南烟墩公社。医疗队中仅有一名内科医生、五名护士和助产士以及老爸这位外科医生。队长是年过半百、心脏不太好的内科田医生,他多数时间在家休养,实际工作便由不到三十岁的老爸主持。

当时的烟墩公社医疗条件极为恶劣,没有电、没有麻醉师、缺乏正规助手,器材和药品也严重不足。老爸如同光杆司令,带着手术包和手提高压消毒锅,自己搭建起简易的“手术室”。然而,就在这样的环境下,他们开启了一场为期 100 天的医疗奇迹之旅。

在三个月的时间里,老爸以一己之力,完成了612 例次大小手术,且无一事故、无一人死亡。这些手术类型繁杂多样,涵盖了胃、肠、胆等内脏器官手术,子宫、疝、痔等病症治疗,以及甲状腺、肾、输尿管等部位的处理,甚至涉及骨科、眼科、牙科等多个领域,其中 121 例开腹手术更是难度极大。在那个青霉素都奇缺的年代,每一台手术都伴随着巨大的感染风险,术后护理也困难重重,但他们凭借着精湛的医术和顽强的毅力,让所有患者都顺利康复。

与此同时,医疗队还积极推动当地的医疗建设。他们组织全公社 6 个大队的卫生员分批脱产培训,创建了一个卫生村,并为村里建了两口水井,彻底改变了此地世代饮用“泥水”的历史。

这三个月里,老爸全身心投入工作,昼夜不分,从未离岗一天。尽管离家只有几十里地,一个多小时的车程,家中还有老人和孩子,但他百日里竟未回家一次。如此卖命工作,那个年度亦无任何奖金激励,全凭对工作的高度投入和无私奉献精神。

巡回医疗期间,有一天下午的经历堪称传奇。一位县医院仅有的麻醉医生临时赶来支援,老爸抓住这难得的机会,连续开展了三例阴式全子宫切除术加盆底修补重建术。当时,大饥荒留下的后遗症致使三度子宫脱垂高发,这些患者大多身体虚弱,手术风险极高。老爸全神贯注,手持手术刀,在昏暗的灯光下,小心翼翼地分离组织、止血、缝合,每一个动作务求精准。当完成这三台手术后,已是深夜。老爸没有丝毫停歇,又投入到十多例其他手术中。直到清晨天亮,疲惫不堪的他才走出手术室,汗水早已浸透了衣衫,双手也因长时间操作而微微颤抖。

在那段难忘的时光里,有许多事情令老爸难以忘怀,例如下面三个具有代表性的病例。

第一例是一位不全流产大出血的患者,血如泉涌,染红了简陋的床铺,生命危在旦夕。老爸与助产士火速赶到三星大队患者家中,狭小的房间里弥漫着浓重的血腥味。他们凭借着丰富的经验,在她家里迅速为患者进行清宫手术。助产士一刻不停地调配补液,老爸则全神贯注地操作,最终成功将患者从死亡线上拉了回来。

第二例是膀胱阴道瘘患者,此前当地从未开展过此类手术。1965 年皖南山区的寒风里,中年女患者蜷缩在卫生院的角落,散发着异味的潮湿衣裤让她羞于抬头。这个被膀胱阴道瘘折磨了三年的农妇,因漏尿无法劳作,在村里受尽异样眼光,当她攥着皱巴巴的求助信找到老爸时,枯槁的面容下藏着最后一丝希望。老爸从未做过此类手术,面对这个 “烫手山芋”,看着患者哀求的眼光老爸没有退缩。面对这个难题,老爸查阅有限的资料,反复研究手术方案。手术当天,临时手术室里气氛紧张而凝重。老爸凭借着扎实的医术,细致地对瘘口进行修补,每一针每一线都寄托着患者康复的希望。经过数小时的努力,手术成功完成。术后,老爸和护士们精心护理,12 天后,患者康复出院,这不仅维护一个患者生存尊严,更填补了当地医疗领域的一项空白。

第三例是一位中年妇人,因伤寒病导致肠穿孔并发腹膜炎。在当时,这类传染病极为盛行,这类病症死亡率极高(不过近年来已经较为罕见)。身无分文,老爸没有丝毫犹豫,果断为她进行了肠切除手术。手术成功后,考虑到患者的艰难处境,老爸和同事们自掏腰包承担了所有费用。患者出院后,老爸还骑着自行车,穿越崎岖的山路,来到青阳木镇患者家中随访和慰问。他带去的不仅是礼品,更是医者的关怀与温暖,将 “白衣天使” 的圣洁诠释得淋漓尽致。

为此,医疗队受到县、地区(市)表彰和奖励,在褒奖会上还专门安排老爸上台作了专题报告,展览了老爸所用的“全部手术器械”,发了专文通告,并在全芜湖地区推广,这是对老爸和医疗队最大肯定和奖赏。

四.首创办公桌上做手术

时光流转至 1967 年,文革的浪潮席卷全国,医疗工作也面临着前所未有的挑战。

在皖南东河公社,一位脾脏破裂的患者命悬一线。老爸和另一同仁接到求救后,立即奔赴现场。到达公社时,情况紧急万分,根本来不及将患者转运至条件较好的医院。环顾四周,唯一能利用的 “手术台” 就是公社的办公桌,于是在办公桌上为患者成功实施了脾切除手术。更为称奇的是,在手术过程中,没有血源,老爸大胆尝试腹血回输,成功克服了无血源的难题。要知道,当时文献记载的脾出血回输都需要抗凝处理,而他们在没有抗凝条件下,凭借着对医学的深刻理解和无畏的勇气,将 800 毫升未经抗凝的腹血成功回输给患者,这在当时是国内首创的做法,完全是被形势所迫而开辟出的新路径,正所谓 “时势造英雄”。在后续的医学研究中,脾出血回输逐渐得到了理论上的支持和认可,并见诸相关文献,但在当时,这无疑是一项极具开创性和风险性的尝试。开创了国内这一医疗技术的先河。

1968 年,在新林乡镇,又一场生死救援上演。一位横位且子宫先兆破裂的产妇,情况危急,转运途中随时可能出现生命危险。老爸当机立断,决定就地在办公桌上进行剖宫产手术。他们在桌上铺上简易的消毒布,在顶上拉布挡灰,地面洒上消毒水,用汽油灯和手电筒照明,在局部麻醉下开始手术。手术室内气氛紧张到窒息,老爸密切关注着产妇和胎儿的情况,每一个操作都关乎两条生命。经过紧张的努力,随着一声清脆的啼哭,胎儿顺利娩出,母子平安。这两次在办公桌上进行的手术,充分展现了那个特殊年代医者 “因陋就简”、敢于创新的精神。

当年的医疗条件异常简陋,一旦遇到紧急出诊任务,往往只能单枪匹马,就地手术。在这种情况下,为了尽快救治患者,只能 “因陋就简”:上面蒙块布,就是天花板,下面洒水,以避尘土飞扬,汽油灯手电筒照明,就是一个“手术室”。俗话说的好:艺高人胆大。

五.文革武斗造就外科人才

文革武斗期间,各派武装割据,交通中断,医院时停时诊。枪炮的硝烟如阴霾般笼罩皖南小镇,街道上碎玻璃与砖石混杂,空气中弥漫着火药味与血腥味。往日熙熙攘攘的街道变得死寂,医院也在这动荡局势中摇摇欲坠。然而,子弹无情,枪伤肆虐。穿肝、伤肺、伤血管以及肾、肠胃等枪伤患者不断被抬进医院,只能就地手术。肝、肺修补术,脑外伤治疗,皆在那时被逼无奈踏上自学之路。

在条件极差的环境下,许多生命得以挽救。多数手术成功,但也有无力回天之时,不过少有问责。毕竟,在这混乱年代,能救一人便是功德。而老爸,正是在这样的艰难中,技术、手艺大长,练就一身过硬本领。

一天深夜,县医院被急促的脚步声打破寂静。几个壮汉抬着一位腹部中弹的青年冲进来,他是当地著名的造反领袖。鲜血从伤口汩汩流出,浸透了临时充当担架的门板。老爸迅速上前,只见青年脸色苍白如纸,意识模糊,腹部伤口处还嵌着弹片。他深知,这是肝脏中弹,情况万分危急。

老爸立即组织尚在医院的外科几个医护人员,让人找来六盏煤油灯,让护士们举着围成半圆,昏黄且跳动的灯光下,手术室的气氛紧张到了极点。进行肝脏修补手术时,每一个动作都如履薄冰。窗外,枪炮声仍不时传来,可老爸却像钉在原地一般,眼神坚定,双手稳如磐石,专注地进行止血缝合。他在心里不断告诉自己:“我是医生,这里就是我的战场。”

在那段动荡的日子里,这样的生死救援几乎每天都在上演。没有专业的指导,老爸就靠着啃书本、反复研究案例,在实践中摸索脑外伤、肺修补等手术技术。

由于武斗,医院半瘫痪,空时多,老爸系统地阅读学习医学专著、英语,补全了大学医学基础理论,使老爸在医学理论上也有了一次飞跃。理论指导实践,实践又出真知,老爸无论理论还是实际应用都达到一个新的高度。文革武斗造就外科人才,算是时代奇迹,这也是另类的黑色幽默。

六.唐山大地震的见证人

一九七六年“七.二八”唐山大地震,官方公布死亡人数是24万。7月28日,噩耗传来,8月3日,老爸收到紧急通知,要求立即组建医疗队赶赴唐山抗震救灾。当晚,老爸顾不上回家与家人道别,连夜组织起皖南三县 25 人的医疗团队,同时安排 25 人负责后勤保安工作。药剂师们则忙着整理药品,将有限的医疗物资仔细分类打包。

当队伍到达皖南芜湖市,在火车站候车室等待出发时,铁皮候车室里挤满了来自各地的医疗队,空气中弥漫着紧张而凝重的气息。突然,中央来电,告知伤员将南下,医疗队改为就地接受伤员治疗。老爸迅速调整方案,在铁路旁的乡镇峨桥紧急搭建起临时医疗站。

老爸作为队长,(组织皖南三县25人医疗队外加25人后勤保安)任务就是接收灾区100位伤员。当然,一切费用,全由国家包下来。在铁路旁的乡镇峨桥设点,去南京车站上卫生专列护接。转运伤员的卫生专列缓缓进站,车厢里此起彼伏的呻吟声让空气都仿佛凝固了。打开车门的瞬间,一股刺鼻的血腥味和腐臭味扑面而来,眼前的景象令人揪心:伤员们横七竖八地躺在担架上,许多人身上缠着沾满血污的布条,有的因长时间挤压,下肢已经溃烂生蛆。

一位截瘫患者被抬下车时,下肢皮肤大面积坏死,散发着恶臭。周围的人都忍不住捂住口鼻,老爸却毫不犹豫地跪在冰凉的水泥地上,戴着简易的橡胶手套,用镊子一点点清理坏死组织。腐肉被夹起时发出 “滋滋” 的声响。他一边清理,一边轻声安慰着患者:“别怕,很快就好。”

在接下来的三个月里,老爸和队员们几乎没有合过眼。他们每天要负责这百名伤员的治疗,面对的大多是骨折、周围神经损伤和脊髓损伤并截瘫的患者。手术不是很多,大部分伤员以康复治疗为主。老爸亲自为每一位伤员制定康复方案,手把手地教他们进行肢体功能训练。有的伤员因失去亲人情绪崩溃,老爸就坐在床边,耐心地倾听他们哭诉,给予心理上的安慰和鼓励。

当最后一位伤员康复,坐上回家的列车时,老爸望着远去的列车,疲惫的脸上露出了欣慰的笑容。这三个月,他们用专业与爱心,为 100 位灾区伤员带来了新生的希望,在抗震救灾的历史上留下了浓墨重彩的一笔。

那是一场严肃的政治任务,也是骨科专业技术考量,三个月下来,他们完成这一光荣任务,伤员全部安全康复送回家乡。这是一次历史功碑,为灾区尽了一个医务工作者应有贡献。

七.靠输血买专业书的医生

一个时代,一种活法。可是,一个享有盛誉、对医术精益求精的医生,非卖血不能拥有医书,这样的事现在很难想象。

医生常有紧急情况下自己输血救病人的例子,老爸在行医过程中也曾有过。但靠卖血去购专业用书,古今中外应不多见。

医生受人尊敬,但却是清贫的。在毛泽东时代,工资和物价均几十年不动。爸爸46元,妈妈43元,家庭收入89元一月,维持一家六口温饱,生活的拮据可想而知。其实我们从来也没有觉得苦,尽管每餐饭,一大家人才有一两碟小菜。反正大家都苦,还有很多人吃不饱饭,只能喝粥、吃红薯干呢。然而,对于热爱医学、渴望提升医术的老爸来说,最大的难题是如何攒钱购买专业书籍。

书店的橱窗里,每当摆上《外科学》《骨科学》《手术图解》等大块头医学专著,老爸就会在橱窗前驻足许久。他隔着玻璃,轻轻摩挲书脊上烫金的书名,眼神中满是渴望与无奈。那些书的价格,对他的收入来说,可望不可及。

但这些专业书是工作必不可少的。老爸摸了摸口袋里所剩无几的工资,心中满是苦涩。谁能想到,许多医书是老爸瞒着家人卖血换来的。一次300cc血,当时的价格30元,这可是平时半年也难攒下的钱啊。

攥着卖血换来的钱,老爸冲进书店。营业员惊讶地看着这个清瘦的医生,一口气买走了不少医学类书籍。抱着沉甸甸的书籍走在回家的路上,寒风依旧刺骨,老爸的心里却充满了温暖与满足。

回到家,老爸将书小心翼翼地锁进柜子里,常常在夜深人静时,才有时间拿出来研读。昏暗的灯光下,他一边看书,一边做笔记,遇到重点内容,还会反复标注。有时,老妈发现他深夜还在看书,又心疼又生气:“你看看你,都瘦成什么样了,还卖血买书,身体不要了?”有一次,老妈又发现输血后,非常生气。老爸很清瘦,担心他卖血损害了身体。老爸总是笑着安慰她:“人有造血机制,失点血无碍。这些书可都是宝贝。”

不过,除此之外,还有别的办法么?医术再精湛,也变不了钱。记得手术误餐,(那怕连续做十六小时手术)的补贴也才两角,或者供应一碗免费肉丝面。

就这样,一本本用鲜血换来的医学书籍,陪伴老爸度过了无数个日夜。它们不仅是知识的载体,更承载着老爸对医学事业的热爱与追求,见证了一位医者在困境中坚守初心、不断进取的历程。

岁月流转,当年的年轻医生早已两鬓斑白。但 “救死扶伤” 四个字依然清晰如初,无声诉说着一个医者用毕生心血书写的传奇。每当有人问起那段艰苦岁月,老爸总是轻轻抚摸着褪色的白大褂:“穿上这身衣服,就该对得起病人眼里的光。”

八.医学小改进病人大福音

老爸从医五十余年来,手术无数,在实践中他常有些小创新小突破,都取得非常不错的效果。

a.除特殊需要外,老爸所作的上千例以上胃切除基本废除预置胃管(书本上要求预置),无失败病例。这就要求精良吻合,完善止血,术中排空残胃以及术后严密观察,极大地提高了病人治疗的舒适度。

b.泛发性腹膜炎,在除去病灶及感染物之后,废弃腹腔引流,减少术后粘连。关键是术中彻底冲洗拭净。因引流物在腹腔内很快被纤维蛋白粘堵失效,徒增病人痛苦。诚然如胰腺炎、腹腔脓肿等,预计有持续溢漏者,则需双套管负压引流。

c.包皮环切术,常规术式,内外板对合不良,血肿、水肿和拆线困难等,都困扰医患双方。老爸予以改良,局部静脉麻醉,止血带下整齐切割,完善止血,人发或可吸收缝线缜密缝合,可获术中无痛、对合良好、愈合快、免除拆线等优点。

d.肛瘘挂线疗法或切除敞开,均令病人蒙受术后痛苦,且恢复期长。老爸用长效麻醉(局部注入稀释的亚甲蓝),一期切除缝合,大都一期愈合,缩短疗程。

e.控制外伤感染,关键是首诊的彻底清创,而不是依赖引流和抗生素。大量清水冲洗,消除异物及失活组织,认真消毒,无张缝合,若术后炎症反应,局部辅以酒精湿敷,用或不用抗生素,按此,6小时内的外伤,几可消除感染。

f.腹股沟疝修补,重点在腹横筋膜,以改良的Madden术式代替传统的Bassini法,大大减轻病人术后张力缝合的痛苦,也有利于愈合,且复发率大降。

除了上述以外,老爸在当地基层医院还创造了多项第一,看似十分平常,细想一下却也是十分难得的。

老爸是首批由学校分配到皖南一县医疗机构的学生之一。

老爸是皖南一县血吸虫病防治站开创人之一。

老爸是皖南一县医院放射科开创人。

老爸是皖南一县医院骨科开创人。

老爸是皖南一县医院外科开创人之一,号称外科一把刀。

老爸是皖南一县医院泌尿外科开创人。

老爸在皖南一县医院唯一一个从事过五官科、眼科、妇科、麻醉科等工作,并都取得不俗的成绩医生。

老爸是皖南一县医院第一批晋升主治医师的七人中(包括我母亲)的一个,也是唯一一位中专生学历晋升主任医师的医生。

老爸是皖南一县医院当时发表医学论文最多的人.。

老爸是皖南一县医院同时代人英语水平最高的人,词汇量让我在美国生活二十年的弟弟自叹不如。

我爸是当时皖南一县医院YJ分院和HW分院开创人。

老爸是皖南一县医院第一个在青年时完整地自学完工科一二年数理化教材的并认真做完所有习题的人。

老爸是皖南一县医院至今为止他那一辈人中仍在手术台上工作的人。

老爸是皖南一县医院当时(文革中)唯一经常自己开院救护车去出诊的医生。

老爸是高龄医生中唯一电脑、手机玩得比许多年轻人还熟的医生。上天猫,打滴滴,订美团,他都玩得非常熟练。

医学上近年来,出现大量新概念、新词汇,如转化医学(Traslational Medicine TM),靶向治疗(Targeted Therapy TT),循证医学(Evidence Based Medicine EBM)等,老爸晚年也能与时俱进,更新知识, 不断跟进。近二十年医学理论和临床,都发生了变革。随着科技高速发展,医学也有跨越式进展,日新月异,方兴未艾,药械也有革命式发展、翻新。新药和尤其是骨科器材令人耳聪目明,像吻合器、闭合器以及疝补片(repair mesh)等,老爸因一直在岗,所以,也上了这“末班车”,而老爸那一代老医学工作者的多数,被堵在门外。当然老爸掌握现代医疗技术也有力所难及的,如现已通行(Laparoscopy)外科,微创技术(Minimally Invasive),限于设备等原因,老爸没有掌握。

像老爸这样一生不求官不贪钱,只愿从事医疗技术工作,一生精益求精,在现今社会已经不多见了。老爸一生学英语、学电脑、学开车、写文章,每一项都能让人吃惊。

老爸因十年前突生一场生死攸关的大病,体力精力大不如从前,现在他半退休在家,但生活仍有条不紊,仍保持对新事物的好学之心,仍然没有放弃他一辈子所钟爱的医学。每天上专家门诊半天,时常还上手术台帮助年轻医生解决疑难问题。老爸头衔是“普外”(General Surgery)主任医师,按照现代临床医学精细分工要求,老爸在自己大病手术后这十年多来,基本上放弃普外以外的其他相关专业工作,如骨科、妇产科甚至泌尿外科等。老爸坚守这个普外阵地,希望自己在有生之年,永不落伍,永葆“青春”,能为社会尽力,能为病人解忧。

老爸大病之前,退而未休,青春不减,宝刀不老,手术、开车、上网、写回忆,还有下棋对弈,乐此不疲。大病开刀后这十年来,虽体质下降,老爸终究丢不开他从事一辈子的至爱——临床医学,他仍然没有最终选择下课,颐享天年,还是在临床一线工作。

他丢不下他的本行,医学,这是老爸终身无法割舍的情结。

老爸的手术简介

普外

从疝气阑尾炎到胆胃肝手术,60年代大量急性肠扭转、蛔虫肠梗阻及胆石症患者,为此开展了大量有关手术,巨脾切除、脾肾静脉吻合、急性胰腺炎、胆系结石症、甲状腺各类疾病治疗,手术治疗逾千例乳癌、胃癌、结肠癌、直肠癌等病例。

骨科

从骨折、骨髓炎到胸椎、腰椎结核手术,股骨颈闭合穿钉、外科截瘫、脊柱结核手术、腰椎间盘手术、脊髓肿瘤摘除术、骨肿瘤摘除以及矫形手术等。

泌尿科

从尿道修补到肾膀胱手术,肾切除、肾蒂淋巴结剥脱术,各段输尿管结石取出及尿道外伤会师修补,输尿管移植术,输精管吻合术,精索静脉─腹壁下静脉吻合术,尿道下裂修补,膀胱癌、阴茎癌根治术等。

妇产科

从剖腹产、人工流产到子宫卵巢手术,作过剖宫产(下段、腹膜外术式),子宫切除(腹式、阴式),卵巢肿瘤切除,膀胱阴道瘘修补及宫颈癌清扫术等。

五官科

从鼻窦炎手术到腮腺、扁桃体、上颌窦、乳突、鼻泪管吻合、斜视矫正等手术。

眼科

从白内障到人造瞳、眼球摘除等手术。

胸外

从肺切除到食道手术,颈动脉瘤切除吻合手术、胸腺咽管囊肿、甲状舌管囊肿、囊状水瘤切除等手术。膈上食道切除、胸顶食管胃吻合

麻醉

各段硬膜外阻滞,颈丛、臂丛阻滞,插管全麻及静脉复合麻醉等。

这些都在基础设施落后,没有导师指导,医护职工不到百人的县级医院里完成的,主要是老爸通过书本学习和大胆科学实践取得的,实属不易。

附:对话

汉阳一江水:一例膀胱阴道瘘。手术修补。12天康复出院。填补空白。开创这一手术先河。这句话是什么意思?你也搞过神经外科?我怎没印象

老爸:椎管内肿瘤就是神经外科,开颅也做过。膀胱阴道瘘,以前没人做过。

汉阳一江水:以前没人做过,是指国内?

老爸:这,都是高难度的,指我们医院,都是四级手术。

汉阳一江水:什么是四级手术?

老爸:四级手术是最高级的,腰椎间盘也是神经外科

汉阳一江水:腰椎间盘突出不是骨科吗

老爸:是两科共有的。

汉阳一江水:怎么分级的

老爸:有明确规定。

汉阳一江水:现在医生待遇低和国外差太多,只能以药养医,而以药养医又有问题,恶性循环

老爸:是

汉阳一江水:关键是医生待遇低

老爸:也是。

汉阳一江水:医生培养成本高待遇低,就易出问题,其与其他行业比。行医在任何国家都受尊重,且都生活很有尊严。

老爸:国家有责任。

汉阳一江水:另外中国伪医骗子又多,医患短时间内还会加剧。

老爸:只有躲,只有让,规避!这也让我提早结束骨外科生涯,退守普外。

汉阳一江水:称奇的是腹血回输800毫升,克服无血源难题。这血,无须抗凝亦无法抗凝(解决手头无抗凝药的又一难题),虽然,这是去纤维蛋白血,不凝,但这是处女行、首创,路是逼出来的,”时势造英雄”.理论支持和认可,是后来才逐渐见诸文献。看不太明白:虽然,这是去纤维蛋白血,不凝,但这是处女行、首创,路是逼出来的。

老爸:腹腔积血,纤维蛋白析出,就不凝了,无需抗凝,就可输入病人了。

汉阳一江水:但这是处女行、首创是什么意思?

老爸:前无此行,都加抗凝药后,才敢用。就是不加抗凝药不敢用的。

再一例是东河脾脏破裂,我与另一位同仁去出诊,就在公社的办公桌上为其就地成功作了脾切除手术,称奇的是腹血回输800毫升,克服无血源难题.这血,无须抗凝亦无法抗凝(解决手头无抗凝药的又一难题),虽然,这是去纤维蛋白血,不凝,但这是处女行、首创,路是逼出来的,”时势造英雄”.理论支持和认可,是后来才逐渐见诸文献。

繁昌新林剖腹产,横位,子宫先兆破裂,不敢再转运,只得就地行剖宫产,办公桌上当手术台,顶上拉布挡灰,地面洒消毒水,吊上水,局麻下手术,救了两条人命,也是腹血回输的。

汉阳一江水:这是那一年呢?

老爸:68年前后。何湾那个也是这血,无须抗凝亦无法抗凝(解决手头无抗凝药的又一难题)

出生地留影