黄: 世界语不能算是自然语言吧。

世界语算是准自然语言。诞生不自然,发展自然了。

毛: 实际上有用世界语于日常生活和交流的吗?

有啊,在 “世界语国(Esperantio)”,我有系列博文谈世界语传奇,有空光临:《我的世界语国》, 还有《朝华午拾:世界语之恋》,名字都挺文傻的。没想到混到理呆的群里来了。

黄: @wei 为什么许多革命者喜欢世界语呢?就是说革命者倾向于拥抱新鲜事物?有创新精神?

黄老师,我觉得所有人都会喜欢世界语,如果有时间领略的话,不带偏见的话。关键是,我们一辈子匆匆忙忙谋生,无暇顾及罢了。世界语是可以让任何喜欢语言的人入迷的东西,不仅仅是革命者。

毛: 革命者倾向于理想化

世界语的魅力和美丽,毛老这样的可以 fell in love,不能自拔的。

北: 语言能用不就得了 严谨不见得是好事,世界语就是垃圾,毫无美感

你不知道你在说什么。美感是一种平衡,你不能领略这种平衡的美妙。

毛: 我觉得这正是一个缩影:革命者倾向于理想化并把事情推向极致,但是在实际生活中却行不通。

北: 同意毛老师 一致化 理想化是革命理想的缩影。

美感既可来自规则的完善,也可来自事物的模糊和朦胧。要看你倾向于科技还是艺术。

北: 从美感来说 语言的最主要功能不是准确表达,反而是不准确的表达。

毛老说得对。Beauty is in the eye of the beholder. 情人眼里出西施。美感无法强求一律。但是严谨度是可以测量的,简洁度是可以测量的,歧义度也是可以测量的。

毛老写程序,会觉得某些程序很美,而文傻写的程序就不美即便 working。这也是语言的美。

毛: 对,物理学家和码农的美感肯定跟诗人不一样。

北诗人也不比洪诗人。诗人之间美感也有不同。

qj: 如果语言无比严谨没有歧义,各位也就没有这工作机会了也没得争辩哈哈哈

那是,要都是世界语,我就没啥活做了,也没的神侃了。是人都可以写个世界语 parser 出来。当然还是比电脑语言难,但是毛老写个 Esperanto parser 没问题。

北: 如果无比严谨 那就是计算机语言了。世界上觉得程序比小说好看的人是有,但是太少了,根本无足轻重。

毛: 世界语也做不到上下文无关吧?

关于美的争论是不毛之争,没有什么价值。

北: 但是可以肯定,如果大家都说世界语是不美的。因为没有了变化和差异性。

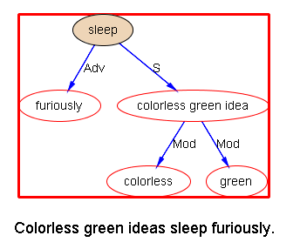

上下文无关不无关,是乔姆斯基的陷阱。真个儿满拧。根本就不该使用这个概念来对自然语言做归类。记得30多年前,曾经有很多的论文陷入这个争论,自然语言是无关的,还是敏感的,还是微弱敏感的(mildly sensitive),完全不着边际。还是白老师说得好,本来就是一个毛毛虫,非要画几个圆圈,然后讨论哪一个圈合适自然语言。这是乔姆斯基误导了一代人的一个典型例子。

北: 我知道北京世界语协会的活动地点,在取灯胡同一个饭馆。

中国世界语运动在改革大潮中已经七零八落了。大家忙着挣钱和谋生,少有世界语情趣了。

北: 世界语衰落是历史的必然。

可是我现在自己跟自己还常常说世界语。我女儿受我的影响也学了,所以我们手机 text 对方时候常常用世界语:kara mia, kiel fartas vi? amegas vin!

毛: NLP是大数据处理中绕不过去的一环,以后要是一点不懂这个就不足以言大数据了。

毛: 世界语在世界上的现状怎样?

世界语容易受到两种人的欢迎,一种是革命者,一种是理呆,特别是码农或者学逻辑的人。

大约几千万人吧。大的城市,无论哪里,大多有世界语俱乐部。

毛: 当年瞿秋白就是学世界语的,是吗?

北: 多为迂腐木讷的持左派意见者

很多名人都学过,迷恋或推崇。毛老要是学了,我担保你拍案叫绝。

毛: 但是这个东西毕竟不接地气。

不在这个,在它活生生地揭示了一个语言可以做到怎样的简洁,而仍然保持表达力的丰富。这种极致是难以想象的。

毛: 你讲的也有道理,当年我读《反杜林论》就有点拍案叫绝的味道。

柴门霍夫在简洁和易学里面所玩的平衡是极其艺术的,他在世界语方案发布之前,已经烂熟于心。

用了一辈子世界语,可以找到一些瑕疵,当年可以有另外的设计。但是总体而言,这是在领略一个超级天才的超级表演。自然语言被认为那么复杂、深奥、那么地不逻辑和强盗。到了柴大师手中,变戏法一样,变成如此规整简单,但它仍然不失自然语言的本性,而不是电脑的语言。

北: 那只是一套规则,不是活的语言,我觉得已经失掉了。

毛: 世界语 ------〉 共产主义,柴门霍夫 ----〉 马克思,世界语学者 ----〉革命者

北: 同意毛老的类比,我的实际感受也是如此。

简单说两句 馋馋您

所有的词类都是明确的,没有例外:

名词 -o

动词 -i (-as -is -os -us -u)

形容词 -a

副词 -e

有美丽 bel-a

就有丑陋: mal-bel-a

有 高: alt-a

就有矮: mal-alt-a

有兄弟 frat-o

就有姐妹: frat-in-o

毛: 世界语规则 ----〉 计划经济规则

有爸爸 patr-o

就有妈妈:patr-in-o

有好 bon-a

就有不好 ne-bon-a,or ne bona

这样的语言不是太单调么?是的,要简洁,就免不了单调一些。但是柴大师的高明之处在于,他在把实词规范化以后,有意定义了一批小词,这些小词是需要死记的,但是我们前面说了,这对每一个自然语言都是如此,是语言形式的重要的种类,可以枚举,而且常用,因此没有多少记忆负担。结果,一个语句的单调性被弥补了。因为语句总是由各种小词把实词联接在一起的。语句听起来就开始有跌宕,不再像一个机器人说的话了。

你说他有多了不起。

毛: 不讲世界语的人 -----〉小生产者、自发资本主义、自由主义者

不懂情调的人。

毛: 被翻译成世界语的文学作品多吗?

第一本是《圣经》,柴老自己翻译的。他还翻译了一些名著,以表明语言的表达性。后来的人有很多致力于名著的翻译,包括国内的世界语者。

北: 翻译量不说明问题 得看有没有读者

我的远房师兄周流溪教授翻译了《离骚》。

基本上,所有的名著都有世界语译本了。

毛: 但是这些努力基本上都白费了。

是小众,但是薪火相传,不会灭绝。总有一部分人会被迷住,因此传承。谁知道呢,也许哪一天世界大同了,需要立一个共同中立的标准语,为了反对歧视和政治正确,世界语被选中了呢。

英语成为实际的世界语,连我这个英语专业的人都不平。什么鸟语言,,居然堂而皇之统一了世界。英语丑陋之处太多了。

毛: 所以这个东西跟共产主义的相似度确实很高。

那乔老爷应该喜欢世界语了?

没有报道。他好像没有评论过。乔老爷作为超级语言学家,其实懂的语言不多。有很多批评说,他的语言学受到他的语言能力的局限。

Michaeོl Mi: @wei 柴门斯基的母语如果是汉语,或者其他非拉丁语,设计出来的世界语会是怎样的?抑或无解?

我觉得无解,柴老已经最大限度地把欧洲语言抹平了。

毛: 如果有人采访乔老爷,这世界语倒是个很好的话题。尼克?

如果要想进一步抹平印欧语系和汉藏语系,难度太大,很难自然起来。

毛: 那时候还没有程序设计语言。如果放在现在,柴氏也许会干脆就定义一种形式语言?

Michaeོl: 秀才认字读半边。抹平的难度应该不大。剩下的半边用来释义即可

反正我觉得柴门霍夫已经走到极限了,世界上怎么会有这样的语言天才。他就是个眼科医生而已,业余爱好语言,并没有语言学的培训。可是语感和对语言学的自发领悟是令人惊异的。只能说,这个世界上存在一些让我等小民高山仰止的人物。他就是一个。崇拜他不亚于崇拜乔姆斯基。

毛: 我正想问你,更崇拜乔老爷还是柴医生?

不赞同乔姆斯基,但是没有乔姆斯基,我们很多东西连一个 reference frame 都没有,无从讨论。

Michaeོl: 柴门应该是把etymology重新梳理了一遍而已。有人要是把说文解字也梳理一遍应该也可以,但中文最大的障碍是创新精神,除去迷信祖宗之法不可变的信徒后就不剩几个了,所以文字改革在中国会很慢 @wei

乔氏还是胜于柴氏。乔氏是爱因斯坦级别的,柴氏还不到牛顿吧。

毛: 要论对于人类的贡献,对于生产力的促进,乔老爷高多了。

柴也到不了牛顿的级别。我看相当于当下在搞统一场论的那些人。

柴氏基本是个江湖艺人,不是乔老爷这样的理论大师。

毛老读《反杜林论》拍案叫绝。我在高中的时候,是读《政治经济学教程》拍案叫绝。因为读得太投入,后来在社科院修《资本论》(必修课),砖头一样厚的,轻松拿A,觉得马克思太啰嗦了。同样的论点 车轱辘转 反复论证 各个侧面 苦口婆心 不厌其烦。

毛: 我到现在还认为这本书不错。我觉得恩格斯的水平其实比马克思高。我是说《反杜林论》不错。

那个我没读。五体投地拜倒在马克思《资本论》以后很多年,才发现和认可了批判马克思的声音。

毛: 苦口婆心 不厌其烦其实倒是好的,但是《资本论》其实是《非资本论》,完全抹杀资本的作用明显脱离实际。

正是,藐视资本,无视资本的作用和价值,这种偏向是致命的。

毛: 所以,我觉得世界语学者有点像人民大学那些一辈子教马列的人。但还是要好一些,无用总比有害好。

马克思虽然是严谨的学者,至少写《资本论》比《共产党宣言》要冷静得多,但是骨子里他是带着对资本和铜臭的极端厌恶这种情绪去著述的。而对资本和铜臭的厌恶是如此的自然,我们都曾经历过,都有这种体验,都曾痛恨过这个金钱至上的社会风气。

毛: 我觉得他也不是那么严谨,把辩证唯物主义应用于历史研究,按说是很好的,但是他的历史唯物主义就说不上很严谨,把阶级斗争提得太高了。

那个不算。《资本论》本身从形式上看,是严谨的,引用一丝不苟,耗时几十年,呕心沥血,反复推敲。

也做了一些对情绪好恶的抑制,譬如认为虽然是剥削,仍然是在等价交换的框架了。这个等价二字(褒义词)就是压抑了对资本及其人格化的厌恶。

Nick: 恩格斯民科

毛: 他用的是演绎方法,但是演绎的出发点是公理,如果这个前提站不住,那么后面的逻辑运用都是白搭了。其实哲学家们在科学方面都只是民科的水平。

Nick: 恩格斯哲学也民科

毛: 我倒觉得他比马克思还好一些。

北: @Nick 应该叫民哲

Nick: @北 我是generally说票友的意思,比如说你是民鼓。

毛: 鹏兄这民鼓可比许多专鼓高多了。

北: 我的目标是民仁 谢谢

白: 伟哥楼歪了

白: 我赞同“世界语是垃圾”

RW: 白爷,愿闻其详

Nick: 我儿子这学期选了门social linguistics(?)的软课,选课主要原因就是老师答应老乔会来。我可以让他问问老乔他怎么看世界语。

美不美不好争,垃圾还是宝贝就更不好争了。你的美味是他人的毒药。

Michaeོl: One man's meat is another man's poison

北: 所以每个人只要真实地忠于自己内心表达观点就好了。因为每个人都只能代表自己

RW: @Michael 让我想起电影 汤姆叔叔小屋 里的一句台词

Michaeོl: @RW 这是新概念英语里一课的题目。在座都学过吧

北: 如果对于你是毒药 没必要因为对他人是美味 就考虑到底该怎么说

洪: https://www.esperanto-usa.org/en/content/noam-chomsky-me-and-esperanto

Noam Chomsky, me, and Esperanto

Back in the 1970’s, I sent Noam Chomsky, the famous MIT linguist, a letter asking his take on Esperanto. His reply indicated some possible interest (at least, as I recall, on the part of his son), and so I showed his reply to my father, who sent him a letter urging Professor Chomsky to obtain a textbook and other materials and begin learning the language. Chomsky’s reply was, as close as I can recall, “I’m sorry that I cannot meet your expectations, but we all have our priorities. Otherwise life would be impossible.” And that was the end of that. I still have this correspondence, of course, but it is in storage back in the States (and I am in China), but I thought that this tidbit ought to be part of the annals of Esperanto.

Mike Jones

Beijing

28.Jan.2011

可惜大师没机会学。他priorities是批评美国。不过也是车轱辘话多。少一点车轱辘话,两个世界语也学会了。

毛: 这个Mike Jones是个什么样的人? 他2011年初在北京。

【相关博文】

《我的世界语国(1)》

【我的世界语国(2)】

【我的世界语国(3)】

【我的世界语国(4)】

《我的世界语国(5)》

《立委随笔:Esperanto: 爱斯不难读》

《一小时学会世界语语法》

《乔姆斯基的“世界语”》

立委世界语文章 (1987): 《中国报道:通天塔必将建成》

ZT: 中外名人论世界语

《立委随笔:世界语跟宗教的关系》

《立委随笔:熵和世界语》

立委世界语论文(1986): 《国际语到汉语和英语的自动翻译》

立委硕士论文:世界语句法分析立委硕士论文全文(世界语版)

《朝华午拾:shijie-师弟轶事(3)疯狂世界语》