分类: 杂类

《夫子遺墨:附錄:李應會先生榮哀錄》

| From Old Photo for... |

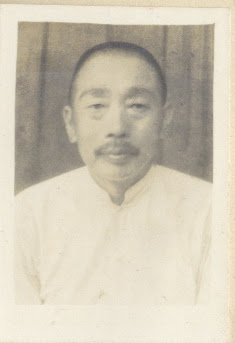

叔爺李應會遗像

立委按:小叔爺李應會民國二十二年(1933)不幸早逝,年僅31歲,是李家衰敗的開始。親朋好友,後學門生,編纂《李應會先生榮哀錄》記述其生平事跡,緬懷其品行為人,閱之令人感慨萬端。曾祖父李老夫子已過六旬,先已喪妻,繼又喪子,風燭殘年,日薄西山。命運多舛,國難家憂,顯赫一時的李大家族,從此一蹶不振。及至家父出生,家貧如洗,至食不果腹。

======================================================================

附錄:李應會先生榮哀錄(158-188);

序一(159);

序二(160);

祭文(161-174);

胞兄應文: 哭弟文(161);

孤子名毅/樸/俊: 祭文一(李步霄先生代作)(163);

胞侄名勤:祭文二(張佐槐先生代作)(166);

胞侄名實: 祭文三(牧克遒先生代作)(167);

侄婿佘之濤: 祭文四(172);

輓聯(174-186);

跋(187);

======================================================================

李應會先生榮哀錄-序一

應會號覲同,學香世兄之三公子也。皇祖考香齋公學博,余先大人門下之高弟,道高望重。余兄鴻綱、鴻鈞,弟鴻騫、鴻淏,曾師事於其家。端木氏雲,教不倦,仁也。由斯以潭,仁者必有後。應會殆仁人之遺也,應會幼英敏,博聞強識,倜儻不群,甫弱冠,買舟東渡,肄業政科數年,觀窮山海,兼參中外之學說。昔太史公游歷名山大川,其文疏蕩有奇氣,斯之謂歟。方其取學士位而返國也,熱心教育,服務黨政,多歷年所,藉藉有聲。地方人士公推爲都董,清鄉所經過,宵小斂跡,閭閻得享夜眠帖枕安。此雄才大略,可見全豹之一斑。噫,青年子弟,沉溺於膏粱文綉,假求學之名,明從徵逐以取快,而於時艱日亟,莫一籌之或展者,其孰得孰失,孰成孰敗,當有定評矣。今年春,應會丁祖母艱,奉父兄命詣蕪辦喪事,會余以公務晉省,未與多敘寒暄,悵甚。秋復來蕪,適王專員開行政會議,本邑令汪公在座,相與盤桓數日。凡應會所談,俱中切要,有可見之行事,壯志有爲,需以異日,不謂旋裡後,竟忽焉歿矣。余聞耗太息者久之。吁,俊彩星馳,萬民所望,英雄日暮,千古同悲,爰集句以寄慨焉。

民國二十二年歲次癸酉仲冬月中澣世侍生策琴佘鴻書撰

======================================================================

李應會先生榮哀錄-序二

語曰,英雄造時勢,凡時勢之改革,必有無數英雄,爲之斡旋促進於其間,而新時勢始能實現。是故英雄之存歿與時勢不能無關。繁陽李政學士應會,吾師之三少君也,幼而聰穎,且好學,一時多有神童之目。稍長繼乃兄由高小而中學而東渡,已嶄然露頭角。迨學業歸來,從事政教,聲馳兩皖。晚近充任都董,時人多爲有不遇之嘆。而先生奔走公務,席不暇煖,若有所得者,意謂積社會而成國家,苟能台服務社會,實利及民,其功不在秉國政者下也。孟子雲,天將降大任於是人也,必先勞其筋骨。先生不辭小職,特借此以練其才能歟。倘邀天假,大器必成,宏猷得展。其爲英雄的矣,能造時勢審矣。無如年方卅一,召赴修文。噫,斯人不壽,蒼蒼者豈獨禍李氏也耶。想夫先生之辦黨也,勷政也,供職衛戍團也,服務鄉邦也,在在得人信仰。以一青年,博學多能如是,其才謂非天授歟。天授其才,復奪其算,命耶數耶,何其不可知耶。且死爲人所不免,太史公曰,死有重於泰山,有輕於鴻毛,凡宇宙之大,死而湮滅無聞者,難以更僕數。獨先生之死,遠近含悲,於此可見人之悲先生者,固有所爲,而先生之致人悲者,亦有所在也。秀柏不才,館於其家有年矣,教授之暇,受啓迪者甚多,今一旦音容頓杳,趨步無從,悲傷固不勝,而瞻彼前途,國運方新,英雄遭折,能無時勢之嗟乎。今因榮哀錄匯齊,故力慫乃兄梓行,世之閱者,當與予有同然之感也夫。

民國二十二年歲次癸酉仲冬月中浣勁青何秀柏敬撰

=====================================================================

李應會先生榮哀錄-祭文

哭弟文

嗚呼會弟,今竟死耶。想夫汝繼吾而東渡也,少年倜儻,氣宇非凡。學校考試,常列前茅,使吾時有不如之愧。及吾膺留日同鄉會會長,來往公牘,多出汝手,而汝之聲聞漸著。吾嘗私計曰,有弟若此,諒不至中年而遽分手也。迨吾畢業返國,服務省立第八師範,當時吾皖教育,基金不足,省立學校,寥若晨星。如欲振興,非多設私立學校,不能收普及之功。汝曾隔海以此函告。越明年,吾爲安徽法政專門學校教師,汝又以前言函促者再。期滿辭職,爲應社會所需,遂創辦成城中學於皖垣。汝適畢業湍回,襄理一切,僕僕風塵,奔走呼告,以促時人之註意。事雖不終,而熱忱教育,頗得皖人之諒解。吾以才輕任重,抱採薪憂,汝本孝敬之心,力慫吾歸就養,兼同供子職。詎知汝樂育英才之志願,不以環境惡劣而稍減,又辦崇實高小於家中,遠近就學者踵相接。於是校務日益重,家務日益繁,而吾之病又有時而增劇。汝以一身,忽而教授,忽而經理,忽而承歡於重幃,忽而問病於床次。食少事繁,形容消瘦。家人引以爲慮,汝猶慰曰,青年瘦減,不過一時,終當易於復元。初不謂汝殞命之病根,竟遠種於斯耶。厥後吾病漸痊,汝因無內顧憂,又從事黨政數年,誘掖後進,不遺餘力,鋤強扶弱,歌頌者遍桑梓。連年奔波,清瘦益甚。吾猶以汝體雖弱,汝年尚幼,若有不大介意然。詎料今歲春以祖母喪事,內外獨持,而體格遂有不可支之狀。今竟一病不起,汝之事功尚在,汝之形骸何往耶。嗚呼哀哉,總汝平生,品貌闊大,氣象軒昂,言論豐富,書法勁秀,無一不福相。嘗聞文字足徵一生休戚,今若此,何其言之不驗耶。吾兄弟三人,汝最幼,青年竟不祿。從今以後,吾無進取之意矣。嗚呼哀哉!汝子三,皆聰穎,可繼志,吾與汝二兄當撫養成人,汝女教養出嫁,汝可無慮於泉下也。所難堪者,老父流喪明之淚,三孤興失怙之嗟。人亡物在,觸景生情,未免有情,誰能遺此乎。嗚呼哀哉!

民國二十二年歲次癸酉孟冬月胞兄應文泣書

=====================================================================

祭文一(李步霄先生代作)

嗚呼,天下大可傷心者,死別而已矣,其尤大可傷心者,吾父之死別而已矣。何則,均是人也,有可死之人,有不可死之人,同是死也,有可傷心之處,有可不傷心之處。其上焉者,行年或逾周甲,對堂上雙親,均已送老,對膝前諸子,各已成年,如是者生固可喜,死亦不足悲。次焉者,年屆四十五十,雖高堂有垂老之親,而主器果有壯年之子,身雖亡不能終養其父,而孫既長猶能代養其祖。如是者雖不能死,而子能代養,尚能勉強應付門庭矣。傷哉吾父,而今年幾何耶,壽幾何耶,甫逾三旬,此生豈算老耶。仰而視之,祖母雖亡,祖父儼然在堂也,俯而視之,男樸年方九歲,男毅年甫六齡,男俊年甫五齡,亦群然而侍側也。今一旦不幸身亡,堂上拋垂淚之嚴親,庭前撇麻衣之孺子,而況此外又有諸伯父與吾父,正所謂如手如足,相愛相親,而片刻不能相捨者也。傷何如哉,傷何如哉!然此特據吾家庭之變骨肉之悲而言之耳,若追悼吾父之生平,其最可傷心之處,更有不堪述者。聞吾父自東髮授書以來,趨庭承訓,學詩者幾何年,學禮者幾何年,稍長而肄業磕山公學幾何年,負笈於赭山中學貴池中學又幾何年,厥後飄洋航海留學東瀛更幾何年。學成返國,父嘗雲,丈夫生天地間,不能效力於國家,亦當服務於社會。用是熱心桑梓,服務鄉邦。綜此三十年間,凡所以盡義務而謀公益,吾父之身,蓋無一日暇。吾父之心,亦無一日安矣。推吾父之心,意謂今日竭我心力,以經營於鄉村裡社,即由此推廣材識學問,異日便可以展布於天下國家。嗚呼,吾父之心則大矣,吾父之志則高矣。其如吾父之壽命,乃不幸而薄且短者何耶?豈吾父當年求學心切,用神過度,而損害及於腦筋歟。抑吾父奔走社會,積勞過甚,而至夭折其天年歟。昊天不吊,貽我喪父之悲,小子何辜,抱六旬將衰之祖父,其將傷如之何,吾父同出同入之諸伯父,其又將傷如之何。吾哀哀之慈母,以及呱呱之予小子,其更將傷如之何。父其知也耶,其不知也耶,行將發靷,哭奠一觴,父其有靈,來格來享。

孤子名毅/樸/俊泣血稽顙

======================================================================

祭文二(張佐槐先生代作)

嗚呼,吾叔胡一旦溘然而長逝耶。吾叔與吾父同胞三人,叔居末,聰穎超凡。童年勵志學校,屢冠全軍,大父寵愛之至。將近弱冠,繼我父同游瀛水。卒業歸來,聲赫名炫。我父思得英才教育,於民十三年間,假皖城地點,創辦成城中學,吾叔實左右之,爰主持校務,力任艱難,成績斐然,頗爲皖賢所許。嗣因太王母壽逾八旬,大父又年近花甲,吾父與吾叔思歸奉養,展厥孝忱猶耿耿不忘,只得暫行停辦,而培養人材之志願,又於民十五年份,開辦高小於家中,名曰崇實。一時求學青年,惠然肯來,遐邇無間。吾叔上對高堂兩代,菽水可以承歡,下對學子四方,教育得以普及,由是品望日隆,聲稱益著,迨都董改選,地方人士公推吾叔充任,叔以剛方之氣,問事家鄉,務使利爲之興,害爲之除。數年來雖操勞過度,瘦骨猶可撐持。惟今歲四月間太王母仙游,吾叔抱愛敬父兄宗旨,內外事務,獨任一肩,繇是不甚強壯之體,變爲孱弱之軀。尋至重陽節候,病入膏肓,問卜延醫,終覺罔效,遂於十月十一日夜間喉痰作阻,撒手西歸。嗟乎,吾叔年方卅一,究有何辜,而遽遭上蒼忌刻乎。既而思之,有才無命,自古已然。彼漢之賈生,吳之公瑾,春秋聖門之顏淵,類皆若是,豈獨吾叔爲然。所慘者,吾叔去矣,西河增痛,北郭興悲,況吾儕分居侄輩,能不淚灑竹林,而抱無涯之痛耶。明當發靷,泣奠一樽,叔其有知,來格來歆,哀哉尚饗。

民國二十二年仲冬月胞侄名勤泣言

======================================================================

祭文三(牧克遒先生代作)

嗚呼,寒風初度,天地爲愁,晚雪欲來,山川失色,歲律雖暮,春氣仍回,胡上天不吊,吾叔竟棄侄等而永逝耶。侄幼,凡吾叔所經過之苦心孤詣,有最足以傷其身體者,未及記憶,聊就吾伯吾父所含淚而不能已於言者,爲吾叔略敘其辜較焉。吾叔生而聰穎誠篤,甫四齡,每以口所授之論語,爲嬉戲原料。諺雲,爹娘痛盡頭兒,吾祖父/母鐘愛之不爲異,吾伯曾祖父/母本生曾祖父/母尤視若掌上珠,迨吾伯曾祖母七旬棄養,叔固幼,吾本生曾祖六旬棄養,叔亦僅八齡矣。十歲時吾祖延師至家,註重五經四書並小學讀本,吾叔勤於誦讀,唯體弱氣虧,吾祖時以爲憂。十二歲就磕山公學商小肄業,畢業後仍就塾師補習中國文字,則又以子史經傳爲大宗,至民八年吾叔年十七矣,是年由貴池六邑中學改進安徽省立第五中學,即今之七中也。民十年吾叔以潮流所趨,進化愈促,非有中外學識,不足以供社會之取求,爰有留英留美之請。伯曾祖以遠道爲梗,吾祖嘉其志,命就日本明治大學政科,以吾伯就是校法科二年級,兄弟相照顧,吾伯曾祖可稍稍放心。不謂是年暑假,吾伯回裡省親,吾伯曾祖享年八十有九,竟染恙數日而捐館捨矣。且遭家不造,吾伯之子長名譜九歲次名留四歲,亦相繼殤矣。吾叔聞耗哭泣,傷如之何。夫以一弱冠書生,課案埋頭,不勝旁午,故園回首,實屬含辛,此足以傷其身體者其一。民十一年吾伯法科畢業,領學士證書返國,吾叔送至橫濱,攜手談曰,當今黨政維新,需人孔急,吾兄此次榮歸,當以教育爲前提。是年吾伯偕友人同辦安徽省立第八師範。民十二年就安徽省立法政專門教職,兼授江淮中學課。民十三年辦成誠中學於皖垣,適吾叔畢業回裡赴皖。凡校內若何布設,若何教授,吾叔爲之籌劃,頗得皖人之信仰。此其操心積慮,足以傷其身體者又其一。民十四年吾伯抱病皖城,吾叔篤於友愛,停辦本校,偕兄歸裡休養。適叔母姚系第二屆省議員學銘公之長女,亦由本邑肇興高小女校畢業回,吾祖奉吾曾祖母命,擇吉完婚。時知繁昌縣事舒公兆華,駕臨證婚,並本邑南鄉都董汪公理卿北鄉都董李公步霄等勷贊禮儀,一時群賢畢至,少長咸集,人皆以爲華,而吾叔不甚色喜者,以教育熱其中也。爰與舒公磋商,在家辦一高小學校,名曰崇實,轉請備文教育廳立案。民十五年知繁昌縣事操公震,以辦學得法,特來訪會,並加激賞。吾叔此時既望收樹人之效,又恐貽覆餗之譏。此喜懼交迫,足以傷身體者又其一。無何天不從人,命途多舛。民十六年吾祖母享年五十有二,又一旦仙逝矣。吾叔以苫塊余生,因思子輿氏雲,親喪固所自盡也。遂與吾伯吾父計劃喪事,遵本生曾祖母與祖父命,舉行正式成主鉅典。時知繁昌縣事寇公超,駕臨鴻題,賜以閫範猶存四字輓章。本邑都董張公蓮溪籲俊高小學校校長胡公樵松等,同時贊禮,非直爲觀美也,必如是而心始盡矣。至循居喪之道,卜安厝之區,已不知幾費躊躇矣,此足以傷其身體者又其一。民十八年吾本生曾祖母嘆曰,會兒留日,得學士位返國,連年從事教育,未曾舉行畢業典禮,恐非榮宗耀祖之道也。吾祖稟命之下,擇吉期,設禮堂,鼓樂喧天,親朋滿座,時知繁昌縣事章公維燮駕臨慶賀,賜以名顯玉堂四字橫額。縣黨部亦贈以黨國健兒四子賀帳。同年地方公推爲都董,率隊清鄉,閭閻得以安堵,吾叔一孱弱之軀,時而攢(?)勷黨政,時而照料桑梓,僕僕風塵,日不暇給,此足以傷其身體者又其一。民二十年吾叔供職首都衛戍團。二十一年暑期辭歸,山東黨部,屢次電招,同勷黨政,吾祖屢命以休養身體爲辭。不謂今歲大故,哀毀骨立,吾叔曲承色笑,時以節哀順變爲慰,但喪事禮節,當實事求是,況吾曾祖母一生淑德,尤地方人士所素欽佩者也。吾叔與吾伯吾父交相計議,設治喪事務所,吾伯吾父經理內部,吾叔主持外部,當神主告成期,請前任蕪湖警察廳廳長何公樹德,駕臨鴻題,並賜以寶婺星沉四字輓帳。時知繁昌縣事薛公繼昌,因與吾伯吾叔同畢業於赭校,亦執後生禮往吊,以閫範留芳四字輓帳獻之。他如蕪紳佘公紀堂,本邑教育局局長任公圖南等,俱同時勷禮。即此車從盈門,輓歌滿室,可相見吾叔之周旋計劃,盡敬盡禮,殊非易易也,此足以傷其身體者又其一。綜吾叔生平,嘗學途之苦,履家運之艱,起處不遑,精神頓憊,然休息靜養,一旦霍然,亦意中事也,乃竟至一病不起,此豈吾叔所及料,抑豈侄等所及料哉。且吾祖行年六旬有一,無心於世事久矣。吾叔以一介青年,訓佩鯉庭,達前人之後步,名馳鵲水,樹黨國之先聲,設今日者憂抱採薪,喜成勿藥,則參苓收效,杖履消閑,時而怡悅父兄,敘天倫之樂事,時而撫摩子侄,追康樂之遺風,優哉游哉,自適其適,風流瀟灑。吾叔固樂厥燕安,日侍起居,侄等亦喜同雀躍。奈何遭屯艱時勢,生不逢辰,值鼎盛春秋,命難由己,一朝撒手,千載傷心,侄等殯殮躬親,頻灑蓋棺之淚,笤蒿式潔,空拈致祭之香。嗚呼,天耶,數耶,抑侄等不福,遂令吾叔早促其生耶。嗟呼,天地逆旅,一大悲傷,喪葬余哀,幾無終極,當此寒門雪壓,分明待駕鸞彪,將來華錶風清,是否能聞鶴唳,詰朝發引,泣奠一樽,叔其有知,鑒此微忱,嗚呼哀哉,尚饗。

民國二十二年仲冬月胞侄名實泣言

閫 拼音:kǔn

◎ 门槛,门限:“送迎不越~”。

◎ 特指城郭的门槛:“~以内者寡人制之,~以外者将军制之”。~外。

◎ 统兵在外的将军:“即具以北虚實告东西二~”。~职。

◎ 内室,借指妇女:~闱。~奥。~德(借指妇德)。~范。

◎ threshold; women's quarters

籲 拼音:xū yù

◎ 见“吁2”。

◎ appeal; request; implore

婺 拼音:wù

◎ 〔~水〕水名,在中國江西省。

◎ 〔~绿〕产於中國江西省婺源县的茶叶,是绿茶中的珍品。

◎ 〔~女〕古星宿名,即“女宿”。

◎ 〔~剧〕中國浙江省地方戏曲剧种之一。

◎ name of a star

[www.zdic.net]

======================================================================

祭文四

嗚呼,庾嶺梅開,藍關雪擁,吾三叔岳胡一旦而謝賓客耶。夫吾三叔岳龍門巨族,鵲水名家,業紹書香,知淵源之有自,位爲學士,信聲價之非虛,以一介青年,具滿腔赤膽,觀成黨國,獨輸鵠望之忱,服務鄉邦,聊作牛刀之試,雖有鞭長莫及,馬腹同嗟,如逢軔發有期,熬頭可占,寧召艷笑,莫折五斗之腰,無謂雌黃,誰市千金之骨。只恐文章憎命,大器晚成,豈期夭壽無常,中年晏駕,侄婿不才,忝叨末愛,久思附驥,幸許續貂,惟松柏之常榮,庶鳥蘿之有託,回思從游二載,備警金聲,投試七中,親勞玉趾,愛猶半子,無非誼美恩明,命必重申,不惜唇焦舌敝,雖屬熱心之甚,未爲氣體之虧,時縱違和,元當易復,春風惠我,永蒙視若東床,冬雪愁人,不至星沉南極,未必白雞入夢,二竪爲殃,倘教扁鵲回春,三生有幸,不謂英雄日暮,處士星沉,蓄壯志生不逢辰,問災期歲剛在酉,塵封絳帳,仰瞻嗟北斗之傾,玷懍白圭,感泣垂南容之淚,悵泰山之鼎峙,墮厥三峰,痛師範之睽違,長茲千古,吁嗟徂矣,尚期蝶夢重親,歸去來兮,莫識鵬程幾許,想前次床頭請謁,聲氣猶清,問後來門第增輝,音容何在,嗚呼,茫茫恨海,精衛難填,鬱鬱愁城,杜康莫破,啜其泣矣,傷何如之,侄婿素切葵傾,謹陳芻東,如果英靈不昧,鶴馭能回,庶幾薄物是將,蟻忱略獻,哀哉尚饗。

民國二十二年歲次癸酉仲冬月愚侄婿佘之濤泣書

======================================================================

李步霄先生題主祝詞

邇 維

學士 聰穎絕倫,後起之秀,新進之英,留東洋蜚聲學校,返祖國服務鄉邦。夫何一旦,召應修文,身雖死而精神不死,人不存而學業常存,截木作主,曲肖其形,秉筆恭題,用妥英靈。自時厥後,在天有靈,默相呵護,佑啓後人,允宜供千秋之俎豆,享百代之香馨,祝而孝子慈孫,其世世而相承。

======================================================================

李應會先生榮哀錄-輓聯

遺言

孝敬未終,不無遺憾。

死生亦大,何足掛懷。

父兮棄養,抱恨終天。苫塊有餘哀,最難堪重慶六旬,臨幃頓灑呼兒淚。

男輩無知,偶遭大故,門庭猶是昔,竟重纍同胞兩伯,善後頻增泣弟悲。

孤子名毅/樸/俊泣血稽顙

胞兄應文/期淚書

內外共維持,孤詣苦心能有幾。

天倫敘樂事,瞻前顧後少行三。

侄婿佘之濤淚輓

人物競潮流,黨國推爲唯一子。

年冬悲雪擁,泰山掩厥第三峰。

愚胞妹汪李應瑩泣輓

最小兄奇才不偶,早知世上難留,何堪一老臨年,鯉庭承顏,空對少男悲棺槨。

未亡妹只影歸甯,自顧膝前無狀,差幸三孤鼎時,家駒發軔,可爲孀嫂啓門楣。

岳父姚學銘感言

我方謂半子可依,才具勝吾兒,少壯有爲,卜將來許成大器。

誰料得三孤失怙,喪明傷老父,短命不幸,算後去遺纍未亡。

舅父滕本富感言

時事急需才,痛茲黨國奇英,竟致幼年嗟不祿。

人生皆有命,想起潮流險惡,空教老淚灑難干。

學生牧惠通/陳世茂/王慕賢/嚴學儒同拭淚拜輓

先生真黨國英奇,未獲成功遭天阨。

後學值潮流惡劣,欲謀進化失師資。

學生尚德/牧傑/江漢/趙璧同拭淚拜輓

數載備追隨,劇憐舌敝唇焦,曾曏文壇分教授。

一堂資錶率,慘煞人亡物在,空余講席益凄涼。

學生方日新/曹善遙同拭淚拜輓

館號老蘭香,家學淵源,有難兄斯有難弟。

師原新人物,德星墜落,想遺訓兼想遺型。

學生何尤/陳善同拭淚拜輓

本中外學說,啓迪無遺,文苑著先聲,真不愧南州冠冕。

爲時勢潮流,操勞過度,芳齡參冥錄,也應推西府英雄。

學生湯哲卿/方世鎧同拭淚拜輓

絳帳憶從游,滿座春風同我被。

玉樓忽赴召,漫天冬雪爲公飛。

學生馬駿如/余步濤/李世全/湯明儒同拭淚拜輓

先生本合邑奇才,即凡鼎鼎大名,亦欲從旁瞻道範。

後死叨同堂末愛,惟想循循善誘,自茲無處聽箴言。

學生陳立柏/查貴勝/王繼鎧同拭淚拜輓

得教科宗旨,延理學家聲,綺歲作經師,立雪登門通全邑。

富黨國精神,飽中西知識,英年捐館捨,流風余韻自千秋。

學生佘之漢拭淚拜輓

設絳帳以授生徒,學說匯中西,惠我春風欣廣被。

值青年而謝賓客,文章憎命達,催人夏楚嘆空存。

後學弟陞淚輓

由兄弟列師生,曾因族學情長,隨在談心推赤腹。

以青年歸黃壤,難怪英雄氣短,不堪搔首問蒼天。

後學弟應軒輓

兄本壯志有爲,增光我邑,奈何北地談寒,南天說暖,潮流蜂起,頻來無謂雌黃,誰知末造奇才,人忌亦遭天忌。

弟以謀生乏術,糊口他鄉,尚望歸身梓裡,聚首家園,風雨雞鳴,永博靡窮燕喜,詎料半生知己,暫離竟作久離。

後學強克明/陳慶文同淚輓

對尊翁久經請業,對閣下亦屬受知,師生相契隔幽明,何處可招魂,再得來東牖談經,西窗問字。

爲求學苦渡重洋,爲辦黨勞奔全邑,心力俱虧捐館捨,自古雖有死,究何忍椿庭一老,桂室三兒。

錶弟古繼達纍輓

爲黨國健兒,有學有才有經驗,屢受折磨,生不逢辰千古恨。

奈英雄短命,棄父棄妻棄子女,遭此慘劫,死留遺憾萬人嗟。

襟弟吳枬生淚輓

忝屬姻親,過從往來,多蒙雅愛。

忽聞噩耗,鄰裡鄉黨,未免傷懷。

世姻弟牧邦盛淚輓

十餘年功垂桑梓,死亦何傷,惜吾繁政治黨綱,此後有誰照料。

卅一載名列仙班,魂兮不返,合我邑青年學子,曷勝同志悲哀。

世弟何秀柏淚輓

君昔負笈東瀛,兼中外學其所長,壯志本待酬,一夢不回難瞑目。

我今濫竽西席,令子侄幼而可畏,達人猶繼起,九京如作亦歡心。

世弟何棟梁/慶林同淚輓

十數年以心相交,方期留日歸來,一介儒永爲繁陽造幸福。

姻弟牧運沅淚輓

痛君畢業東瀛,在黨國群推首領,莫及從游政界,頓起離程,視死雖猶歸,其如俱在父兄,分手灑盈盈血淚。

愧我濫竽西席,爲他人屢作嫁衣,未曾問病床頭,細談衷曲,所生原有忝,尚期再聯姻婭,同心訂世世知交。

世姻弟牧邦盛淚輓

十餘年功垂桑梓,死亦何傷,惜吾繁政治黨綱,此後有誰照料。

卅一載名列仙班,魂兮不返,合我邑青年學子,曷勝同志悲哀。

世弟何秀柏淚輓

君昔負笈東瀛,兼中外學其所長,壯志本待酬,一夢不回難瞑目。

我今濫竽西席,令子侄幼而可畏,達人猶繼起,九京如作亦歡心。

世弟何棟梁/慶林同淚輓

十數年以心相交,方期留日歸來,一介儒永爲繁陽造幸福。

卅一載與世頓隔,差慰遺風長在,三令嗣堪承學士啓門楣。

世弟李化龍淚輓

應世不多年,有嫉妬,有謳歌,毀譽本無憑,到此蓋棺論自定。

會君未幾日,棄家庭,棄戚友,幽明頓相隔,每思遺範淚難干。

世弟徐慕唐淚輓

季子才高傾六國。

顏回命短自千秋。

世弟胡應春/民禮同淚輓

所志未酬,臨幃致短英雄氣。

有懷欲白,入夢難追月夜魂。

世弟谷振聲淚輓

王勃嘆奇才,只有鴻文傳後世。

顏淵嗟短命,誰知鶴駕更無期。

世弟古克勝/操傳彰同淚輓

涉重洋學就歸來,大展謀猷,耀祖方爲繩其武。

是青年界中翹楚,遽傷凋謝,問天何故喪斯文。

世弟陳瑤琨淚輓

君去實堪悲,念此後事情,有誰指教。

我來何所吊,想從前世誼,倍覺傷懷。

世弟強南淚輓

歸真不在壽天,只要事功卓著。

聞耗無分遠近,總教涕泗滂沱。

世弟嚴衛民淚輓

好學本非常,滿羡青年上進,有志竟成,斷勿至人去樓空,分首永嗟難再敘。

英靈何處是,即教黃壤修文,捐軀應召,試想起弟恭子孝,問心何忍作斯行。

世弟谷開平淚輓

數年爲門下生,愛我以義,輔我以仁,形跡素相忘,回思過去交情,惟是英雄能本色。

一朝參冥中錄,憑君才子,想君之志,死生何所計,獨惜將來時局,誰爲黨政樹儀型。

世弟繆宗化/張慶松/汪法鈞同淚輓

就學仰高風,笈伴簦隨,識主且欣多北道。

因時思舊雨,葭蒼露白,懷人空憶在西方。

世弟高德芬/萬大富同淚輓

彭殤難齊,夭壽不貳,前人乃爾,來著何尤,台上本忘情,惟茲化雨春風,紅豆偏教生南國。

共和初建,革命待成,時勢大難,英雄頓逝,自古皆有死,獨惜長才遠略,青年竟是付東流。

愚叔李鏞輓

沉痾四五旬,此區不回悲煞我。

磋商巨細事,從今以後嘆無人。

房叔祖達燮感言

仰學子之豐裁,惡惡從短,善善從長,問世無容心,惟是英雄真坦白。

衡人材於社會,唯唯如彼,諤諤如此,蓋棺有定論,何妨時俗妄雌黃。

族愚高高祖允禎感言

之子抱負本非常,縱教黃土埋藏,桑梓榮哀爲奚似。

我族人才大不競,如此青年凋謝,祖宗屬望究伊誰。

姻侍生牧克猷感言

侄幼本精明,名與實烈烈轟轟,大丈夫當如是也。

予老又昏聵,今而後裡裡外外,巨細事從何商焉。

姻侍生楊春柳感言

天時人事,釀成惡劇一場,魂魄如有之,請將近日新潮,再爲從頭談結果。

世誼交情,贏得相知十載,死生亦大矣,惟是因風灑淚,幾教老淚嘆昏花。

姻侍生古曉樓感言

由從學而聯姻,溯乃祖遺風,之子真能繩其武。

當英年兮辭世,何中華進化,吾繁先已喪斯文。

侍生胡官悅感言

學力冠時髦,不可小知,莫怪英雄遭白眼。

人材關運會,對茲大局,頻揮老淚吊青年。

宗侍生步霄感言

游歷越重洋,山水入懷天地窄。

聰明偏短命,鯉回不幸古今悲。

姻侍生張佐槐感言

兩世訂交情,風雨談心,好似卜商能啓我。

少年膺重望,文章憎命,竟同冉伯嘆斯人。

姻侍生潘維文感言

從游黨政,交訂忘年,方期學識風行,一邑時艱同救濟。

相距北東,耗聞遠道,且嘆英雄日暮,兩行老淚幾模糊。

友生張葆善感言

昔日憶從游,頻教聲入心通,愧我難爲東家某。

今朝聞噩耗,劇憐才長命短,教人廢讀南華經。

族叔世仁輓

棄親不孝,棄友無情,至棄卻大漢河山,問君讀聖賢書,所學何事。

同志悲傷,同鄉痛哭,惟同集一堂追悼,令我閱榮哀錄,寄慨殊深。

繁昌旅蕪同鄉會輓

此君數年航海,留日歸來,國事太迍邅,壯志未酬旋作古。

我輩一束生?(“篘”字無竹頭),望風遙奠,梓鄉何寥落,英才頓歿合傷今。

迍 zhūn

◎ 〔~邅(zhàn)〕a.路难行不进的样子,如“涂~~其蹇连。”b.困顿失意,如“英雄有~~,由来自古昔。”

[www.zdic.net]

繁昌旅池同鄉會輓

畢生以傲骨自持,鶴立雞群,東瀛曾傳書,時論共方陳無已。

舉世多黃鐘高棄,長才短命,朔風悲鵬賦,憐公何似賈長沙。

======================================================================

跋

客有問於予者曰,天地一逆旅耳,彭殤難齊,夭壽不貳,夫子豈未之前聞。今者邑北磕麓李氏應會,固留日政學士者也。返國後熱心教育,服務黨政,固可謂富學識而素有經驗者也。年卅一不祿,夫子等俯從伊兄請爲發喪,哀禮俱致,固可謂全受全歸者也。夫死生有命,孔顏不免,夫子爲之長吁短嘆,若有不豫色然者,竊以爲非達觀焉。予應之曰,唯唯,否否,不然,自來人材之存歿,國家之運會關焉,非偶然矣。時際休明,國家之命脈系於老成人之持重。若蜩螗鼎沸之秋,時事顯危,人民離亂,則又非壯志有爲之青年子,不足以綏內憂而抗外。昔漢文不錄賈長沙,而漢高必任陳韓者,即此意也。獨是今之所謂青年子者,冠服堂皇,幾有不可以一世,至語以國家事,類皆齷齪闒茸,隨其波而逐其流,無補於時艱萬一。肉食者鄙,其然乎,其不然乎。老夫耄矣,敢雲衡材,第就李學士目前之名實,相見其爲人,將來造就國家,諒不至負生平所學,乃竟忽焉歿矣,何李學士之不幸耶!抑豈獨李學士之不幸耶,嗚呼,噫嘻,李學士之爲人自此終,予之感慨從此始。如子所言,固知二五而不知十者矣。時李學士榮哀錄付梓,予爰節錄與客所問答者而爲之跋。

民國二十二年歲次癸酉仲冬月中浣世侍生馥堂桂鬱庭撰

闒 拼音:tà

小户,引申为卑下:~茸(“茸”,小草。喻地位卑微或品格低下的人)。~懦。

[www.zdic.net]

李應會先生榮哀錄終

Edited 16 time(s). Last edit at 2009-01-18, 12:41AM by 立委.

http://blog.sciencenet.cn/blog-362400-293425.html

上一篇:《立委点评:听不够的童丽》

《夫子遺墨:附載應文世兄近作-序傳類(十則)》

======================================================================

附載應文世兄近作-序傳類(119-133);

徐克林翁序(119);

程輔傑翁序(120)

何秀柏先生移帳授徒序(120)

何母鮑老孺人七十壽序(121)

孫天棟先生序(代)(124)

錢少唐先生序(代)(125)

李公洪模傳(127)

胡公永祥傳(128)

田先生傳(130)

王君加入義勇軍序(132);

======================================================================

徐克林翁序

人之錶異於眾,而為有心人所稱道者,不必披一品衣,抱九仙骨乃爾也,即一田捨翁。所說者家常話,所行者淺近事,而天經地義,悉於是乎哉。昌旺兄之尊大人也,客歲兄隨家君游,言動威儀,具成人狀,家庭教育,可想見焉。既因兄舉婚典,應文詣府慶賀,謁世伯以後生禮,見其衣冠古樸,不事花飾,無懷氏之民歟,葛天氏之民歟。應文自留學東瀛來,所過名山大川幾許,所接名公鉅卿幾許,竊見利欲驅人,廉恥澌滅,為之滄桑棖觸者久之,若世伯一生為人,所言者庸言,所行者庸行,是殆三代直道之遺也。古人有言曰,共君一夜話,勝讀十年書。由斯以潭,伯世洵有以教後生矣,至世伯母勤儉持家,克敦婦道,世兄三,課耕刻讀,各勤乃事,世侄某某,俱英敏可畏,一門豫順,世伯顧而樂之,益見皇祖業儒術為地方紳,先大人睦族和鄰,無忤於俗,其流澤孔長,而世伯特享其成者也,茲當貴族華乘告成,因不揣固陋,為之序如此。

=====================================================================

程輔傑翁序

文自負笈東瀛,桑梓人情,久疏餽問。壬戌夏畢業返國,就政於岳父牧克道先生家,茗談鄉黨事,並敘先太岳當年教授高才弟子甚多,如程菁坤程輔傑先生皆一時人傑,夫此二君論世誼是文前輩,論戚誼是文長親,而輔傑先生,尤親之至者。惜其從太岳也晚,又值武昌起義,科舉遽停,學業功名,皆不得遂其志願。今雖棄儒就農,而持家有則,不事紛華,理族任勞,毫無德色,其才略概可知矣。文今夏法專教授事畢旋裡,道經舊鎮,聞程氏修輯宗譜,菁坤先生主修,輔傑先生校對。輔傑先生,金坤公之三子也,先是金坤公創草譜,心力俱悴,今其嗣為校對,俾譜牒告成,勉承父志,先生可謂父作子述矣。語雲,莫為之前,雖美不彰,莫為之後,雖盛不傳,亶其然乎。今貴族華乘付梓,文不揣鄙陋,敢以俚言,附之簡末云。

====================================================================

何秀柏先生移帳授徒序

經固先王治世之具也,然代幾更,時幾變,文字幾經改革,而詩書易禮春秋之文,散布於天下,秦始之焚不能盡,漢高之溺不能衰,蓋有老成宿儒,承前啓後以講授之也。易曰,蒙以養正,聖功也,蒙學者,固講經之基址。晚近來科舉停,學校興,上之取士者外乎經,士之挾以自售者,亦外乎經。於是毀經侮經之論,日出不窮,並以經為無用之物,而為之講師者,多出貧窮之屋,以是為衣食之給,俯仰之資,枉己從人,以求豐其所入,遂因其毀而毀之,因其侮而侮之,亦自以經為無用之物。噫,先王治世之六經,焚而不能盡者,而盡於此,溺而不能衰者,而衰於此,風俗之薄,人心之敞,厥有由矣。為講師者,能無罪乎。何子秀柏,館於吾家有年矣。教授經學,頗有經驗,今應裡人之請,將移帳於其家,是即仲尼氏在陳思歸之意歟。然而世俗之輕視講師,與講師之自輕者,往往多有,吾恐其久而怠也,因謂之曰,天之養物也,不因人之知與不知,而私其雨露之施。日月之照,聖人之教人也,不因世之重與不重,而改其諄諄之誨,循循之誘。孔子曰,自行束修以上,吾未嘗無誨焉。樹木樹人,固有同然者也,匠師挾斧斤入山林,喬木森林,左顧右盼,應心得手,若者為棟,若者為梁,不崇朝而大廈之材畢具,退而喜曰,材木不可勝用,至於雨露之功,培養之力,鮮有知之者。蒙童者,喬木之萌櫱也,子苟培養得法,將見桃李遍植,欣欣曏榮,不數十年後,必有國師選棟梁於子之門下,而有人材不可勝用之樂。夫人材出,教化行,風俗於以厚,人心於以固,先王治世之六經,或能由此復明於天下。子之功,自有不可沒者,知與不知,重與不重,不必問也。予亦為是役者,偶有所見,敢不告子,子其勉乎哉,爰書之以當臨別之贈言云爾。

蘖 拼音:niè

◎ 树木砍去后从残存茎根上长出的新芽,泛指植物近根处长出的分枝:~枝。分~。

English

◎ stump, sprout

见 [zdic.net]

=====================================================================

何母鮑老孺人七十壽序

生辰禮節,經傳無明文,固已,然循執是說,則凡年高德邵者,湮沒不彰,不知幾許,非特不足以廣孝思也,而末俗之人心,亦無由聞風興起矣。彼沾沾於經傳,胡為乎。今者,何母鮑孺人,為登甫公之德配,秀柏君之祖母也。公世居邑北洋泥垾牌樓村,家資豐裕,自孺人于歸後,生男四女一,家務亦極繁且劇已,而公仍以農人為圩董,奔走圩務連年,非得孺人之善於照料,焉能無內顧之憂如是。迨公卒時,秀柏君年僅十幾,而其父母亦先後棄世,孺人於群孫中愛秀柏君為尤甚,凡由學校而畢業,而紳地方,在在得其撫育督責之力居多。秀柏君曾受業於家君,近館吾家有年,故吾於其家世知之較審,而秀柏君亦時為吾言其祖母之德,且以不克盡孝為懼。今年某月某日為孺人七十生辰,鄉人有欲壽之者,孺人堅謂不可,無以必待八旬。吾聞之有感而言曰,壽固在德與賢,以孺人之德,與其孫之賢,皆鄉裡中之不多見者,如壽之,則綵衣之盛,獻祝之豐,當不在鄉人下也。然猶有不敢,且期以十年,得毋有歉其德之不足,而賢有未加歟。夫德而不以為德,賢而不以為賢,則其德之進,其賢之益,十年之中,未可限量,而十年後壽之者,可以廣孝思,可以風末俗,古之輶軒下訪,播之聲詩,即此意也。彼沾沾於經傳,胡為乎?自世教之衰,所謂壽者,僅僅襲晉十之虛文,借以壯門楣增聲勢而已。孺人一女流,而所見如此,殆有得於吾心之所同然者,故序之,請懸壁間,以為八旬慶祝之左券云。

====================================================================

孫天棟先生序(代)

孫君天棟,某公之幾子,少年倜儻,器識深沉。早歲余館教化渡,從游數載,穎悟異恆兒,鐘愛之。迨拔館後,自加磨勵,文質皆可觀。雞窗之暇,間從事於地方公益,沾其惠者,奚止裡人也。民二十,大水為災,盜匪蜂起,國府通令組織鄉村聯防,以資自衛。於是教化渡民眾公推為團首總,披堅執銳,晝夜逡巡,罔遺餘力。閭閻賴以安寧,鄉人益多其功。今庚秋,以主修譜稿就教於余,余見其編紀綦嚴,謄寫清晰,血統於以正,昭穆於明,有此可以言睦族展親矣。當此世道衰微,人心澆薄,洪水橫流,邪說東漸,有骨肉而若塗人者矣,有家族而談平等者矣,一唱百和,相習成風,而有不可思議者,吾嘗謂欲固人心,須厚風俗,欲厚風俗,須增高家族觀念。宗譜者,實維系家族之權輿也。天棟之為此,殆亦有見於斯歟。夫水災之後,閭閻蕭條,鄉人有欲修譜而不果者,有經修而中止者,問之,則曰,救死惟恐不瞻,奚暇治譜事成,要之,家之譜,猶國之史也。國史不能因世亂而輟編,家譜豈能因環境而寢修,若而人者,難逃不孝之譏矣。今天棟以宗譜逾百年未修,且族人多奔走衣食,流離失所,懼其渙也,故急急從事,經費如何籌措,譜館如何布設,如何編修,如何校對,井井然有條不紊,其衛族之心,殆亦猶是衛鄉之心歟。傳曰,忠臣出於孝子之門,天棟誠能嗣後益加奮勉,將來造就,或未可量。今者,貴族華乘告成,余忝有一日之長,特書之以為吾徒範,是為序。

======================================================================

錢少唐先生序(代)

少唐先生,某公之幾子也。襟懷曠達,學識深沉,前清末造,以邑庠生設館授徒,立雪者實繁其人,迨民國肇興,為議院僚友,則語驚四座,為學校教師,則化雨均沾,政教兩界,聲聞藉藉,亦已有年。嗣因潮流日非,悲憫致感,抱採薪憂,幾有不可藥治,先生乃息影林泉,杜門不出,優游久之,而體日健,而貌日豐,而病亦日以愈。談者謂先生善養病,吾謂先生所養者,不僅病已也。晚近世風不古,道德淪亡,無論才與不才發,苟有活動之能,無不奔走鑽營,以遂升官發財之志願。成敗利鈍,姑且勿論,及其結果,有不自賊其生者幾希。噫,名利病之病人,何一至此耶。以先生之才之學,繼續進取,其事功當必有以照人耳目,然人之慾望無窮,而事之足人慾望者有盡,善惡橫生,去取交戰,有動乎中,必搖其精。莊子曰,生也有涯,知也無涯,以有涯隨無涯,殆矣。其然乎,其不然乎?今先生病病固養,病愈亦養,殆所謂超然於世俗者非耶。陞後學也,耳先生之名舊(?疑为“久”之误也)矣,今因令姪才儀君之介紹,修後生禮謁見。杯酒之余,藹然可觀。孟子云,粹然見於面,盎於背,其先生之謂乎。於此益見先生之德,其修養蓋有自矣。先生年四十餘,少君聰明可畏,達人繼起,先生之晚景,正方興未有艾也。今者,貴族重修華乘,陞不才,聊貢俚辭,以表私慕向往之情,特序之以為世之有名利病者藥焉。

======================================================================

李公洪模傳

族叔尊祖洪模,志士也。方家君長磕山公學,二弟期三弟會與之肄業時,文就學日本明治大學二年已,每假歸,家君與談所教授諸生之勤惰,不一而足,惟於公之為人,則曰,少神氣,而文字又復激烈,恐非此子之福,然家君於命相學,雖稍稍註意,文猶以此語未必驗也。卒業後,二弟佐家君治家務,三弟隨文就本校政經兩科,蓋為越國不遠,非盡繇川資之不繼也,公則一意西渡,不以道阻且長為梗,亦不病學年之久,其誠於求學,以必成為目的。古之破釜沉舟,與所謂不乘高車駟馬不過此橋者,此物此志也。厥後文與三弟先後畢業回裡,自揣菲材,濫竽於安徽公立法政學校教授兼代江淮中學課時,公於裡昂中法大學校僅三年級也,想卒業後,必不至若文之僅僅充斯役。無端課餘聞耗,文不覺形神俱失矣。是年冬,公之父命次子洪楊席請族親為公發喪,文因假歸,亦在往吊列,得悉公同學鄉友張週二君為之購葬地,預納永遠租稅於法,且建瓷像於墓前,以壯觀瞻,因成一聯雲,洪濤隔幾國海洋,魂能返否,模範垂千秋山鬥,人其萎乎。噫,文於是有無窮之感慨焉。大凡志士一身,國家之運會關焉,非偶然矣。閑嘗曠觀國於全球者,二十世紀以前,美之政治窳劣,恐不及我今日之中國。一日華盛頓游歷各國回籍後,國運維新,幾執全球之牛耳。公之留法,得毋豔及此而欲新吾中國乎?文不敢知曰,公之學成回籍,必能有造於中國,如華盛頓之於美也,文亦不敢知曰,公之學成回籍,必不能有造於中國,如華盛頓之美也。今者長此終古,命耶數耶,抑天之不欲啓吾中國耶?雖然,公已矣,文恐有志之士,以公故而氣短也,文尤願有志之士,以公故而力爭之,則庶幾中國大有人,中國大有造也,因不揣固陋,勉為公傳,以質諸求學之有志者。

窳 拼音:yú,

◎ (事物)恶劣,粗劣:~劣。~败(腐败;败坏)。~陋(粗劣,质量很差)。良~(优劣)。

◎ 懒:~惰。

◎ 瘦弱。dirty, useless, weak, powerless; cracked, a flaw

见 [zdic.net]

======================================================================

胡公永祥傳

文幼受家庭教育,粗知文字,而於一時素稱賢達者,固未嘗一相識也。及稍長,而高等而五中而省立法政專門,尋至日本明治大學,負笈遠游,又約更十數裘葛,凡附近名公大老,疏餽問者久之,其間寒暑假期回裡省親,並詣滕府上子下香第,修舅甥禮,道經西洋村,見圩堤鞏固,村莊整潔,父老子弟,俱有仁讓風,心竊異焉。詢之,僉曰,我輩比屋而安,皆允祥先生維持之力也,不圖酒闌燭炧之暇。談及此,渭陽氏亦不間於人言。嗚呼,噫嘻,如若先生者,文聞其名,惜未親炙光儀,以薰其德,悵甚。壬戌歲,畢業返國,會諸友人函招濫竽第八師範於古姑熟。第八師範,即今之十中也,一時報名入校者,實繁有徒,而吾繁有志之士,惟胡君傳琨,與文為最摯,以其母係族之扆楓之令姊也,因詢其世系,則曰,吾家世居西洋邨,先王父上作下霖,前清之邑庠生也。家嚴艱於遇,屢試不售,因入國子學,為地方服務,頗相得。兄弟二人,吾居長,生母已辭世矣,繼母某氏復連舉三弟,家計已僅可取給,言未已,文喟然嘆曰,仁者必有後,允祥先生何其後嗣之多耶。是曏之未曾親灸光儀者,可期睹異日。癸亥春,省垣法政專門江淮中學二校具柬相招。法政專門系文之母校也,江淮校長黃,亦素與文厚,不獲已,東裝西上,不數年而先生竟作古矣。夫死生亦大矣,徒生徒死,俱不足齒數。先生享年幾,謝世已達十餘稔,而其急公好義之熱忱,父老猶樂道之以為後人勸。且長子琨,以十中畢業為地方紳,諸子俱英敏可畏,將來光大門閭,庸可量耶。韓文公雲,朽者其形,不朽者其名,其先生之謂歟。今者,貴族纂修華乘,琨以文有一日之畏,請為之傳。此固孝子仁人之心所不能自已者也。文不敏,爰略舉姑教以誌不朽焉。

======================================================================

田先生傳

先生縣北人也,為人慷慨,重然諾,不苟取,居破屋,力荒田,安之若素。平生尤急公好義,凡鄉裡之公益,莫不虛席以待。人以其農而紳,輒呼之為田先生。先生亦自顧而笑曰,農不善耒耜,士不識之無,不農不士,忽士忽農,予無專業,自無定名,以是名予甚善。於是田先生之名大著。一日中暑病痢,遠近往視者,戶為之穿。聞有以醫藥之言進,先生曰,謹謝君,無庸慮。夫體弱而病生焉,善治者貴養而忌攻。若專乞靈於歧黃,鮮有成效者。故秦皇漢武屢求仙方,終不免於一死也。余嘗出入縉紳之門有年矣,每見其稍染疾病,則舉室惶惶,莫知所措,一日而延數醫,藥劑雜投,往往因之而加重。迨其死也,則曰,命也,非藥也。噫嘻,庸醫殺人,而人不之悟也。余因暑毒而病痢,毒盡而病自已。故慎飲食,時寒暖,持鎮靜,無亂醫,以養其氣而卻其邪。且余鄉同病者伙矣,有不日而死,有二三日而死,而余以衰殘之年,經旬日而猶存者,不醫而已矣,豈有他哉。聞之者雖唯唯,而心多不以為然。無何,果霍然愈。交游為之喜,並服其言。論曰,先生以農流而從事公益,賢已,卧病則遠近往視,病愈則交游色喜,其功德可見已。生長草野,素不知書,而論治病之理,探本求源,似諳生理學者,更奇已,豈果知養生之道者歟。抑深於閱歷者耶。嗟夫,吾息影林泉,嘗與鄉村野老相過從,杯酒談心,多聞所未聞,足補書所不及,田先生殆其一也,又其言可以為庸醫者愧,而為好藥者戒,故傳之。

=====================================================================

王君加入義勇軍序

余友王君,性義而勇,智變多才。自如北平學校肄業,已數年矣。其平時閱報,見我國外交失敗,輒痛哭流淚,悲憤不自勝者。蓋愛國種子,與生俱種者也。今因滬戰,即投筆加入義勇軍,臨行請予言以為贈。余曰,君之行壯矣。割地賠款,其損失已不可計算,今又盤踞滬上,節節進攻,所謂國亡無日,此其時也。然而一線生機,則在義勇軍耳。蓋義勇軍之士官,非義氣填膺,勇往直前,不足以稱之。君殆其人歟,又何言哉。且天下興亡,匹夫有責,國難臨頭,人人當救。環顧我國言之者甚多,而行之者甚少。君以弱冠文人,不顧室家之好,遽效投筆之班超,拋棄父母之親,遂慕長風之宗慤,此又余有志而未逮也。君此行,不僅予一人抱愧已耳。然既承請求,不能無一言以壯行色,爰攜手而言曰,倭奴入寇,舉國發指,國家存亡,在此一戰,荷槍實彈,決勝疆場,毋畏懼,毋退讓,拼著頭顱曏前上。殺盡日奴再算賬,收回失地還大漢。將來功成軍旆返,民眾歡聲遍街巷。言盡於此,書之以贈。

Edited 16 time(s). Last edit at 2008-05-10, 09:36AM by 立委.

| 主题 | 阅读 | 作者 | 上贴 |

|---|---|---|---|

| 1421 | 立委 | 2007-03-08, 03:55AM | |

| 798 | 立委 | 2007-03-20, 12:03AM |

最后一篇文末似乎引用了当时民谣(因与时文风格不一)???

引用:

毋畏惧,毋退让,拼着头颅向前上。杀尽日奴再算账,收回失地还大汉。将来功成军旆返,民众欢声遍街巷。

引用也不给个出处,祖宗不严谨焉。

如果不是引用,而是自编,原来伯祖父还是编歌好手呢。

立委当年手抄注释《李老夫子遗墨》扫描件:

Edited 2 time(s). Last edit at 2007-07-11, 09:39AM by 立委.

http://blog.sciencenet.cn/blog-362400-293427.html

上一篇:《立委点评:听不够的童丽》

密码保护:《朝华午拾:老乡妹妹》

密码保护:人生记忆:风雨几春秋

密码保护:《朝华午拾:永远怀念亲爱的妈妈》

密码保护:《朝华午拾:同桌的她》

《甜甜花絮:China Trip Journal》

xh

隐藏 ||

..................

WRITTEN BY Tanya Lee

Today me and my cousin Da Bao are going to the Great Wall. When we got there, we took a cable car to one part of the Great Wall. My cousin and me walked and walked until the end of the wall. Once we got there, we took a picture to remember the day we climbed the Great Wall.

========================

Tian An Men

***

Today me and my dad are going to Tian An men to fly kites. When we got to Tian An Men, my dad bought me 2 kites, one actually didn't fly and one flied very well. Then a lady convinced us to go to an art museum to look at paintings.

========================

Night View

Night View of Tian An men

My uncle and my family are going to take my uncle's car to see the night view of Tian An Men. It was maginificent. the entire street was filled with all kinds of restaurants and buildings. The best thing to see was Tian An Men. It was full of pretty lights. Me and my cousin wanted to go in Tan An Men, but we couldn't: it was closed.

==========================

Transportation:

We went on an airplane to get to China. We stopped at the airport 3 times, once at Detroit, once at Tokyo, and finally Beijing.

How many miles did you travel:

6,400 miles

Mrs Lennert (Teacher)'s comment:

What a wonderful trip: one you will always remember!

=========================

My Birthday in Beijing

Today is my birthday. My mom, dad, grandpa, and grandma plan to call all my relatives, and take them to a restaurant. We ate fish, chicken, pork, and all kinds of green vegetable.

=========================

Park

Today me, my uncle and Da Bao are going to a park. 1/2 of it was an amusement park and another 1/2 is a flower patch. First we played bumper cars, then we rowed a boat, but we couldn't row it very well. We almost got stranded in the water. After that, we played a game and got a prize.

=========================

Summer Palace

Today me, my dad, my uncle, and Da Bao are going to Summer Palace to see the flowers. We saw bamboo, peach flowers and plum flowers. Later, we went through the longest painting corridor. Then we drove a boat around the Summer palace.

=========================

Wuhan Cherry Blossoms

Today me and my family are going to Wuhan. When we got there, we went to see cherry blossoms. My uncle took lots of beautiful pictures of cherry blossoms.

=========================

Visit Dad's teacher

Today me and my dad are going to visit his teacher. My dad's teacher can speak English and she was my dad's English teacher. She gave me a Chinese calligraphy book to read.

=========================

My dad's trick

Today is April Fool's Day. My Dad sent a text message to his friend. He tried to trick his friend into thinking April First is the only day his friend can get a free trip to Canada. His friend replied, "really?" My Dad replied, "April Fool"!

Banquet

Today me and my family are going to a banquet with my Dad's master degree advisor. He is an old man named Professor Liu.

My favorite restaurant

My favorite restaurant is Guo Lin. We went there 3 times. Each time we ordered different dishes. There are all kinds of dishes like fish, kung pao chicken, Chinese and Indian pizza, and all kinds of soup.

My favorite place

My favorite place is Summer Palace because it has a lot of flowers, fake mountains, willows and boats to ride. There is a long corridor of paintings; every inch of it has a painting.

(during Spring Break, 2005)

Edited 1 time(s). Last edit at 2007-02-10, 11:59PM by 立委.

..................

WRITTEN BY Tanya Lee

My name is Tanya Lee.

I go to North Forest Elementary. I am 7 years, 11 months and 10 days old.

I will soon have a greatest Birthday Party (I can't wait!).

I am now in Grade Two.

I have tons of hobbies.

My favorite hobbies are Swimming, Figure Skating, Ballet, Piano, all kinds of computer games, -- and, of course, telling jokes.

Here is a joke for you.

自我介绍(开场白)

..................

作者:李甜甜

我叫李甜甜。我在北部森林小学就读。我7岁11个月零10天。我生日快到了,将举行一个很大的生日派对(我都等不急了!) 。我现在在二年级。我有很多很多业余爱好。我最喜爱游泳、花样滑冰、芭蕾、钢琴, 各种各样的电脑游戏, -- 哦, 当然, 我还爱讲笑话。给您讲一个笑话吧。

======================

Eat Chocolate Movie?

***

A Joke for You

Last summer, me and my family went to New York City.

We visited American Museum of Natural History.

We were going to see an IMAX movie.

The man selling the tickets asked my dad,

"Are you going to see the 'Chocolate' movie?"

My dad said, "no!"

"Why not?"

"I don't want my teeth to be ruined!"

"O, you are going to WATCH the movie,

you are not going to EAT the movie!"

吃'巧克力'电影?

***

给您讲一个笑话

去年夏天, 我和我家去纽约旅游。我们访问了美国自然历史博物馆。我们打算看IMAX巨屏电影。卖票的叔叔问我爸爸, "您要看名为'巧克力'的电影么?" 我的爸爸说, "不要!" "为什么不看?" "我不想坏我的牙!" "哦, 您是看电影, 您并不是吃电影呀!"

===========================

Surprise Comments

From time to time, Tanya surprises us by some spontaneous comments we never expected a kid to utter.

Recently, she saw a message in my computer screen "feel young" and commented promptly:

"It is good to feel young, but it is better to BE young." I was amazed.

A couple of years ago, we went past a Jewelry Counter when Tanya made a comment: "This cultured pearl looks better than that freshwater pearl."

"My God", the shop assistant could not believe this from a 5-year-old kid.

妙语惊人

时不时, 甜甜会突然冒出一些惊人妙语。最近, 她看到我的计算机屏幕上一行字"感受年轻"。甜甜及时评论道: "感受年轻固然好, 但本身就年轻岂不更好。" 我惊异万分。 两三年前, 我们走过一个珠宝柜台,甜甜作出了如下评论: "这颗养珠比那颗淡水珠好很多。" "我的天", 售货员不能相信此话出自一个5岁孩子之口。

==========================

My Dad (by Tanya in Grade 1)

I love my Dad.

My Dad likes to play with me.

We play Freddy Fish on the computer.

My Dad is the greatest.

My Dad gets me ice cream.

My Dad is fun!

My Family (by Tanya in Grade 1)

My family likes to go shopping.

I love my family.

We have fun playing on the computers.

My family is the best.

我的爸爸(作者:甜甜,一年级)

我爱我的爸爸。我的爸爸喜欢带我玩。我们一块儿在计算机上玩Freddy鱼的游戏。我的爸爸最了不起。我的爸爸给我买冰淇凌。我的爸爸非常有趣!

我家(作者:甜甜,一年级)

我们家喜欢逛商店采购。我爱我家。我们玩计算机,很有乐趣。我家是最棒的。

==========================================

04.02.11, 今天下午一点,甜甜学校举行面向家长的学生项目汇报,项目是在老师指导下制作的画册或书,自行出版。 【像册上网】甜甜去年制作的一年级作品已经扫描上网,记录的是甜甜的学校生活。甜甜出版的第一本画册:《Remember when...》

==========================================

04.02.12, 甜甜学校举行情人节聚会。 【像册上网】甜甜制作的卡片上网:甜甜的情人节卡片;其他卡片

Edited 2 time(s). Last edit at 2007-02-19, 06:18PM by 立委.

..................

BY William & Tanya

The other day, Tanya told me, "you know, Dad, I am the top student in my class." I asked, 'How do you know it?" She said, "we have three advanced clubs: Hard Math, Hard Spelling, and Hard Reading. Only Adam and I were selected to all these three clubs." "So, Adam is also the top student." "Yes, he is the top boy student and I am the top girl student. We are a tie. "

==========================================

April 8, 2004

***

"Essays"

Tanya likes writing. She told me that she was the fastest writer in her class. She likes to use "big words". She told me that she wanted to surprise her teacher by taking diaries everyday in this Sping Recess. And she did it - so far, one full page a day. Yesterday, she felt that "diary"is too small a word for her writing, and began claiming to write her "essays". "I still have an essay to write," she said last night. But she was too sleepy to finish her essay. I am sure she will finish it today

=========================================

"Teach me more math"

"Adam is better than me at division, but I am better than him at square root. Dad, can you teach me more about division? And also cubic and cubic root? Adam does not know cubic root yet."

I wonder how she became top since she did not really get enough time for reading and spelling exercise. Most of time is spent on piano and Chinese, and some on math. But I found she reads and writes fairly well for her age, with an ever increasing vocabulary.

==========================================

04.02.18, 【家庭录像】甜甜参加著名作曲家 David Karp 主办的钢琴表演,获得作曲家青睐。 表演完后,作曲家特地邀请甜甜单独为其夫人再弹一遍。2003秋:甜甜参加钢琴表演(节选)

04.02.17, 【明星动态】在这个家人亲友网页,明星当然是甜甜。

除了给甜甜创造尽可能好的教育和成长环境,我们的原则是任其自由发展。其结果是甜甜非常主动,善于社交,不像我们,见到人多,就躲到角落去。甜甜的生活内容,除了上学(8点上学到下午2点半放学)和参加课外班,满脑袋就是一个“玩”字.首先是电子游戏,Gameboy不离手。另有Playstation 2, computer games, 网络游戏,还包括我的手机和iPod随身听上的游戏,全部玩得烂熟.商场也到处有游戏机,苹果专卖店也提供玩电脑游戏的优越条件。不过,“教育性游戏”,寓教于乐,我们倒是鼓励她玩,见到年龄合适的教育游戏就买,甜甜得益不浅。其次是电视,以前只喜欢动画片和儿童节目,最近一年开始看Nick频道的老少咸宜的喜剧系列,如,Full House, Cosby Show, 和 Three's Company. 甜甜的英文俗语俚语,大多是从这些电视节目学来的(还有就是源于待她如亲孙女的邻居老太太 Grandma Lucy)。课外班目前有“钢琴”(周三晚上),“中文”(周六上午),“芭蕾班”和“Tap and Jazz 舞蹈班”(周五晚上),“游泳”(周六下午),“滑冰”(正在考虑参加周六中午的“中文舞蹈班”)。学校的家庭作业很少,留的算术作业太简单,甜甜通常5分钟搞定,其他如英文词汇、作文作业,甜甜也不费吹灰之力。现在花时间最多的是钢琴(每天2个小时以上练琴)和汉字练习,我们觉得这两项是一辈子受益的事情,非苦练不能长进。好在妈妈盯得很紧,甜甜在钢琴和中文两个班都是优秀生。钢琴去年正式比赛得最高成绩 Superior, 今年的赛事也在积极备战中。中文跳了半级后,几次考试仍是第一。Mary 功不可没。

Edited 3 time(s). Last edit at 2007-02-19, 06:26PM by 立委.

http://blog.sciencenet.cn/blog-362400-293442.html

上一篇:《立委点评:听不够的童丽》

密码保护:《甜甜花絮:【配乐录象:成长的故事】》

密码保护:《甜甜花絮:十一则》

密码保护:《朝华午拾:警察抓小偷的故事》

密码保护:《朝华午拾:亲历英国脱衣舞》

密码保护:《朝华午拾:爱情自白》

密码保护:《朝华午拾:我的考研经历》

密码保护:《朝华午拾:哦,加拿大!》

《李老夫子遗墨》简介

《李老夫子遺墨》簡介

李老夫子(李咸昇,號學香)是我的曾祖父。《李老夫子遺墨》(現代文言,又稱“時文”)收集了其徒子徒孫傳抄的李老夫子遺作,包括詩詞歌賦、喜壽輓聯、序傳雜文等,由他的門生編輯成冊,內部發行於上個世紀三十年代。

家傳孤本掃描上網。除了對我們傢具有獨特意義外,亦具有一定的文史資料價值。掃描版本不甚清晰,我將逐篇陸續輸入校對,以利永久保存和流傳。

附錄還收錄了我的兩位叔爺(伯祖父李應文和叔祖父李應會)的作品。曾祖父非常開明,重視教育,不惜變賣田產送孩子(我的叔爺)去日本留學深造。但我的爺爺(李應期,行二)被曾祖父留下來幫助理家,失去了留學機會。據說,我爺爺當年每年去南京一趟,將家產變賣的銀子匯款到日本,供給兩個兄弟的學業。兩位叔爺上個世紀二十年代初(?)分別獲得明治大學法學士和政學士學位歸國。在那個年代,有這樣教育背景的人才很難得,本可做一番大事業。他們後來的建樹不大(與其教育水平不成比例),影響止於本地,我猜想原因有三:一是年代不濟,中國自上世紀初開始,兵荒馬亂不斷;二是曾祖父淡泊名利,進而要求孩子們繼承父業,在家鄉興辦教育,而不是鼓勵孩子們出去闖天下;三是兩位叔爺身體都不大好,沒有“革命”的本錢:伯祖父久卧病榻,是鄉間生活使他休養生息,逐漸康復;叔祖父更是不幸,英年早逝(見本書附錄“李應會先生榮哀錄”)。但是從他們所著文字,可以看出,他們思想開明,關註時事。除了鄉居閑篇如“李應文-哀死鴿文”外,也不乏豪情熱血之作,如“李應會-抗日會宣言(仿討武曌檄)”,“李應文-王君加入義勇軍序”。

我爺爺在我出生那年死於三分天災、七分人禍的大飢荒。三兄弟中,就數伯祖父李應文比較幸運,1965年在老家壽終正寢(遺像見下)。李家所有晚輩全部到齊,舉行隆重葬禮(李家合影見下)。還記得我們孫兒輩,在棺柩落地後,每人輪流掬一捧黃土。伯祖父生前作為開明紳士和“統戰對象”,受到當地政府的禮遇,曾經當選為縣人大代表(證書見下),幸免於政治運動的波及。仙逝於文革前一年,更是大幸,否則,以他歷史上的複雜經歷,文革中少吃不了苦頭。(一直看顧我們長大的外祖母在文革中,就被揪鬥,每日掛著“地主分子”的牌子,受盡羞辱,給我們幼小心靈也蒙上陰影。)

以上可算是我的“書香門第”背景。只不過,到我父親這一輩,由於國家內憂外患(抗日和內戰),連年戰亂,家道中落,生活日漸艱難。我父親小時候忍飢挨凍的事常有。想當年,李家“崇實學校”在當地可是富有盛名,桃李滿天下。不過,家道衰落倒成為一件好事:共產黨當道後的土改,家庭由此被定為“小土地出租”,而不是“地主”、“富農”這樣的“四類分子”(指的是地主、富農、反革命、壞分子四類,後來又加上57年劃分的“右派”),使得我們後輩少受政治運動的衝擊。

說到家庭成分“小土地出租”,還有一些故事。在我們小時候,家庭成分是一個很重要的政治標簽:“貧下中農”子弟被認為天生革命,“根正苗紅”,高人一等;而“地、富、反、壞、右”子弟受到極端的社會歧視,被剝奪很多機會(招工、上學等),而且日常生活中也常常受欺侮。還記得我們小學時班上有一個女生,家庭出生地主,很可憐的樣子,總是抬不起頭,就這樣,還常常有同學羞辱她。在這樣的環境裡,我們每個人對家庭出身自然很敏感。我家情況不是很妙,母親出身地主(是個可憐的土地主:外祖父做小生意賺了點錢,捨不得吃和穿,一家人勒緊褲腰帶,卯足勁置辦田產,以期小康,換來了一個地主帽子),成了我們的一個死守的秘密。好在子女家庭出身隨父,所以我們每次填表,家庭成分欄都是“小土地出租”。問題出在,很長一段時間,我們搞不清這個比較偏僻拗口的成分的政治含義,心裡不免惴惴。記得在班上,有幾個同學議論我家這個奇怪的出身,其中一個自作聰明地說:“小土地出租,就是小地主”(其實這個理解不算離譜),一下子把我們推到“階級敵人”陣營,讓我們無地自容。我的堂兄揚縝也有同樣的煩惱。有一天,他很高興地宣佈,經過深入研究,學習毛主席著作和有關黨的政策文件,發現“小土地出租”大體相當於“上中農”,屬於革命隊伍的團結對象。而且黨的主席毛澤東也出身於上中農家庭。(實際上嚴格說起來,毛家顯然已經進入“富農”級別,印象中毛在跟斯諾交談時對此“供認不諱”。說他出身上中農好象是後來革命群眾為領袖諱的變通。一個在韶山衝這種窮鄉僻壤的上中農是很難蓋上毛家那間著名的大瓦屋的。我們對這個大瓦屋象天安門一樣熟悉,它成為人們瞻仰紅太陽誕生的聖地。)這些偉大發現使我們大大松了一口氣。

背景資料: 在那個荒唐年代,所有人被階級出身劃分為不同等級。跟所有分類一樣,這些級差是連續的,有模糊地帶,但大體分為“敵、我、友”三類:革命階級(以無產階級、貧農、雇農、下中農為代錶),團結對象(以中農為代錶,民族資本家曾經一度被看作是團結對象),革命對象(即階級敵人,以地主、富農和官僚、買辦資本家為代錶)。而“上中農”和“小土地出租”這樣的成分就屬於敵友之間的模糊地帶:這就是煩擾我們多年的原因所在。

2004年10月12日,記於美國水牛城

補記:現在象《李老夫子遺墨》這樣自成一體的資料已經很少了,它的文史價值是可以肯定的,反映了那個劇烈變遷的時代(從前清到民國)以及南方山城繁昌的一個側面。有些作品也具有一定的文學和娛樂價值。我大學畢業後在繁中教書的時候,從同在繁中的大伯處借來他收藏的一本殘缺不全的《李老夫子遺墨》,工工整整手抄下來,並試圖添加註釋(掃描件選附在有關章節後),可惜註釋工程沒有完成。手抄本後還有四種相關的附錄,附錄一是我父親撰寫的生平回憶《風雨幾春秋》(其中有家史的回顧)。附錄二是我的遠房叔爺李應繁的詩詞選集。李應繁年少時闖蕩江湖,憑著過人才氣,解放前也曾供職上層(曾任顧祝同抗日時期的秘書),有很多傳奇故事。他是我見到的一個少有的樂觀豁達的年邁智者。他儘管年衰背駝,但精神矍鑠,態度謙和,手住拐杖,背負行囊,來去無蹤,很有高僧仙道的風採。他出口成章,無處不詩,令我心折,遂亦從大伯處借來他的詩歌,手抄留存,現掃描上網,以為紀念。附錄三是我堂兄李揚縝撰文介紹的書法家郭俊峰老先生。郭先生早年曾在李家崇實學校讀書,書法啓蒙於我的大叔爺“體罰式”教育(這種教育是私塾和半私塾的常規教育方式)。郭老先生的書法現在早已名揚四海,飲水思源,他還歸功於當年李家學堂的嚴格教育呢。

1965年李家後輩參加伯祖父葬禮留影一(攝於1965年九月十六日)

後排左起:大伯父(實際行二)李名實,父親李名傑

前排左起:大伯母,堂姐李揚英,堂兄李揚縝,我(五歲)和母親

1965年李家後輩參加伯祖父葬禮留影二(攝於1965年九月十六日)

左起:三伯母,堂弟(三伯母小兒),母親和我(五歲)

堂弟和我手裡各拿著從李家大院裡的柿子樹上摘下的柿子(印象中柿子多得吃也吃不完)

1965年李家後輩參加伯祖父葬禮留影三(攝於1965年九月十六日)

後排左起:四伯父李名毅,三伯父李名勤(若非),大伯父(實際行二)李名實(何求)和父親李名傑

中排左起:三伯母,堂弟(三伯母小兒),?,?,?,大伯母和母親

前排左起:?,?,?,堂兄李揚縝,我(五歲)和堂姐李揚英

《李老夫子遺墨》線裝封皮

《李老夫子遗墨》目录

姚学铭: 序一 (4)

编者: 序二 (6)

《夫子遺墨:序類》 (23-40);24-25;26-27;28-29;30-31;32-33;34-35;36-37;38-39;

《夫子遺墨:傳類》(40-46);42-43;44-45;

《夫子遺墨:雜作類》 (46-59);48-49;50-51;52-53;54-55;56-57;

《李家大院》电子版

《朝华午拾》电子版

《甜甜花絮:let me break the code》 (the legend continues ...) 留存

引用:

《甜甜花絮:let me break the code》 (154140)

Posted by: liwei999

Date: May 18, 2008 11:26PM今天下午,领导在 Macy's 采购,我等着无聊就开始玩 iPhone. iPhone 可以随时通过 AT&T wireless 上网,但是如果周围有 wireless routers, 就会提示用户先接 router, 因为这样信道应该宽一些。

提示的网是上锁的,我一般遇到上锁的,就 cancel it, 但甜甜兴趣来了,说:Dad, let me break it.

我笑:you are not a hacker.

甜甜固执得很,非要试试,拿过 iPhone, 胡乱敲了一些字母作为口令,失败,再敲,还是失败。

我对甜甜说:you know how many possibilities are there?

甜甜说:I will try various combinations.

我不屑一顾:you may spend the rest of the year trying it without success, that's how small the probability is...

我话音未落,甜甜大叫:I broke it, I broke it, look, Dad...

我一瞅,还真进去了。甜甜仿佛是杀敌归来的大英雄,得意极了:I can be a hacker too, it is fun.

我问:what did you type the third time?

I typed AAAAA.

Why AAAAA?

That's my lucky letter.

Why did you repeat it five times?

That's my lucky number.

我哑口无言,甜得意忘形。我说,I 'll write it down for old buddies. 回家以后,先陪甜甜操场玩tennis一小时,刚吃罢晚饭,甜甜不忘问道:Dad, have you posted the story to Old Buddies?

So I am posting it now.

--------

立委名言:请祈祷,捐献。

星湖【立委专栏】

[homepage.mac.com]浏览: 前帖•下帖 选项: 回复此帖•引用该帖

《甜甜花絮:let me break the code》 (1150 字节) - liwei999 08-05-18, 11:26PM (154140)

♦ 哈哈哈!有意思。青出于蓝胜于蓝。 (空) - 何人可 08-05-19, 04:27AM (154182)

♦ 请甜甜给找一个lucky number for 乐透mega。。。 (空) - 笑笑 08-05-19, 12:04AM (154150)

◊ 一定中大奖!捐一半到洗脚池。 (空) - shijie 08-05-19, 12:08AM (154151)

♦ yes, i meant it. (22 字节) - 笑笑 08-05-19, 12:13AM (154157)

~~~~~~~~~~~~~~~~~~~~~

This is absolutely unbelievable (163468)

Posted by: liwei999

Date: June 28, 2008 07:54PM

It just happened a couple of minutes ago. One of those days again, when Lingdao was shopping at a location of Talbots and we were bored. Tanya was playing with my iPhone.

"Dad", Tanya said with a big smile and pride, "you won't believe it: I broke the code again". She showed the iphone connected to a locked wireless router in store.

"How did you do that?"

"I am an amazing and lucky girl, ain't I?"

"How many times did you try?"

"Twice. The second time I tried it, I got in. I entered some random letters the first time just to warm up. No surprise, I was rejected."

"What did you type the second time, AAAAA or BBBBB?"

"No. I typed asdfg."

"Why asdfg?"

"I got a hunch. I happened to be good at this game". 甜甜得意极了,我真地不得不服,心想,我也甭为她的将来操心了,这孩子太灵气太运气,还用我瞎操心吗?

后来甜甜说:“You know, Dad, what we got is a QWERT keyboard. People are lazy when they set up a password and they simply want a code to be remembered easily. asdfg is just under qwert. Somehow, they always use my lucky number 5. I guess that's my hunch."

因为得意忘形,破天荒同意我用iPhone给她拍照。当然,照片是胜利造型,双手打出V字。

童言无忌:甜甜论权力交接的三种制度 隐藏留存

童言无忌:甜甜论权力交接的三种制度

隐藏 ||

甜甜的中文学校的教材中谈到国家最高领袖的权力交接的三种主要方式:世袭制,禅让制,民主选举制。留下的家庭作业是你喜欢哪种方式。

结果甜甜写道:

“三个系统之间,我喜欢禅让制因为我觉得聪明的领导会选”

http://blog.sciencenet.cn/blog-362400-376599.html

上一篇:《镜子大全》de 品牌

下一篇:丁丁论坛文艺沙龙首次版聚吃的是鱼头

《成长花絮:小鬼子成为共产主义者》 屏蔽留存

《成长花絮:小鬼子成为共产主义者》

屏蔽 |||

女儿说,我觉得我现在已经是共产主义者了,资本主义太烂,一定要被共产主义所取代(Dad, by now, I think I am already a communist. Capitalism sucks, got to be replaced by communism.)

立委其人:政治右,经济左,文化中立,总体不偏不倚 屏蔽留存

立委其人:政治右,经济左,文化中立,总体不偏不倚

屏蔽 |||

也做了一把测验,比较欣赏这批测验题的创制:

政治立场坐标(左翼<->右翼)0.75,经济立场坐标(左翼<->右翼)-0.05,文化立场坐标(保守<->自由)0.2

不知道在分布里面,我处在什么位置?

从桂铭转的分布看,大家普遍偏右,大概是国人被多年的极左弄怕了。这样看来,我也算是基本随大流了。

1、如果人民没有受过民主教育,他们是不应该拥有普选权的。

同意

2、令人沮丧的是,经济学家越来越成为富人的代言人。

同意

3、人权高于主权。

强烈同意

4、不应指责两个成年人自愿的婚前性行为。

强烈同意

5、中国近年来经济发展的成果很多都被一小群人占有了,大多数人没得到什么好处。

反对

6、发生重大社会安全事件时,即使认为信息公开会导致骚乱的风险,政府仍应该开放信息传播。

同意

7、在重大工程项目的决策中,个人利益应该为社会利益让路。

同意

8、西方的多党制不适合中国国情。

强烈反对

9、不应当谈论或者在公开的文字中记录自己的长辈的缺点。

同意

10、浪费粮食也是个人的自由。

同意

11、在中国照搬西方式的言论自由会导致社会失序。

反对

12、现代中国社会需要儒家思想。

同意

13、为保障社会公平,对富人征税应采用更高的税率。

强烈同意

14、由高校自主考试招生比全国统一考试招生更好。

反对

15、应当对国外同类产品征收高额关税来保护国内民族工业。

同意

16、应该容许宗教人士在非宗教场所公开传教。

同意

17、任何艺术作品,只要有很多人愿意花钱去欣赏,就不能说它毫无艺术价值。

同意

18、在华外国资本应该受到限制,不能任意发展。

同意

19、无论中小学生或大学生,都应参加由国家统一安排的军训。

反对

20、国家财产、集体财产比私有财产更应当保护。

反对

21、试图控制房地产价格的行为是不可行的,会破坏经济发展,给社会带来危害。

反对

22、国家的统一和领土完整是社会的最高利益。

反对

23、改善低收入者生活的首要手段是国家给予财政补贴和扶持。

同意

24、以美国为首的西方国家不可能真正容许中国崛起成为一流强国。

同意

25、个人有权利决定自己要不要孩子,要几个孩子。

同意

26、即使会导致国有资产的减少,国有企业也不应该在市场竞争中享有特殊的保护。

同意

27、应当保证代表全体人民利益的官方新闻机构的存在。

反对

28、高收入者应该公开自己的经济来源。

同意

29、国家领导人的形象可以出现在漫画中。

同意

30、周易八卦是老祖宗智慧的结晶,能够有效的解释很多事情。

反对

31、劫富济贫是行侠仗义。

反对

32、当法律未能充分制止罪恶行为时,通过极端手段对犯罪进行制裁是可以容忍的。

反对

33、中国传统医学具有一些现代主流医学不能比拟的优势。

同意

34、与其让公有制企业亏损破产,不如转卖给资本家。

同意

35、国家没有义务进行对外援助。

反对

36、那些关系到国家安全、以及其他重要国计民生的领域,必须全部由国有企业掌控。

同意

37、如果国家综合实力许可,那么中国有权为了维护自己的利益而采取任何行动。

强烈反对

38、电视机构应当尽量制作格调高雅的节目,而不是只追求高收视率。

同意

39、资本积累的过程总是伴随着对普通劳动人民利益的伤害。

反对

40、条件允许的话应该武力攻台,台独者死不足惜。

反对

41、将传统文化的经典作品作为儿童的主要读物是值得称赞的。

同意

42、即使中国的市场经济出现危机或萧条,也不应当考虑退回计划经济体制。

同意

43、军队应当国家化。

强烈同意

44、政府应当提高粮食收购价格以增加农民收入。

同意

45、应该允许公民在获得外国国籍之后依然保留中国国籍。

强烈同意

46、同性恋对社会没有危害,人们应该接纳同性恋者。

强烈同意

47、能在国际市场上买到的先进科技产品,我们没必要自行研制。

同意

48、哪怕经历了违反程序规定的审讯和取证过程,罪大恶极的人也应被处以死刑。

反对

49、政府不应当干预猪肉价格。

同意

50、国家应当采取措施培养和支持体育健儿在各种国际比赛场合为国争光。

同意

http://www.starlakeporch.net/bbs/read.php?1,20667,20670#msg-20670

http://blog.sciencenet.cn/blog-362400-300750.html

上一篇:《甜甜花絮:Practice Makes Perfect》

下一篇:mirror - 有道是:不在于做什么,而在于别闲着

重发:《关于自由的寓言》 屏蔽留存

重发:《关于自由的寓言》

屏蔽 |||

我赞成大嫂的口号:言论自由是个纲,纲举目张。 (236 bytes)

Posted by: 立委

Date: July 08, 2008 06:09PM民主政体可以缓行,但言论自由应该加紧。

随之而来的是,出版自由,新闻自由。

最后是结社自由和民主选举。哲人乔姆斯基批判美国的大众媒体和政治制度入骨三分,但是他从来都是美国言论自由的最大鼓吹者,是有其道理的。这是现代社会的一个标杆。

我赞成大嫂的口号:言论自由是个纲,纲举目张。 (236 bytes) - 立委 2008-07-08, 06:09PM (30582)

还记得你那个金镣铐的寓言故事吗? 另外一个问题:现在你还会创作类似金镣铐的寓言故事吗?(52 bytes) - shijie 2008-07-08, 06:28PM (30584)

多谢师姐还记得。立委当年就是自由派斗士啊。 (0 bytes) - 立委 2008-07-08, 07:55PM (30586)

好故事请拿出来给大家听。 (0 bytes) - micro 2008-07-08, 08:53PM (30587)那时硕士刚毕业留所,我还是个愤怒青年。原文找不着了, (744 bytes)

Posted by: 立委

Date: July 08, 2008 11:10PM就是当众说了一个寓言。

寓言说的是一个带着金镣铐的阿桂,找主人下套,主人欺骗说,这是为你定制的金表索,很贵重呢。于是阿桂四处炫耀,受到很多讥讽。天长日久,自己也觉得不方便,又去找主人解绑,说:你看人家多自由。主人变脸了:那是假的,那些自由统统是假的。

阿桂说:我连假的还没有呢。你就把假的自由给我吧。

主人于是凶相毕露。

阿桂索性自己砸了这劳什子。革命大功告成。

大体如上。20年了,记得当时写得文采一些,但意思就是这么简单直白。不过,在老论派(不少是国学大师)占统治地位,向来作风保守的社科院语言所大会上这样发言,有点异数。年轻气盛,不管天高地厚,也不计后果,觉得不吐不快。据师姐说,老先生们居然对此印象深刻。

我当年是方励之的信徒,觉得中国非全盘西化没有出路,很有些革命思想。其热情与小白类似。20年了,长进还是不大,只是不赞同闹革命了。革命派走向了反革命,但自由的理念从来没有动摇过。

引用:

你还记得你在语言所大会上所作的“发言”吗?一个是“好了歌”,一个是关于自由的寓言。这两个发言给语言所的老人们留下了深刻的印象。

–shijie

http://www.sciencenet.cn/m/user_content.aspx?id=295229

1 魏玉保

[转载]欧阳锋:巧遇语言学新锐 - 乔姆斯基 屏蔽留存

[转载]欧阳锋:巧遇语言学新锐 - 乔姆斯基

屏蔽 ||| |

该回家了。我走进了电梯,里面有两个亚洲人,一男一女。虽然在我背后,我还是感觉到那男的一直盯着我看。女的轻轻说了一句,大概是中文吧。但依靠语言学家的敏锐,我隐约听到了自己的名字。

回头一看,哈,原来这人我认识。以前一个中国学生给我介绍过他的博客,据说在科学网上是金牌博主。记得他在计算机公司主持什么NLP开发,在我看来也是充满铜臭的东西。但看了几篇他的博文,似乎他对纯学术的东西还有点旧情难忘。这种人现在很少了,所以我还有点记得。他的姓很普通,我不记得了。但记得他的名字叫Wei,中国学生告诉我,是独一无二的意思。

当然,真正让我认出他的,还是他的招牌衣着:圆领衫。到底是语言学家,在衣着上也找到了自己的voice。不容易。

记得他在博文上好几次提到了我,甚至说我是几千年出一个的伟人。哈哈,连我这样的也快被捧晕了。也许中文对人评价的calibration不同?这倒是个值得研究的语言现象。不管怎样,多一个崇拜者总是让人高兴的事。因为我有自知之明,所以我相信他的几百万读者中至少有80%是第一次听到我的名字。所以我的知名度也因他而提高吧。如果他的读者中有10%buy his statement,那我就征服了又一个国度了。

这些念头转过后,我就默默地等着他和我打招呼。谁知电梯到了,他也没有make move。我只好走出了电梯。我故意把脚步放得很慢很慢。相信我,这对于一个老人来说一点也不难。

但是他没有追上来。我只听见照相机响了一声。

今天阳光普照,是美好的一天。

~~~~~~~~~~~~~~~~~~~~~~~~~~~

可以转载到科学网博客么?博人一乐

>>老头在立委心目中就是神圣,大大方方提出合影本来就是一件很普通的请求

【相关】

巧遇语言学上帝乔姆斯基 2015-04-14

http://blog.sciencenet.cn/blog-362400-882495.html

上一篇:巧遇语言学上帝乔姆斯基

下一篇:吐槽系列:验收的“紧箍咒”

《江城记事:革命的困惑》 屏蔽留存

《江城记事:革命的困惑》

屏蔽已有 2479 次阅读 2010-4-22 19:49 |个人分类:江城记事|系统分类:生活其它| 困惑, 江城记事

文革期间,革命思想的灌输是年年有,月月有,天天有。作为中小学生的我成了虔诚的革命信徒。对马列主义毛泽东思想无限忠诚,对此起彼伏的革命运动充满热情,对共产党伟大光荣正确的性质坚信不疑,对党塑造的各类各色英雄人物极度崇拜,对毛主席他老人家更是疯狂热爱和执着迷信。文革十年间,我从几岁的儿童成长上为一个成年人,但那段时间的思想教育给我的世界观、方法论和待人处世的方式都留下那个时代的深深烙印。它严重影响了我们这代人的思维,限制了应具有的宽阔视野。怀旧和偏执、颓废和贪婪,美化过去的苦难生活,与现存制度格格不入,我们很难走出这无形设定的怪圈,思想或多或少被过去那个时代所绑架,思维无法跟上现今的时代步伐。很多人不可避免成为时代落伍者,这是我们这一代人的悲剧。

遥想当年,我特革命,特左倾,特正统,特偏执。在列宁同志倡导的“灌输”式洗脑下, 宗教式的盲目信仰、服从和捍卫一切以革命名义的行动和理论。谁反对毛主席,谁反对共产党,谁反对社会主义革命和建设,全党共讨之,全国共诛之。为世界革命,为人类解放,为真理为理想,愿抛头洒血牺牲生命。狂热遮没了冷静,激情丢弃了思考,我们那一代人充满了神圣使命感,天降大任于己,舍我其谁也。只是我特爱读书,因为读书就免不了会思考,因为思考自然产生困惑,而这困惑那十年让我常夜不能寐,在自责与批判中,在迷惘与无助中熬过那漫长的夜晚。虽然常常念叨:狠斗私字一闪念,灵魂深处闹革命。但这些仍无法让我从困惑中解脱,因为年轻,因为童贞,因为单纯,因为忠诚,反而陷入更深更深的困惑迷思。

当年的困惑之一是叛徒问题。当年我们脑海中叛徒的定型就是蒲志高和王连举。可恶可恨,对革命不忠。一个出卖江姐一个出卖李玉和。由于长期宣传的巨大影响,我们从小就对叛徒深恶痛绝。不坚定,没骨气,缺乏为个革命理想的献身精神,助纣为虐,用同志鲜血铺就自己生活之路,苟且偷生,千夫所指。况且中国传统也是赞美坚贞不屈的,正所谓富贵不能淫,威武不能屈。但是到高中,在年龄的增长中我开始怀疑了:人的意志真的有那么坚强吗?人在酷刑面前真的能挺住吗?当叛徒的人难到就一定会改变他自己的信仰吗?违背自己意志的叛变难到真的不可原谅吗?看到文革中大量德高望重的老干部在牢中不堪压力,大肆交待揭发检举自己的战友和领导的反革命行为,我就更相信:绝大部分叛徒是行刑逼供所致,是人性固有的弱点所致,不是信念信仰的改变。再回头读起我高中喜欢并经常阅读的小说《水浒传》,我的这种念头更强烈了。小说中有一件事给我印象很深,那就是梁山泊好汉白胜经不起拷打,叛变招出生辰冈案主谋,但梁山泊的英雄并没怪罪他,他后来仍是大家庭中一员。我佩服梁山泊英雄的胸襟,而我们现在还不如当年农民起义领袖,这是进步吗?后来又听说,给人打迷晕针也能认人产生幻觉而自觉招供,那算不算叛徒呢?我确信,酷刑一定会让人开口,而且叫他怎么说就会怎么说。人可能不怕死,但人的精神承受肉体伤害能力不是无限的。有了这一想法,我开始有点同情起叛徒了,这让我心中十分害怕,这在当年是真正的大逆不道。

学雷锋运动从我小学到中学贯彻始终,雷锋是我们心目中的大英雄。雷锋爱憎分明,对敌人严冬般残酷,对同志春天般热情;雷锋助人为乐,做好事不留姓名,干工作兢兢业业。做一颗螺丝钉,一切听从党安排,读毛主席书听毛主席话做毛主席的好战士,雷锋就这样走进了我们心中。当年雷锋的故事家喻户晓,雷锋日记被我们当成圣经反复阅读。我们刻意模仿,写雷锋式日记,做好人好事,成为雷锋式战士是我们向往的目标。但当时整个社会风气也不见有多好转,整人,走后门,打砸抢仍很猖獗,不文明现象时常可见。我相信任何朝代的当权者以及它的善良百姓们,都不会反感普通人的做好事行为,这对各方都是有益无害的。所以后来,我开始怀疑雷锋是人为塑造出来的,目的是净化社会环境,巩固统治的基础。我在想如果雷锋他搀扶的大娘是个地主婆,他是残酷还是热情呢?他的日记不记载每天个人的生活情况,却大量抒发革命情怀,那日记不是失去它本来效用吗?做好事不留名,怎么后来都知道了呢,他成了做好事的代名词,这是怎么回事?做一颗螺丝钉,那党强调的人的主观能动性怎么发挥,社会能进步吗?现在看来,雷锋就是党的一个工具,一个培养听话顺民的标杆,可当时我就是怎么也想不通。

中学期间有一门课,叫《社会发展史》,是属于政治课一类。讲社会发展有其自然规律,从原始社会到奴隶社会,再到封建社会、资本主义社会、社会主义社会,最终进入共产主义社会。也就是说制度更替是社会经济发展到一定程度的产物,是不以人的意志为转移,生产力发展到一定程度,旧的制度就不适应了,只能被新制度取代。即所谓的生产力决定生产关系,经济基础决定上层建筑,这也是马克思主义最重要的理论之一。对这门课当时我有三点不能理解:一是为什么社会主义在经济不发达的俄国和尚未经过资本主义的中国产生?虽然御用理论家们用尽口舌,解释这一特例情况发生的原因,但我还是疑惑,这逆规律而动的制度是否是早产儿,有违马克思主义理论和他所阐述的规律呢?规律可改变那还叫规律吗?二是不能理解,既然社会发展是永恒不停的,那共产主义以后的社会是什么呢?一个如此完美的社会制度也要死亡吗?也会被取代吗?人类真会达到一个物质极大丰富思想极大提高按需分配的境地吗?那人与人有什么区别呢,这些想得我头疼。三是我十分明显地感到,欧州的奴隶社会和中国的奴隶社会,在体制上很不一样,各个民族各个国家都有自己独特的发展脉络,尤其是政教合一的国家,它们能统划为那几类形态吗?是否为了证明理论正确性,硬是骡驴马不分呢?我不解,因而对这一门课产生思想上抵制,又不敢与别人辩解,闷在心里,压抑得很。

中小学时,我们一直受这样的教育,那就是说工人阶级是最有觉悟的阶级,具有坚强的斗争性和彻底的革命性,与最先进的生产方式相联系,富于组织性纪律性,没有私人占有的生产资料,是先进生产力的代表。而农民是小生产者,毛主席也说:严重的问题是教育农民。可是后来为了大力宣传知青上山下乡运动,毛主席创造了中国农民的一个类式无产阶级的先进群体----贫下中农,并号召广大学生和知识青年接受贫下中农再教育。这让我很是矛盾,一方面我全身投入下乡学农活动,并积极报名去农村去最艰苦的地方接受思想改造。另一方面我很疑惑,为什么我们不去接受最伟大的工人阶级的再教育呢?农村是苦,但经过近二十年集体化生活的贫下中农还是真正意义上的贫下中农吗,和其他家庭出生的农民有何区别?如果说苦难,奴隶最让人辛酸,是不是更应接受奴隶阶级的再教育,这不是倒退吗?弄不明白,理更乱。上山下乡运动让多少家庭受尽苦难,虽然不少城市青少年因此感受到当年中国最底层最本质的生活,但理论上讲这是很荒谬的,也是毛主席时代最大的失政。虽然现今明白这是毛主席为缓解城市青年失业压力的美丽说词,但这理论上的矛盾困惑了我近十年之久。

“有成份论不唯成分论,重在个人表现”,这是当年党的一个政策。但有成分论怎么可能不唯成份呢?有点此地无银三百两的感觉。而文革十年也确实如此,家庭成份成为个人上学、农村上调、提干、参军甚至恋爱婚姻的一条重要参考值。在讲成份最严重的文革前期,我有一位朋友W某和一个邻居G某,都是才子,绝顶聪明,但因成份不好(一个是黄浦军校子弟,一个是伪军医官子弟)小学毕业竟不让升初中念书,毁了他们一生。另一邻居P某,一个演大春的英俊男生,因成份问题,被深爱他的女友的父母(当地主要领导)活活拆散。这种以成份论英雄的血统论在当时社会占主导地位,是主流社会形态。年轻的我时终弄不明白的是,当年党的领袖大多家庭出身不好,为什么他们要推行成分论?在旧社会,他们都能起来革命,为什么解放后,这些反动阶级子弟反而被打入另类,不让他们革命呢?难到反动阶级能培养他们子弟作为革命者,而无产阶级掌权后,反而无法培养这群出身反动阶级的子弟吗?当年的中国社会,尤其是中底层,排斥反动阶级子弟成为一种时尚,真正实现了法官的儿子是法官,贼的儿子只能是贼的这一奇特逻辑。后来我还知道,当年划分成份,在农村以解放前三年为基准,有土地且雇佣农民者为地主,即使大地主如果三年前破产了,他也可以划为贫农。而一直贫穷苦干,想发家致富光宗耀祖存血汗钱在三年前购置土地的勤劳农民,大都被划为地主富农,我外公外婆就是如此。解放后十几年了,失去土地也远超过三年,已经是无产的公社社员了,但他们却仍是地主富农,其子女受到社会极不公正的对待,这不是在制造敌人吗?这个推理逻辑也困扰我好多年,无法释疑。

历史反革命,是文革和文革前的新中国特有的一个名词。特指中国的某一群人,他们在解放前当过敌军连长以上干部,地方上保长村长以上干部的人,这些人均可纳入历史反革命范畴。属于四类分子,是受打击的对象。至于解放前如果是三青团员、国民党员以及在敌军当兵、在反动机关工作的人甚至包括被敌人俘虏的我军官兵,虽不算历史反革命,但归属于历史上有疑点的问题人物,不论其人品如何,都是被控制被监视被批斗被羞辱的对象,重用不可能,有时连基本生活权力都被剥夺。不过当时我似乎对这种无情清算失败者的行为反感并不大,不理解的也只是一些形式上的问题,对本质问题当时尚未深入思考。当时主要考虑的是那些在敌伪工厂工作的工人,为什么还是工人阶级,还是最先进分子?他们为敌人生产枪弹,生产被衣,直接间接帮助敌人,为何不是历史反革命?为何不受追究?同样是为了生存,当伪警察伪职员,就大逆不道了呢,就要遭到历史清算,这不是标准不一致吗?只要阶级好,帮助敌人也可忽略,阶级不好,为了生存也不可原谅。对标准的因人而异而产生疑问,对于我后来对人、爱、仁、人性和人文的思考有着启蒙的意义。

文革中后期,有两个英雄人物很特出,一个叫黄帅,一个叫张铁生,都是我初中期间推出的所谓敢于反潮流的革命闯将。一个反师道尊严的小学生,一个是交白卷的下放知青,都发生在教育战线上。至此中国教育界迅速掀起了“批判修正主义教育路线回潮”的活动,把当年好不容易恢复的近两年的学习氛围彻底摧毁了。仅此这点就让我特别不满,因为回潮时期我在班级成绩名列前茅,常被表扬,上光荣榜,很是骄傲,自己的成就感大大地满足了。而他们让我这些光环随之消失得无影无踪。其实当年我特别崇拜共产党塑造的英雄,不论是董存端、黄继光,还是雷锋、王杰、欧阳海,都是我心目中大英雄。而现在这两位英雄,我毫无敬仰之意,黄帅是个小孩,未成年人,能懂什么?我一个初中生对妹妹级的黄帅崇拜不起来。而对张铁生我不但不太喜欢,甚至有点厌恶。七五年邓小平在台上时还写过反张铁生的大字报,以泄心头不满。当年我己经可以用路线斗争的观点分析问题了,认为这个典型是党内一小撮坏人乱国乱党的工具而己,这样分析心理也平衡不少。虽不敢怀疑徽宗,但可以咒骂秦桧,中国传统文化又有了用武之地了,困惑缓解不少。

谈情说爱在当时是被批判为小资产阶级不健康情调的,当年的小说电影戏剧把它视为禁区,自然我也深受其影响,常常义愤填膺地批判这一资产阶级思潮。不过外在行动是一回事,内心渴望是另一回事。批判归批判,憧憬仍会憧憬,只是内心十分矛盾十分苦恼。当年虽然封闭,虽然禁欲,苦行僧的教育仍无法抑制人性的本能,冲动仍冲击这个封闭社会甚至学校。初三时,我们班己有六对同学半公开谈恋爱,人数不可谓不多。虽然谈恋爱的男方都是调皮捣蛋、不爱学习、喜欢打架、奇装异服、抽烟喝酒的所谓坏学生,但女方却都是漂亮活泼、学习认真、能歌善舞、活动积极、可爱善良的优质女孩。这让我们这些进步、积极、上进的先进男生很是愤怒,愤怒中含有嫉妒,不满中隐着羡慕。我班班委会所有女学生干部都在谈恋爱,而我们这些男学生干部去不敢面对。心中十分不平,更不服那些胜利者的男生。只能以恶毒的攻击猛烈的批判来掩失那一颗失落的心。其实当时我很渴望与异性交往,但正统的教育使我不敢。内心渴望爱情,心想异性,但却拚命掩饰,强迫自已非礼勿视,去做一个所谓纯粹的人,高尚的人,脱离了低级趣味的人。这方面我活得十分疲累,这种扭曲了人的本性的矛盾和困惑害人害己。

忆苦思甜是当年推行的一种政治思想教育方法之一,刚开始行之有效,但物极必反,后来效果越来越差。听忆苦报告,吃忆苦饭成了一个形式一种负担。当年忆苦饭之难吃,不如猪狗食。这是自己跟自己过意不去,自我摧残。这种自残式的教育方法流行了一年多,害苦了许多虔诚的革命青年,我也不例外。虽然我当时很革命,但就是咽不下那个忆苦饭,即使反复自我批评,也不能让我大口大口吞下这玩意儿。苦不苦想想红军二万五,累不累想想革命老前辈,但榜样的力量不是无穷的,我仍是厌恶那红军都吃不到的饭,这让我心里产生严重的负担,分裂的人格让我苦恼。至于贫下中农忆苦报告,常常忆苦忆走了形,不是忆解放前地主欺压农民的苦难,而是回忆起解放后所谓三年自然灾害的苦难生活,让主持人十分尴尬,让我们很难接受。但贫农老大爷老大娘们十分坚持,不停说他们一生中最苦的就是在六0年至六二年,还常与主持人对扛上了,很坚定,弄得主持人下不了台。我就多次见过这样的场面,安徽省那三年是重灾区,饿死人最多,自然就会出现这样现象。虽然当时我心理能平衡,以为是严重自然灾害所致,但仍留有阴影,对党与政府的领导责任,对人定胜天的思想都或多或少存有疑问,也使我逐逐学会了独立思考,当然也曾带给我内心无尽的烦恼。

忠于党忠于毛主席,是当年一项基本政治素质,是不容质疑的,我是一个最忠的革命青年。 我们热爱党热爱毛主席,天经地义,顺理成章。至于万岁、万寿无疆是否与唯物主义理论相冲突,一点也没去考虑。我们喊着共产党万岁,祝毛主席万寿无疆,那是发自内心的,十分虔诚。即使文革后期,我对许多政策产生怀疑,但对共产党,对毛主席仍是十分忠诚。毛主席仍是我心中的神,神圣不可侵犯。当然当时我也有一个小困惑,那就是,全中国人民热爱党热爱毛主席是自觉自愿的,是真心的,起码我是这么认为的。但即使这样,一个人一个团体一个政党总不能要求别人热爱自己赞美自己吧,那成什么呢?当年党的文件毛主席讲话都要求人民热爱他们,不热爱就是反革命,这不是对觉悟了的无产阶级战士不信任吗?这不是不相信用马列主义毛泽东思想武装起来的中国人民吗?这样行为不是给我们的敌人提供话题,让他们有打击我们的口舌吗?想想怎么有这么蠢的幕僚,制定出这些傻政策,害党害毛主席,只是我实在不知道该揭发谁,只有闷在肚里,让它发酵残害自己了。

今天看来,这些困惑都不是问题,可是在当年,却困扰我整个中小学学生生活,给我留不可磨灭的印象。我不停的思索,不停的否定。苦读马列原著和毛泽东的书,以寻找答案,解开我长久的心结。可是书读的越多,心中困惑越重,越是难以解脱。这种痛苦今天的新生代难以理解的。那是一个革命青年者对现实对信仰对制度的一种朦胧的怀疑,是心灵深处的一场战争,是否定自我否定过去,是不可承受之重。

每个年代的青年,都有自己独有的困惑,当年的我们应可归属于革命的困惑了。

革命的困惑摧残了一代革命青年人。

转载本文请联系原作者获取授权,同时请注明本文来自李维科学网博客。

链接地址:http://blog.sciencenet.cn/blog-362400-315030.html

上一篇:《甜甜花絮:Practice Makes Perfect》

下一篇:《立委早期文字: 革命大批判的化石标本》

当前推荐数:2 推荐人: 曹聪 侯成亚

推荐到博客首页

发表评论评论 (2 个评论)

删除 |赞[2]侯成亚 2010-4-23 15:51纠正“一思想”应为“有思想”。删除 |赞[1]侯成亚 2010-4-22 22:36一思想。有些亦有同感。但切忌形而上学、绝对化。一切皆不可全盘肯定,也不可全盘否定。否则,祸患无穷。

密码保护:我的幸福生活

《江城记事:偷读小说》 屏蔽留存

《江城记事:偷读小说》

屏蔽已有 5377 次阅读 2010-4-23 09:57 |个人分类:江城记事|系统分类:图片百科| 回忆, 文革, 禁书, 偷读小说

从小学开始,图书馆、书店就是我常去的地方。尤其喜欢去同学和父母朋友家搜罗旧书。当年图书馆和书店书极少。

小学前三年看小说不多,基本是读毛主席著作和鲁迅的书为主,毛选四卷我通读几遍,鲁迅的《彷徨》、《呐喊》和《故事新编》这三本短篇小说集成了我少儿读物,甚至他的杂文选和《中国小说史略》这样学术书,也让我糊涂看了许久。唯一的两本少儿读书《闪闪的红星》和《向阳院的故事》,是小学毕业时才看到的。另一本所谓少儿小说,名叫《红雨》,那是一本描过有高超技术的少年赤脚医生故事的政治图解小说,到高中才看到。

给我印象最深是,六六年初,文革刚开始,我的老师每天早晨在教室给我们读《欧阳海之歌》,那时我念小学一年级,我如痴如醉地听着老师朗读,每天都盼着早读课快到。老师那富有磁性的语言,生动有趣的表情和还算吸引人的故事,让我和全班小朋友对欧阳海这个英雄人物崇拜至极。没过多久,《欧阳海之歌》被批成大毒草,红极一时的作者也被批判。

早读变成天天读,内容就是毛选及语录、文件和报纸。

读第一部大部头小说是《艳阳天》,它是文革仅存的一个作家,名叫浩然的一部农村题材小说。细节很有生活气息,但内容很是概念化,政治理念的解读。说得是合作社里的故事。不外是贫下中农最革命,富裕中农太私心,地主富农很反动。此后农村题材小说全都按这个模子套。我大约在小学六年级读的,是厚厚三大本一百多万字小说。小说里描写的富裕中农弯弯绕印象最深,其次是主人公肖和团支书焦的革命恋爱,也让我惊奇。因为文革时,爱情是禁忌语,是小资产阶级情调的反唤,是革命者应当鄙视的。《艳阳天》却是文革正式出版的唯一有爱情描述的文艺作品,虽然是革命恋爱,但与当时氛围还是有所冲突,显得十分的难得可贵。估计能出版是与作者被塑为文革中唯一现存的无产阶级作家有关,且作品第一部也是文革前就出版发行了,仅是文革中再版时未作改动。作者本人在文革中所著的农村题材大部头作品《金光大道》和应景小说《西沙儿女》就再也见不到这些爱情情节了。

文革初、中期,中国几乎没有出版一部新小说,文革前包括解放前的小说及其他文艺作品也几乎全被打成大毒草,归属于“封资修”一类而被禁止和销毁。全国没有文艺期刊和其他人文类杂志,仅剩《红旗》一本党刊和八个样板戏。到了文革中后期才开始出现少量革命文艺作品,有了几十部长篇小说。这些小说大部是写农村题材的,政治说教和政治图解十分突出,但我饥不择食全都拜读过。概念化登峰造极的作品是由上海出版的,所谓写作组集体创作的一部名叫《虹南作战史》的小说。这是一部描述中国农村合化作化运动题材的长篇小说,是毛主席合作化运动理论和实践的笨拙艺术表现,充满说教和议论。固定的僵化模式,图谱式的各色人物,虚假的阶级斗争,拔高的英雄形象,完美的理想主义让全书真正成为“假大空”的标本。浩然文革中的长篇巨作《金光大道》,主人公干脆名字就叫高大泉,意指形象是“高大全”。这部小说也是写合作化运动的,仍然以先进阶级,落后阶级和反动阶级的斗争为主轴,小说中一般会有一个典型有觉悟的贫下中农老大娘或老大爷,梦想发家致富的富裕中农和企图复辟剥削人民的地主富农。主人公一定是党的书记,符合“三突出”的这一不可动摇的最高艺术原则,行政主任一般是反动阶级在党内代理人,向往资产阶级生活方式,总想走资本主义道路。《金光大道》是这类小说中艺术最高的。其次是《春潮急》,像《牛田洋》、《万年青》、《江畔朝阳》、《剑河浪》、《铁旋风》等农村题材的作品,现在已不忍目睹了。

当时比较喜欢的作品,长篇小说有《海岛女民兵》、《沸腾的群山》、《昨天的战争》、《大刀记》、《前夕》。尤其是《前夕》,它是最令我难忘的一部阴谋文学作品。它描述的是某一中学文革前夕高三毕业班师生生活,猛烈抨击所谓资产阶级教育路线,塑造一个敢于反潮流的无产阶级教师方壮涛的英雄形象。内容很政治,情节很曲折,文笔很激扬,它是《峥嵘岁月》第一部,因文革结束而使后面几部夭折。这部小说我通读应十遍以上,文笔流畅,故事引人入胜,印象极深。另外文革时知青农村小说有《征途》和张杭杭的《分界线》,叶辛的《岩鹰》等。题外话,文革中诗歌,我很喜欢北大中文系工农兵学员集体创作的《理想之歌》和张永枚的《西沙之战》。两部长诗都是遵命文学,且《理想之歌》美化苦难,丧失自我,并成为政治斗争的工具。但其激情昂扬的气势仍受当时的年轻人着迷。左倾短篇小说比较喜欢《朝霞》杂志上的一篇名叫《朝霞》的小说。由它改编的广播小说我百听不厌。

文革期间小说不多,我几平把几个图书馆中所有小说都看完了,甚至一些难懂的理论书籍也囫囵吞枣,半懂不懂全看了。如马克思《共产党宣言》、列宁《怎么办》、《联共党史》、列宁《进一步退二步》、斯大林《社会主义经济问题》、列宁《左派幼稚病》、恩格斯《哥达纲领批判》、《中国哲学史》、儒法斗争史。俄国的普列汉诺夫的书也读过。外国小说,图书馆公开出借的不多,前期有鲁迅译的法捷耶夫的《毁灭》、高尔基的《母亲》及法国的《红与黑》等可数的几部。中国古典小说也只有四大名著,经毛泽东批准而在全国印发和借阅,《红楼梦》、《水浒》、《三国演义》、《西游记》成为我少年保存和阅读最久影响最深的古典白话小说。图书馆和新华书店的书籍已完全满足不了我的求知欲,我平均每两天看完一部三十万字小说,每天阅读至凌晨二点以后,中学几年几乎从未间断过。以至后来造成神劲衰弱,失眠困扰我很久时间。

无米下锅,没有书读怎么办?正规渠道的书,不论质量好坏全看了。

书已读完,再也没有可补充的了。虽然国家管的严,虽然阶级斗争这根弦很紧,虽然破四旧收过焚过大量禁书,虽然当时除革命领袖著作外几乎都是禁书,但散落在民间各类禁书仍比比皆是。只要用心,只要努力,面包会有的,书也会有的。关键是要突破自己心理障碍,面对毒草读物,要能说服自己,要时刻认为自己是带着批判眼光去看,以求心理平衡。为了一些反动小说,可以说是花尽心事,使尽手段,一睹为快。记得我家附近有一个以看厕所和卖血为生的一家,有一本张恨水的《啼笑因缘》,为了能看到这本书,我与他儿子,一个低我一届同学套近乎,天天泡在他那狭小、灰暗、低矮的棚户,磨破了嘴皮,用了半月时间,终于借来一阅。虽然那本小说已十分破旧,无头无尾,但我仍欣喜若狂。这是我初中以前看到的最黄最毒最反动的小说,也是我最喜爱读的小说之一。那传奇故事,那樊公子、何小姐和卖唱丫头的三角恋,那有情有义的侠士侠女,都给我带来惊喜,这是当时革命作品不可能有的情节。

至此,偷读被禁小说和其他文艺作品及人文著作,成为我中小学生活中最主要内容,只要有机会,我就想方设法去借,去偷读。但决不在校内读,一般在家中,在晚上偷看。当年我们没有家庭作业,没有升学压力,没有学习负担,我有大把时间去寻觅偷读所谓毒草作品。乐此不疲,像吸了鸦片,一发不可收拾。

刚开始偷读作品,是文革前的革命战争小说,这类小说虽然被批判,但民间存量很大,比较好弄到。如《烈火金刚》、《铁道游击队》、《平原枪声》、《新儿女英雄传》、《吕梁英雄传》、《暴风骤雨》、《苦菜花》、《迎春花》、《林海雪原》、《红岩》、《敌后武工队》、《红日》、《保卫延安》、《野火春风斗古城》、《晋阳秋》,书绝大部分残缺不全,但战争题材总受少年人喜爱。像《林海雪原》,充满传奇战争故事,奇袭奶头山,智取威虎山,奔击大雪原,这些故事倾倒不少新中国青少年。少剑波英俊智慧满足不少少年的英雄情结,第九章白茹的心,又萌发少年朦胧的情感,使我至今不能忘怀。近四十年后,第九章仍清晰可见。战争时代小说我最喜欢三本书,一是《三家巷》、一是《风云初记》、一是《红旗谱》。它们是完全不同风格的小说,特色非常鲜明。《三家巷》是岭南特色,广州生活,描述一个家族变迁。英俊的革命主人翁,大量美丽的表姐表妹,给人充满幻想的情感纠葛,以及少见的艺术表现力都让当时的我爱不释手,百读不厌。《风云初记》是荷花淀派始祖孙梨的作品,用诗一样语言描述那一段战争生活,浪漫气息浓厚,着力描写、赞扬故乡的风光美和人情美,是一部风格独具的、当时仅见的另类战争小说。而《红旗谱》是典型的北方风格,粗犷、豪爽,结构宏大,气势磅礴。是一部反映北方农民革命运动的作品,书中主角朱老忠是一个闪烁着夺目光彩难以忘怀的形象。

第一次寻找《青春之歌》这部小说,费了很大劲。这是一部文革中大受批判的反动小说,被认为是典型的小资产阶级情调的作品,以知识分子为主角,以学生运动为主线,以革命加爱情为佐料,是一部歪曲中国革命和工农兵主导作用的修正主义大毒草。当时我父亲一朋友参与收缴反动小说活动,在堆积如山的房间里,其中就有《青春之歌》,而且是第一版的,虽然没有表皮,但还是被我发现。因尚未造册,我很想把它偷偷拿走,但未能得逞。对这部小说,我己如雷贯耳,很想一阅。那位高叔叔,一位青年造反派头头就是不同意,害怕出问题。我软磨硬磨,毫无效果。最后只得请出我父亲,在父亲出面担保下,借出一天,才得以如愿以偿,看到了全书原文。那天我废寝忘食,通宵达旦,一口气读完,当看完最后一页时,天空已露鱼肚白了。太吸引人了,太精彩了,不论是情节、文笔、故事和格调都让我着迷,写得很成功。虽然后来我知道落后人物余永泽原型张中行是北大的国学大师,感到有点苦味,但当时对这部小说仰慕不已。小说描写以林道静为主要人物的一批进步青年在那个时代,那个背景下追求革命的过程。当看完了这部作品之后,我真的不知道毒在何处?虽然批判文章说林道静未得到彻底的改造,说书中充满了小资产阶级情调,是站在小资产阶级的立场。说作者把自己的作品当作小资产阶级的自我表现来进行创作,而且更重要是作品没有很好地描写工农群众,没有描写知识分子如何接受工农再教育,改造世界观和如何走与工农相结合的成长道路。书中所描写的知识分子,特别是林道静自始至终散发着小资产阶级不健康的情调等等。但我体会不到,我深深地被那个时代爱国学生对祖国的热爱、真诚以及信念的坚贞所感动。文字优美,感情深挚,激奋人心,活脱生动,性格鲜明,虽然现在看来有些形象都或多或少地存在着类型化的痕迹和概念化的趋向,但在当时文学作品中是最少说教的小说。我喜欢,终于找到一部让我折服的作品,我真不愿将书返还。当时的背景,不还是不可能的,但我发誓一定要收藏一本《青春之歌》,以便闲时反复阅读。大约两年后,我终于在别处找到一本第二版的破旧《青春之歌》,如获至宝,收藏家中。不停阅读学习多年。《青春之歌》是我中学时代唯一熟读不知多少遍的革命小说,能与它相比的,也只有《水浒传》了。

偷读的解放后的小说,有不少是农村题材的。如《山乡巨变》、《创业史》、《李双双小传》、《香飘四季》、《铁木前传》等,最喜欢孙梨的中篇小说《铁木前传》,这是中国农村小说很另类作品,完全没有过去常见的模式结构,书中人物具有内涵的多义性和人物的复杂性,让人耳目一新。陈残云《香飘四季》也有特色,该书清纯秀丽,刚柔相济、个性鲜明、风格清朗自然,乡土气息浓郁,是岭南文学的杰出代表。

到高中时,我已开始偷读解放前就出版的小说,这部分作品民间存量不多,即使解放后再版过的进步作家作品也很难寻觅。当时我收集到《围城》、《边城》、《子夜》、《虹》、《家》、《春》、《秋》、《骆驼祥子》、《倪焕之》、《灭亡》、《南行记》、《虾球传》和曹禺的话剧等作品。其中茅盾的《虹》、《子夜》和钱钟书的《围城》在当时给我印象最深。我没想到三十年代大革命时期,妇女就那么开放,《虹》的描述让我完全无法想像。当我看到《围城》开头,更是惊讶。在轮船上,萍水相逢的小姐就主动投怀送抱,在我这个在文革中受禁欲主义教育的青年学生来看,简直不可思议。总认为那个时代是十分落后、封建和闭塞,妇女没地位受压迫。可书中,那个时代知识女性那么独立、自主和女权,性观念也十分大胆,让我目瞪口呆。《子夜》用词华丽、结构严谨、线索繁多、人物复杂、情景交融,让我特别欣赏。尤其是用词的细腻、生动,让人能如闻其声,如见其人,如临其境,对其语言功力我佩服得五体投地。

文革时期还偷看了《李自成》第一部、《上海的早晨》、《红旗飘飘》、《大波》以及古代小说《说唐》、《说岳全传》、《封神演义》、《儿女英雄传》、《聊斋志异》、《儒林外史》、《二十年目睹怪现状》、《官场现形记》、《今古传奇》等,但《金瓶梅》当时无法寻到,也没看过。大量中国古代色情小说当时都全没看过,也没想到礼教最严最封建的明清时代,会有那么多色情小说。

那个年代,还有一个特有现像,那就是手抄本小说大规模在中国地下流行。如《梅花党案》、《一双绣花鞋》、《绿色的尸体》、《三条命案》、《叶飞三下南京》、《公开的情书》、《第二次握手》、《少女之心》(又名曼娜回忆录)等,手抄本小说从内容看,大概有爱情类、侦破反特类、恐怖类等类型。也有极个别的是描写色情的,其中侦破反特类最多。这类小说我大多看过,艺术质量都不高,是那个文化荒芜时代的产物。质量最佳的是《第二次握手》,一部革命、爱情加科研的理想化小说。遗憾的是当时我没看过色情小说《少女之心》,班上有很多同学看过,包括一些女同学。我心里也有渴望,也想看,但最终因听说过于色情,而不敢看。直到改革开放后九十年代,我才把它看了一遍。确实《少女之心》,无论是从情节上,还是在语言上,都算是情色小说,但并不是上乘的色情作品。但它占尽了天时地利,风靡一时。那个时代是一个无性的时代,是一个把性当作魔鬼和邪恶的时代,是一个稍稍有一点性过错就可能惨痛地付出生命代价的时代,《少女之心》手抄本的影响与意义,现在看来应该是相当正面的,当时却是批判最厉害的一本手抄本反动黄色小说。它的意义并不在于它的色情文字本身,而在于它是一部换起无数被压抑的中国人的人性的色情孤作,是对所谓存天理灭人欲的虚伪伦理的控诉,成为影响那一代中国青年人的最特殊的作品。在那种所谓无耻下流色欲的故事表象下,隐藏着一种对美好爱情的执着追求。可惜当时我没能偷读这部小说,甚感遗憾。

偷读小说己成历史,今天的人们可能无法理解那个时代和行为。偷读小说是我个人一笔十分宝贵的财富。

http://www.starlakeporch.net/bbs/read.php?1,54305,54305#msg-54305

转载本文请联系原作者获取授权,同时请注明本文来自李维科学网博客。

链接地址:http://blog.sciencenet.cn/blog-362400-315145.html

上一篇:《甜甜花絮:Practice Makes Perfect》

下一篇:《立委早期文字: 革命大批判的化石标本》

当前推荐数:3 推荐人: 曹聪 iwesun 侯振宇

推荐到博客首页

发表评论评论 (6 个评论)

删除 |赞[6]曹聪 2010-4-23 22:47这些书都带到了国外?删除 |赞[5]iwesun 2010-4-23 17:07江城,是武汉么?删除 |赞[4]iwesun 2010-4-23 15:29你怎么保存的?这点就很牛!删除 |赞[3]侯振宇 2010-4-23 13:29批判最大的作品似乎应该是《战火中的青春》!

因为它较客观地描写了黑1号。删除 |赞[2]侯振宇 2010-4-23 13:26《前驱》读过吗?删除 |赞[1]侯振宇 2010-4-23 13:22高尔基的《童年》、《母亲》、《我的大学》3本连环画很著名。

小城记忆 屏蔽留存

小城记忆

屏蔽已有 2020 次阅读 2010-11-14 18:59 |个人分类:江城记事|系统分类:生活其它| 回忆, 家乡, 江南, 乡愁, 小城

小城记忆

从出生到二十岁之前,我都生活在一个江南小城。

它地处黄山山脉边缘和长江中下游平原的交汇处,城的西边是起伏的丘陵,城的东边是一望无际的水乡平原。小城不大,当时城内人口约三万多,仅有一条十字型的街贯穿东西南北,分别叫东门、西门、北门、南门和十字街口,其中东西长约二公里许,南北长不到二公里,尤其是南门的街道很短,大约五百多米。城东和城西各有一条小河,城东那条河叫漳河,我们习惯叫它为东门大河,是长江的支流,至芜湖市汇入长江。城西的河叫后街河,是漳河的支流,该河在城北汇入漳河。不论城东的河,还是城西的河,当时都十分清彻。每年五一到十一这段时间,我几乎天天都会去河中游泳,有时泡在河里,一泡就是大半天,它承载了我青春的悲欢喜乐。

西门后街河的河岸有一种黑色的粘土,是我儿时的最爱。我常去河旁挖这黑土,用来做手枪等玩具。这黑土很粘,能塑成各种形状,凉干后坚如石块,用铅笔打光,黝光发亮,做手枪尤为逼真。当年此土分布不多,也不成片,不知今天的后街河岸还有此土不?东门的漳河盛产河沙,小城的建筑用沙,当年全靠此河。包括我上中小学,它的运动场的跳高跳远的沙坑的沙,都来自东门大河,而且是我们学生从东门大河一担一担,行走三华里多挑到学校的,几乎每年运动会前都会去东门大河挑一次。

小城很破旧,以一层平房为主,偶尔有几处二层楼房,街道门面全是板房,木板揿在石凹中,可拆下。城内最高的楼是县委大楼,有三层,但只是局部三层,呈凸型状。当年我们这些小孩特喜欢爬这三楼,常趁守门人不注意时,混到三楼。在三楼平台上,我们沐浴着细风,俯视全城,心潮澎湃,油然而生一种立足平台、放眼全国、胸怀世界的豪迈情怀。看着眼前的小城,远处的小山,似乎体会到毛泽东当年在长沙橘子洲头的豪情。“恰同学少年,风华正茂”,解救全世界三分之二仍处在水深火热之中的穷苦大众的担子,历史地落到我们的肩上,我们深感责任重大。

在我生活在小城的二十年中,它几于乎没有什么变化,东门还是东门,西门还是西门,一辆破旧的苏联轿车是县城唯一的豪华,那是县委书记的专车。我同学父亲是这车的司机,让我们对她好生羡慕。可数的重大变化是,十几年尘土飞扬的土石街路终于在文革末期简单柏油化。到了高中,终于有自来水了。城中医院在我小学时拆迁,准备建三层的门诊及办公大楼。不过从我小学四年级建起,到我文革后快进大学的时候,这栋非框架的三层大楼才告落成,也算创造了一项奇迹。

小城以商业为主,没什么工业,整个城镇在上世记七十年代中期才建有四个小工厂,即小化肥厂,小钢铁厂,农机厂和手扶拖拉机厂。但我第一次看到那钢铁厂高耸的烟囱时,我为我们祖国工业突飞猛进的成果由衷地感到骄傲。敌人一天天烂下去,我们一天天好起来。生活在毛泽东时代的我们,生活在社会主义中国,是莫大的幸福。

小城很安静,也很纯朴,文革的大批判声音也未真正改变它朴实的气质。多数人穿着打着补丁的衣服,鱼肉是难得的奢侈品,能填饱肚子就是一种幸福。小城的人们每天或劳作或聊天或晒太阳,似乎很满足于这贫困单调的生活。我家条件算好的,有一台家电,那是五灯的电子管收音机,当年是我们那一排房子十来家中唯一的一台(后期这种收音机就多了)。大家都很关心国家大事,议论着世界,议论着他人,唯独对自己生活现状没有满腹牢骚。清贫而又满足,是小城大多数人的现状。

小城只有一个公园,叫中山公园。在小城民众的心目中,它很神圣。其实那个公园算不上真正的公园,只是个小小运动场,小城的大型集会都在此进行。小城没有什么古迹,也没有什么风景,老的夫子庙毁了,城中的一个古塔也推倒了。文革破四旧时,一切封资修的东西都属摧毁之列。仅有的几个古建筑也随着高亢歌声被推倒了。虽然没有了古迹,也看不到美景,但小城有质朴的可爱:有土城墙,有护城河,有黄黄的油菜花,有青青的水稻田,江南的小城,总给人无限的遐想。雨巷的韵味,水乡的特质,这就是我魂梦相萦的小城。

自从上了大学离开小城,一晃三十年了,小城变化之大,让我谅讶。

它已不是我那个小城了。

转载本文请联系原作者获取授权,同时请注明本文来自李维科学网博客。

链接地址:http://blog.sciencenet.cn/blog-362400-383194.html

上一篇:煮饺子的物理学

下一篇:好久没有听到王老师的声音了

当前推荐数:1 推荐人: 唐常杰

文革中看过的书 屏蔽留存

文革中看过的书

屏蔽已有 3427 次阅读 2010-12-14 18:17 |个人分类:江城记事|系统分类:生活其它| 文革, 看书

文革中看过的书

马克思<共产党宣言>

列宁<怎么办>

联共党史

列宁<进一步退二步>

斯大林<社会主义经济问题>

列宁<左派幼稚病>

恩格斯<哥达纲领批判>

中国哲学史

儒法斗争史

法家著作选

毛泽东选集

再版前言(林彪)

鲁迅杂文与小说

鲁迅 中国小说史略

陈望道"修辞学"

吕叔湘"语法修辞讲话"

薄冰"简明英语语法手册"

"赤脚医生手册"

"学习与批判"(杂志)

"参考消息"(报纸)

"简明政治经济学教程"

"九评:南斯拉夫是社会主义国家吗?"

"十万个为什么"

......

小说

艳阳天

金光大道

沸腾的群山

较量

前夕

虹南作战史

牛田洋

春潮急

闪闪的红星

万山红遍

桐柏英雄

碧空雄鹰

向阳院的故事

三探红鱼洞

渔岛怒潮

海岛女民兵

西沙之歌

电影

新闻简报(5年)

海岸风雷(阿尔巴尼亚)

看不见的地平线(阿尔巴尼亚)

地下游击队(阿尔巴尼亚)

多 河之波(罗马尼亚)

南方来信(越南)

买花姑娘(朝鲜)

金姬和银姬的故事(朝鲜)

摘苹果的时候(朝鲜)

列宁在十月(苏联)

列宁在1918(苏联)

奇袭

英雄儿女

地道战

地雷战

南征北战

鸡毛信

以及后来的

青松岭

火红的年代

春苗

红雨

决裂及革命样板戏电影

这些是文革中最流行的小说与电影,其中<前夕>最令我感兴趣,这是文革快结束时出版的,描写中学反资产阶级教育路线方面的书.

~~~~~~~~~~~~~~

暴风骤雨

苦菜花

迎春花

苦斗

三家巷

林海雪原

烈火金刚

红岩

新儿女英雄传

吕梁英雄传

子夜

上海的早晨

红旗谱

红旗飘飘

家

春

秋

大波

青春之歌

平原枪声

铁道游击队

敌后武工队

山乡巨变

创业史

铁木前传

欧阳海

红日

保卫延安

啼笑姻缘

二月

这是文革中禁止但社会上仍能找到且偷偷阅读的文革前解放前小说,其中<青春之歌>最让我激动,

~~~~~~~~~~~~~~~~~~~~

第二次握手

一双绣花鞋

梅花档

少女之心

这是文革中手抄本小说,其中少女之心属于色情类,在当时那个社会中让人心中害怕和无尽遐想

~~~~~~~~~~~~~~~~~~

西游记

水浒

三国

红楼梦

岳飞传

封神演义

说唐

荡寇志

中国古典小说主要就是这几本, 均是繁体字.

~~~~~~~~~~~~~~~~~~~~

外国文学当时也看了点,如

鲁迅译的法捷耶夫的<毁灭>

铁流

牛虻

青年近卫军

高尔基的<母亲>

红与黑

奥斯特洛夫斯基:"钢铁是怎样炼成的"

以及朱可夫回忆录(内部板)

另外早期俄国马克思理论家普列汉诺夫的书也读过

这些构成我们自我"精英"教育的一个部分:忍辱负重,忧国忧民,天下兴亡,匹夫有责。

我们从小受的是精英教育。不说解放全人类的理想,至少也胸怀祖国,放眼世界,物质虽然贫乏,精神上一直有优越感:老觉得天将降大任。很多年过去,当年天马行空一样的凌云壮志,如隔日黄花,半隐半现,似幻似真,让人唏嘘。

-

《江城记事:偷读小说》:

http://www.sciencenet.cn/m/user_content.aspx?id=315145

相关专题:读书荐书

转载本文请联系原作者获取授权,同时请注明本文来自李维科学网博客。

链接地址:http://blog.sciencenet.cn/blog-362400-393557.html

上一篇:煮饺子的物理学

下一篇:《甜甜花絮:白马王子》

当前推荐数:18 推荐人: 武夷山 王晓明 刘全慧 孟津 陈绥阳 王德华 罗帆 傅云义 吉宗祥 吕喆 刘圣林 余昕 赵宇 李泳 曾庆平 王永林 bridgeneer huxuanlai

推荐到博客首页

发表评论评论 (5 个评论)

删除 |赞[5]刘玉仙 2010-12-15 21:10都记得,难得。我只看过第二次握手,对我影响巨大。删除 |赞[4]逄焕东 2010-12-15 17:54U read many books.删除 |赞[3]王德华 2010-12-15 13:45卖花姑娘吧?删除 |赞[2]吕喆 2010-12-14 21:51没少看呀!

有些小说和手抄本好像后来陆续都拍了电影、话剧和电视剧了。删除 |赞[1]曾庆平 2010-12-14 21:47呵呵,我们是同时代的,但没你看得多

【立委兄:二十八天加拿大自驾游 结语】 屏蔽留存

【立委兄:二十八天加拿大自驾游 结语】

屏蔽 |||

【立委按】这篇结语显然是老哥有感而发的由衷之言,也看得出震撼般观感以后的对比和思索。不过,说实话,对于我们在北美讨生活多年的海华,部分观感显得有些表面和肤浅,语气也欠平和沉稳。这其实是很自然的。毕竟是生活在两个世界很多年,观察社会和世界的角度不可能一致。我想是,我可能久入芝兰之室,不闻其香;他也可能乍来枫叶之国,不见其弊。但总体而言,我们有一些关键性的共同观点值得强调:加拿大的确是一个美丽到让人窒息、胸怀宽广、社会和谐的伟大国家。它是我的第二故乡,是我魂萦梦牵的所在。如果一定要在人间寻找天堂,加拿大很有可能高票当选,虽然加拿大的经济并不最强,机会也远没有美国多。

这次去加拿大自驾游,由西向东行程近一万多公里,耗时一余月,穿过加拿大城镇几十个,说到底还是走马观花,蜻蜓点水。当然不可能准确地、完整地、立体地、全面地了解加拿大民情,而且自己缺乏多层次、辩证法、科学观和历史思维的模式,又受自己接触范围和观察水平所限,所以结语与感想这节所述内容不可能是绝对真理。我不能保证我的结语与感想是正确的,正能量的和主旋律的,但我能保证我绝不会弄虚作假,也不会无中生有,它是我有限的信息和知识的结累,是我独立判断与分析的结果,属于阶般性的个人认知和结论。我的所有结语都有依据,我的所有感想都是发自内心的。

加拿大是个伟大的国家,面积很大,人口不多,经济发达,法制建全。空气、阳光与水,一个字:净,是TM的真净。原生态、无污染、原汁原味,当然也包括食品。

税收高,退休晚,福利好,大家特别遵纪守法,人人都愿做志工社工,社会公德意识强烈,宗教、科学、民主、法制和自由是整个社会共奉的核心价值。全社会尊老爱幼,各种族各宗教相互宽容,整个国家有如社会主义理想的再现,实在想不出这是一个没落腐朽的资本主义国家。这是结语。

有关感想,大家别急,请我一一道来。

到加拿大首先感觉环境好,没有那该死的P2.5的烦恼,第二天,我在中国常年发病的鼻炎症状消失了,这可是我在武汉大小医院检查诊治多年不见好转的顽疾。医生一会儿说是过敏性鼻炎,一会儿说是慢性鼻炎,药也没少吃,就是不见好。再就是我久治不愈的胃肠道紊乱消失了,大便通畅了,小便不黄了,在中国,我常年大便不正常,经常腹泻,西药中药都吃过,大小便颜色仍不正常。到了加拿大,不用治疗,全好了。这是加拿大这个国家给我赠送的第一个惊奇。

第二个惊奇是,加拿大的所有居所没有天朝常见的防盗门和铁丝窗,没有小区围墙,每家都靠马路,出入自由,实在不可思议。后来发现,连学校、政府、企业都没有围墙,这说明什么呢?不要小看这个没有围墙的小宅院,说明社会治安好呀,它会给你一份踏实,让你从内心爽快。大家不要认为那一定和中国一样,到处安装监控摄头?不是!是有安装,但真的很少,甚至公路交通监控摄头都安装不多,这让我这个受了几十年正统教育的人惊呆了。贪婪的资本主义制度,腐朽的资产阶级思想,贫困的劳动人民和吸血如鬼的资本家,这样的国度怎么能有比天朝还要好的社会治安呢?没有严酷律令,还能维持社会和谐与稳定,是值得中国学者和当政人物好好思考的。我住在朋友兼向导在郊区的小别墅,一个普通木门,一把小锁,朋友一个月不来一次,但从来没有被盗窃过。我们把从中国带来的大包小包放在屋里,然后去东部玩了一圈,也没不放心,更不担心有人入室行窃,这种心态在国内我从来没有过。因为我们居住的小区,有围墙,有保安,有摄像头,但每年都发生盗窃,去年就我所知有五家被盗,有一家损失惨重,百万财产消失了。

第三个惊奇是,没有网络控制,无须翻墙,可随意看阅祖国任一网站。今天社会是网络社会,出国在外人,网络更显重要。我们可以用微信向国内亲友报平安,发照片,也可以上网了解国内外政治经济状况。制度不自信的加拿大,不害怕它的工人阶级通过网络,向往那令人神往的美好制度,造成人才流失?理论不自信的加拿大,不害怕它的人民通过网络,掌握精神原子弹,造成社会动乱?道路不自信的加拿大,不害怕它的公民通过网络,结聚社会正能量,让人民当家作主?文化不自信的加拿大,不害怕它的组织通过网络,被先进文化俘虏,走向社会的异化?不理解!不明白!加拿大这个充满着多元文化色彩的国度,能如此和谐,实属难得。

第四个惊奇是,在加拿大自驾这么久,走过不同道路,各地的公路车水马龙,但井然有序,也没有人横穿马路,没在路上看到一起交通事故。一个月来唯一一起交通事故还是发生在自己身上,这后面再详谈。而我在中国,只要出去游玩,总能碰到交通事故。要知道加拿大很多高速公路硬件条件不如中国,比如我们走的是5号公路,虽然也叫高速公路,但并不完全封闭。也无中间隔栏,沿途基本没有固定摄像头和测速仪,很多地方只是双向二股道,弯道也多,有很多非立交岔口可以进车,远不如在中国很多省级非高速公路,加拿大高速公里没有规范的服务休息站,有时候一百公里都看不见一个服务区。我们开车的那条高速不少路段,公路车流量也不少,但不论大货车,小轿车速度都很快,包括常见的房车基本都在110或120公里/小时,山区的路能跑这么快,还看不到交通事故,不能不佩服加拿大的交通制度!加拿大人的交通意识很强,那怕再挤,靠里的两人乘坐的专用道再空,也没有人去转道插队。该停的地方一定停下,唯一普遍违规的就是超速。本来加拿大道路限速起点就高,在中国限速六十至九十的,在加拿大一般限速九十以上,而且道路硬件远不如中国限速六十的道路,但加拿人驾车仍在110至120之间,尤其是大货车,开得挺猛。我问过我朋友,他说加拿大警察默许超速,但过了120后,如果抓到,后果也很严重。加拿大很多地方高速没有限速监控摄像,主要靠巡路警察执法,我们开了一天车去珞基山,也没看见一辆巡路警察车,也未看到一起事故,是个奇迹!据说加拿大这种所谓高速公路事故率很低,这让我很困惑了一番。而我们天朝山区高速,比如湖北恩施段,硬件环境比它不知好多少倍,可却限速80或60,还老出事故,真是让人想不通。

第五个惊奇是,加拿大人民真善良,加拿大衙门真亲民。我在加拿大曾经的首都金斯顿Kingston出了一起小事故,在我停车等红灯时,从侧面轻微碰擦了我们车。车主是个年轻妈妈,带着小孩,由于语言不通,沟通十分困难。后来只能求助于多伦多的朋友,作为翻译,双方才明白各自意思。事故发生后,这位女士很友善,不推卸责任,她把车主证,驾驶证和保险凭单让我们拍照,本来这事按当地处理方式就此了结,但这位女士很热心,不放心提出要看看我们租车合同。看后,她告诉我们,合同明确规定在外行驶中,事故不论大小都须报警,並带回当地交警部门责任书,才能理赔。这位女士不顾两个小孩吵闹,立既打了报警电话。警察在电话里说,人手不够,这种小事故不能来现场处理。那位女士马上热心对我们说,她要带我们去警察局报警,并打电话给她丈夫,让他去警察局去接小孩。她拖着两个小孩带我们一起去警察局,真是个活雷锋。到金斯顿警察局,只有一位中年妇女处理交通事故,在等她处理上一起交通事故后,就立马分别给双方车子照像,热情地单独分开询问双方事故发生情况并作笔录。态度极为友善认真,比中国交警处理事故态度要暖心许多,不厌其烦,耐心解释,然后开具责任事故单。唯一缺点是太认真太热情太负责太教条,耗费时间太多。在国外出事故是最麻烦的,我们深有体会,一直到旁晚才了结这个案件。加拿大人民真善良,在这次出行中我们常常感受到这种温暖。比如在皇家山公园停车场,素不相识人把停车位让出后,还没已交停车费尚未到时间的停车票一并赠送;比如在行驶路,总有热情人热心指路,耐心解答我们询问。总之,富裕的加拿大人善良、朴实、热情。

第六个惊奇是,加拿大把信用看得很重,信用是他们立国之本。宾馆退房不查房,也没押金。大家都会按次序排队,绝没有插队加塞的行为。这里的商场货真价实童叟无欺,你在这里买东西心里觉得踏实,不用担心商品质量和被欺骗。人们都很文明,没见过随地吐痰的。记得我们去魁北克市那一家汽车旅馆----谢瓦利埃汽车旅馆 Motel Chevalier时,没有一个工作人员,门口有一张留言条,告诉我们房间钥匙在门口小箱子里,可自取自住。第二天退房也没人,只叫把钥匙丢进小箱子里就可走人,这在中国是无法想象的。到各个公园,有部分也需购票,但没人管靠自觉。地铁站只有一位售票员,没见其他工作人员,门也敞开,买票也靠自觉。当然有抽检的,据说查到后信用会受损,但并不频繁抽捡,我一次没碰到过,但也几乎没见到人逃票。

第七个惊奇是,加拿大社会保险体系涵盖广泛,社会福利倾斜贫困者,关心弱势群体成了风尚。服务员、清洁工、木工、水道工、电工,报酬不低,干起来没有低人一等的感觉。我行走加拿大一余月,只在温哥华市加拿大广场碰到一个乞讨者,很是不相信。我朋友告诉我加拿大还是有一些无家可归者,但是政府很关心他们。我这位朋友Max每周都去做义工,照顾无家可归者,对这方面情况相对熟悉。他告诉我们,照顾无家可归者场所实施非常不错,伙食也好。他每周过去就是给他们做甜点,不少无家可归者以此为家,白天出去,傍晚回来,不受限制,不管来历。费用主要是政府拔款和个人捐助,食品都十分新鲜卫生也很可口。有时食品剩多了,他们也带点回家,小孩特别喜欢吃。一个代表资产阶级利益,受寡头资本操纵控制的政府对自己压迫的阶级仍能这么细心周到,是某些理论无法自说其圆的。

我一余月在加拿大唯一见到的一个无家可归者,温哥华加拿大广场:

第八个惊奇是,加拿大农民真幸福。这次自驾游,从西到东,在加拿大广阔田野里奔驰,所见所看,没有发现破旧房屋,最起码从表面看,农民生活很富足。没有地主也没有贫农,大家都是农场主。和中国农民不一样,他们不是农民工,不是弱势群体,更不是收入低,生活苦的代名词。说是农村,给人的感觉蛮现代化的,他们生活也是高品质的。农村住宅各具特色且体量较大,房前屋后是草坪、鲜花、树林,还有汽车、拖拉机和游艇,不是别墅胜似别墅,内部装饰也干净明亮卫生和舒心,更没有在中国农村常见的鸡鸭、农具、柴草。比我们的社会主义新农村建设更合理,更有美丽乡村味道。就居住条件、生活品质而言,在加拿大说不准已没有比农民更好的了。不知道在加拿大农村,还有没有阶级斗争?但贫下中农是绝对绝迹了,这是不争的事实。

第九个惊奇是,加拿大让不少中国人失望,这里没有国内丰富的娱乐活动。在祖国大地遍布的冼脚城、桑拿房、美发室、夜总会,在这里很难寻觅到。更没有我们文学作品中描述的灯红酒绿的景致。这里一切平淡如水,波澜不惊。有些国内来的人,会非常失望,这里太不热闹,太安静,太讲人权了。加拿大虽是世界上最富有的国家之一,但没有土豪金的嚣张跋扈,暴发户的醉生梦死,不论富人穷人,还是中产阶级,都十分喜爱徒步,划船,滑雪这类活动。人们生活健康,情趣高雅,而且人际关系也简单许多,没有国内那种压力与压抑。恕我眼拙,实在看不出腐朽没落垂死的资本主义即帝国主义的一丝征兆来。对不起胸怀祖国放眼世界解放全人类的中国无产阶级的广大革命群众,你们臆想的帝国主义丑陋就如你们臆想的自己已当家作主一样,我仔细观察,证据实难搜索到。

一个月时间十分短暂,看到的也不一定是真实深刻的,但这次旅途给我触动很大,所见所闻再次引起了我的思考。过去给我们的那些教育是否过于偏执?资本主义也在改革,也在自我完善,它们在发展过程中形成了一套良性的运行体系,值得我们好好研究。加拿大的先进经验我们要学习。科技在发展,世界又不大,我们都生活在这个地球村上。争斗归争斗,冲突归冲突,但大家也有必要为人类共同面对的问题,精诚合作,一起破解,如果地球毁了,争个意识形态的是非又有什么意义?

经过这次短暂而又深刻的游历,我开阔了眼界,增长了见识,看到了差距,收获是大大地,体会是深深地。我决定:生命不息,探索不止,游历不停。

【相关】